服务器w2为何无法连接互联网?

- 行业动态

- 2024-10-07

- 5

服务器W2无法上网的问题可能由多种原因引起,以下是一些常见的原因及其解决方法:

网络连接问题

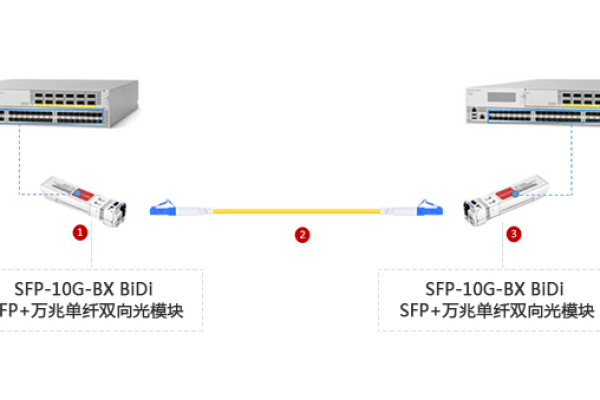

1、网线连接不正常:

检查服务器W2的网络电缆是否牢固连接到网络交换机或路由器的端口上。

确保电缆没有损坏或插入不正确。

2、网卡故障:

服务器的网卡可能存在故障,如硬件损坏或驱动程序问题。

尝试更换网卡或更新网卡驱动程序。

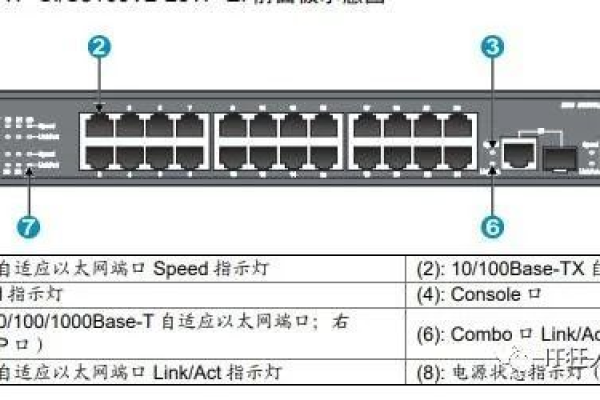

3、路由器设置问题:

检查路由器的状态,确保设备正常工作且端口未被禁用。

重启路由器或重新配置其设置。

IP地址配置问题

1、IP地址冲突:

服务器的IP地址可能与其他设备冲突,导致无法与互联网通信。

检查并更改服务器的IP地址,确保其在网络环境中唯一。

2、子网掩码和默认网关错误:

确认服务器的子网掩码、默认网关等配置正确无误。

通过运行ipconfig(Windows)或ifconfig(Linux)命令查看当前的网络配置。

DNS配置问题

1、DNS设置错误:

如果服务器无法解析域名或访问网站,可能是由于DNS设置问题。

尝试使用其他公共DNS服务器,如谷歌的8.8.8.8和8.8.4.4。

防火墙或安全策略问题

1、防火墙规则阻止:

检查服务器上的防火墙规则或安全策略,确保没有阻止特定的网络流量。

修改防火墙规则以允许必要的网络连接。

2、NAT规则配置错误:

如果服务器位于私有网络中并使用NAT,确保NAT规则正确配置,以便允许服务器的出站连接。

系统设置问题

1、操作系统或网络配置影响:

某些操作系统或网络配置可能影响服务器的网络连接。

检查操作系统的网络设置,包括网络配置文件、服务状态等。

资源限制问题

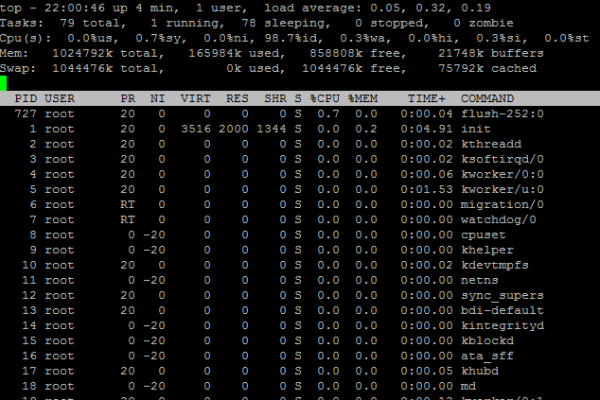

1、资源耗尽:

服务器可能在运行过程中出现频繁上网的问题,导致无法达到极限。

检查服务器的CPU、内存和磁盘占用情况,确保没有达到极限。

其他可能原因

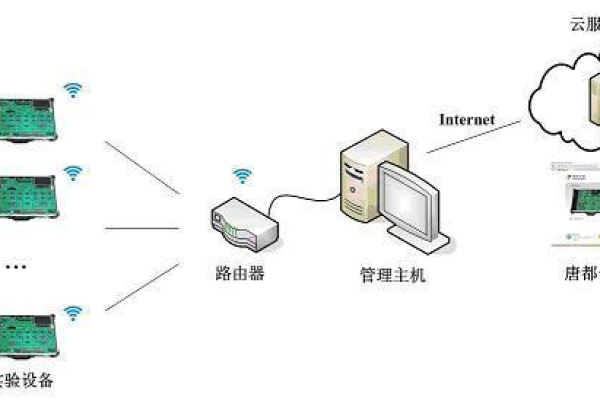

1、代理服务器问题:

如果服务器的网络连接通过代理服务器,那么代理服务器的配置可能存在问题。

检查代理服务器的设置,确保配置正确。

2、软件或服务配置问题:

服务器上安装的某些软件或服务可能存在配置问题,导致无法正常使用网络功能。

检查相关软件或服务的配置,修复配置问题。

服务器W2无法上网的原因可能涉及多个方面,包括网络连接、IP地址配置、DNS设置、防火墙规则、系统设置、资源限制以及代理服务器和软件配置等,在排查和解决问题时,建议按照上述步骤逐一检查和调整,以找到根本原因并解决上网问题,如果问题仍然存在,可能需要联系专业的网络技术支持进行深入分析和解决。

【为什么所有服务器W2不能上网】

可能原因分析

1、网络连接问题

服务器W2的网络设备(如路由器、交换机)故障或配置错误。

网络线路中断或损坏。

服务器W2的网络接口卡(NIC)故障。

2、服务器配置问题

服务器W2的IP地址配置错误或与网络冲突。

DNS服务器配置错误,无法解析域名。

防火墙规则设置不当,导致网络访问被限制。

3、软件或系统问题

操作系统或服务软件故障。

系统文件损坏或缺失。

软件冲突或资源占用过高。

4、网络安全问题

服务器W2被反面攻击,导致网络连接中断。

网络设备或线路被改动或破坏。

排查步骤

1、确认网络连接

检查服务器W2的网络设备是否正常工作。

使用ping命令测试服务器与网关、DNS服务器的连通性。

2、检查服务器配置

检查服务器W2的IP地址、子网掩码、默认网关和DNS设置是否正确。

检查防火墙规则,确保没有阻止网络访问。

3、检查软件和系统

检查操作系统和服务器软件是否正常运行。

检查系统文件是否完整,如有损坏,尝试修复或重装。

4、检查网络安全

检查服务器W2是否遭受反面攻击,如DDoS攻击。

检查网络设备或线路是否被改动或破坏。

解决方案

1、网络连接问题

修复或更换网络设备。

重新布线或联系网络运营商检查线路。

2、服务器配置问题

修正IP地址、子网掩码、默认网关和DNS设置。

调整防火墙规则,允许必要的网络访问。

3、软件或系统问题

重启服务器,尝试恢复服务。

修复或重装操作系统和服务器软件。

4、网络安全问题

加强网络安全防护,如设置防火墙、安装杀毒软件。

检查网络设备或线路,修复或更换损坏的部分。