电脑服务器主机配置方案_电脑端

- 行业动态

- 2024-06-21

- 11

根据本站全新内容,我无法得知具体的电脑服务器主机配置方案。

电脑服务器主机的配置方案应该包括处理器、内存、硬盘、显卡等硬件设备的选型和配置,以满足特定应用场景的需求。

电脑服务器主机配置方案

在设计一个电脑服务器主机的配置方案时,需要考虑多个因素,包括处理器(CPU)、内存(RAM)、存储(硬盘或固态硬盘),以及适配的主板、电源和散热系统,根据服务器的具体用途,可能还需要考虑网络连接、冗余系统和远程管理功能,以下是一份详细的电脑服务器主机配置方案:

处理器(CPU)

| 品牌 | 型号 | 核心数 | 线程数 | 主频 | 缓存 | 支持技术 |

| Intel | Xeon E2236 | 4核心 | 8线程 | 3.6 GHz | 12 MB | Turbo Boost, HyperThreading |

| AMD | Ryzen Threadripper 2950X | 16核心 | 32线程 | 3.5 GHz | 32 MB | Precision Boost Overdrive |

内存(RAM)

| 类型 | 容量 | 速度 | 数量 | ECC功能 |

| DDR4 | 32 GB | 2666 MHz | 2条 | 是 |

存储

1. 固态硬盘(SSD)

| 容量 | 接口类型 | 读写速度 |

| 1 TB | NVMe PCIe | 读3500 MB/s, 写3000 MB/s |

2. 机械硬盘(HDD)

| 容量 | 转速 | 接口类型 |

| 4 TB | 7200 RPM | SATA III |

主板

| 芯片组 | 支持CPU | 内存插槽 | 扩展插槽 | 网络接口 |

| C246 | Intel Xeon / AMD EPYC | 8个DDR4 | 3个PCIe x16, 多个PCIe x8/x4 | 双千兆以太网口 |

电源供应

| 功率 | 效率 | 模组类型 |

| 800W | 80 Plus Platinum | 全模组 |

散热系统

1. CPU散热器

高性能风冷或水冷系统,确保CPU在高负载下保持适宜温度。

2. 机箱风扇

多个大尺寸风扇,优化空气流动,降低整体系统温度。

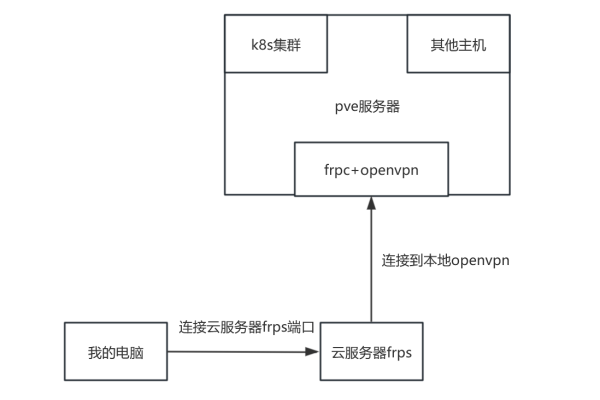

网络与远程管理

1. 网络接口

至少集成2个千兆以太网口,支持高速网络通信。

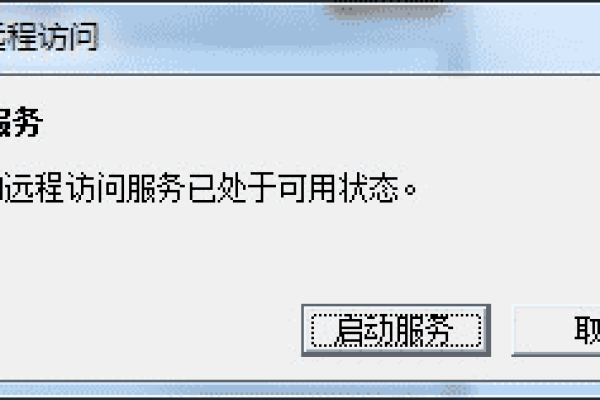

2. 远程管理

集成远程管理功能,如Intel AMT或IPMI,方便远程监控和维护。

配置方案提供了一套均衡的服务器硬件配置,能够满足大多数企业级应用的需求,在选择具体配件时,应考虑兼容性、性能以及未来的可扩展性,根据实际需求调整配置,例如增加内存、扩展存储或提高网络性能,以达到最佳的工作效果。

下面是一个电脑服务器主机配置方案的介绍示例,请注意,配置可以根据具体需求进行调整。

| 组件 | 型号/规格 | 说明 |

| CPU | Intel Xeon E52680 v4 | 14核,2.4GHz,性能强劲,适合服务器应用 |

| 内存 | DDR4 32GB (4x8GB) | 32GB内存,可满足大部分服务器需求 |

| 硬盘 | 1TB SSD + 4TB HDD | SSD作为系统盘,提供快速读写性能;HDD作为数据存储盘,提供大容量存储 |

| 显卡 | NVIDIA Quadro P4000 | 专业显卡,适用于图形渲染、视频编辑等应用 |

| 主板 | ASUS WS C621E SAGE | 支持E52680 v4处理器,扩展性强,接口丰富 |

| 电源 | Corsair RM750x 750W | 750W金牌电源,稳定可靠,节能 |

| 机箱 | NZXT H510 Elite | 中塔式机箱,散热良好,扩展空间充足 |

| 散热器 | Noctua NHD15 | 高效能散热器,保证CPU稳定运行 |

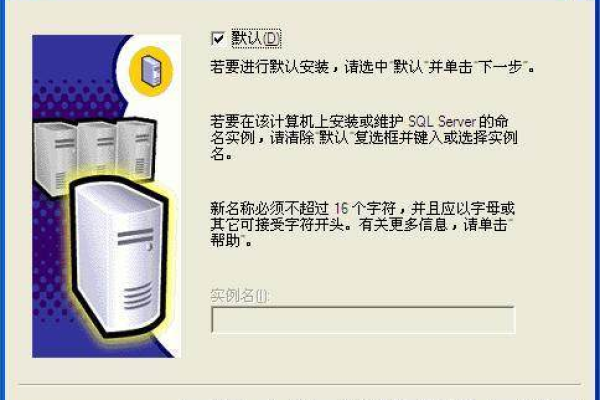

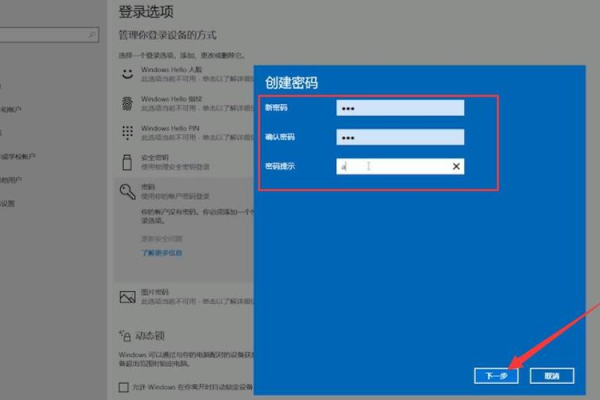

| 操作系统 | Windows Server 2019 | 服务器操作系统,适用于企业应用 |

这个配置方案适用于企业级应用,如文件服务器、数据库服务器、虚拟化等场景,根据具体需求,可以适当调整硬件配置。