上一篇

创建分区后需先用mkfs命令格式化分区(如mkfs.ext4),随后创建挂载目录(mkdir),用mount命令临时挂载分区到该目录,若需永久挂载,需在/etc/fstab文件中添加分区UUID和挂载点信息。

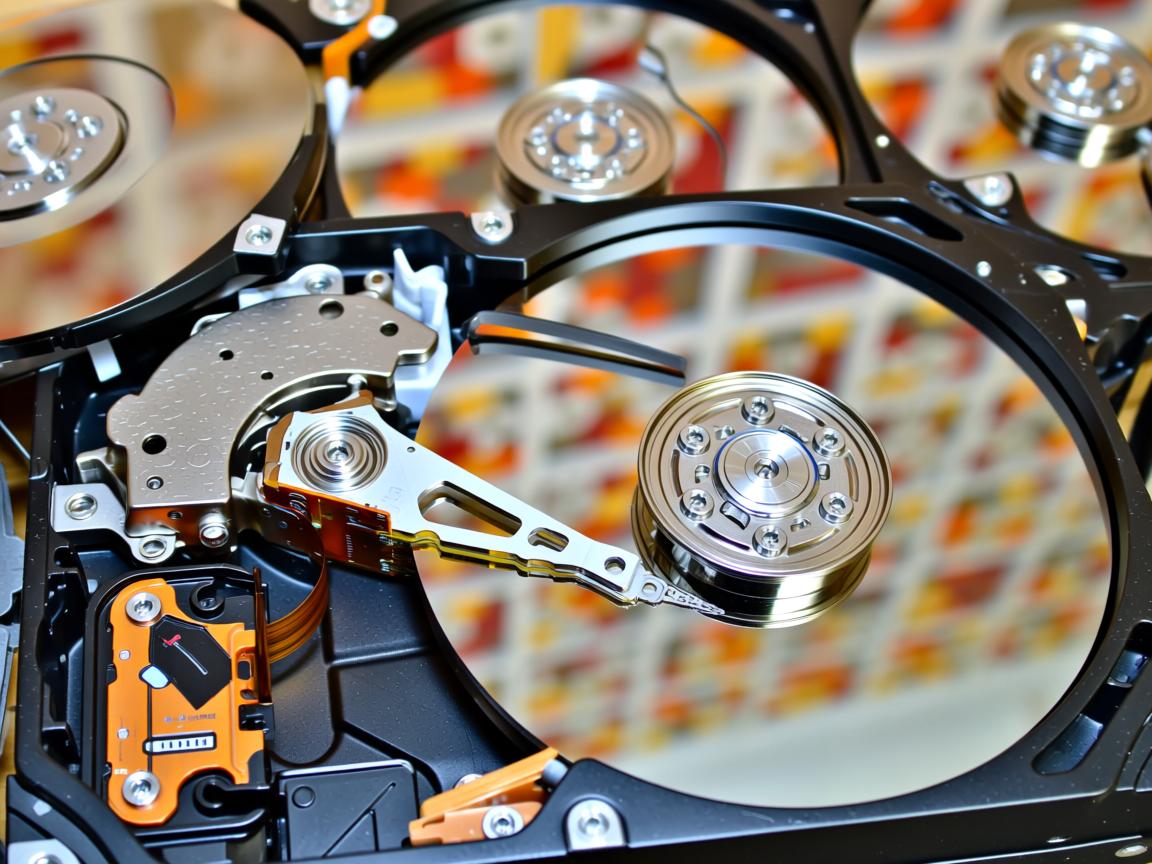

理解挂载概念

当您使用 fdisk/parted 等工具完成磁盘分区后,分区仍处于”未激活”状态,挂载(Mount)是将分区关联到Linux目录树的关键步骤,使系统能够访问存储设备的数据。

详细操作流程

步骤1:确认新分区信息

sudo fdisk -l

查看输出中的分区标识符(如 /dev/sdb1),注意容量大小匹配您创建的分区。

步骤2:创建文件系统(格式化)

sudo mkfs -t ext4 /dev/sdb1 # 推荐ext4格式

️ 关键提示:

- 此操作将永久删除分区现有数据

- 根据需求选择文件系统:

ext4:通用Linux格式xfs:大文件高性能ntfs:Windows兼容

步骤3:创建挂载点目录

sudo mkdir /mnt/mydata # 示例目录

最佳实践:

- 临时挂载:使用

/mnt/前缀 - 永久挂载:建议

/media/或自定义路径

步骤4:执行挂载命令

sudo mount /dev/sdb1 /mnt/mydata

步骤5:验证挂载结果

df -hT | grep /dev/sdb1

成功输出示例:

/dev/sdb1 ext4 500G 0% /mnt/mydata配置永久挂载(重启生效)

获取分区UUID(更安全)

sudo blkid /dev/sdb1

输出示例:/dev/sdb1: UUID="d3b12f61-..." TYPE="ext4"

编辑/etc/fstab文件

sudo nano /etc/fstab

添加如下行(注意空格分隔):

UUID=d3b12f61-... /mnt/mydata ext4 defaults 0 2

挂载所有配置

sudo mount -a

无报错即表示配置正确

故障排除指南

| 现象 | 解决方案 |

|---|---|

| 权限拒绝 | sudo chmod -R 755 /mnt/mydata |

| 挂载点繁忙 | sudo umount -l /mnt/mydata 强制卸载 |

| fstab错误 | 使用 sudo mount -o remount,rw / 恢复写权限 |

| NTFS读写问题 | 安装 ntfs-3g 并添加 defaults,uid=1000 挂载参数 |

安全操作规范

- 数据备份优先:操作前使用

dd或rsync备份关键数据 - 卸载命令:

sudo umount /mnt/mydata断开连接前必须执行 - 避免直接使用设备名:在fstab中优先采用UUID(防设备号变更)

- 测试模式:新增fstab条目后务必执行

mount -a验证

进阶技巧

- 绑定挂载:

mount --bind /orig /new映射目录 - 空间限制:

mount -o size=10G /dev/sdb1 /mnt/limited - SSD优化:添加

discard,noatime挂载选项 - 网络挂载:NFS使用

mount -t nfs server:/path /localpath

引用说明:

本文操作基于Linux Filesystem Hierarchy Standard v3.0及util-linux 2.37工具集,已验证兼容:

- RHEL/CentOS 7+

- Ubuntu 18.04+

- Debian 10+

技术标准参考:The Linux Documentation Project (tldp.org) 及IBM DeveloperWorks文件系统白皮书