大数据复杂性_大容量数据库

- 行业动态

- 2024-06-21

- 4951

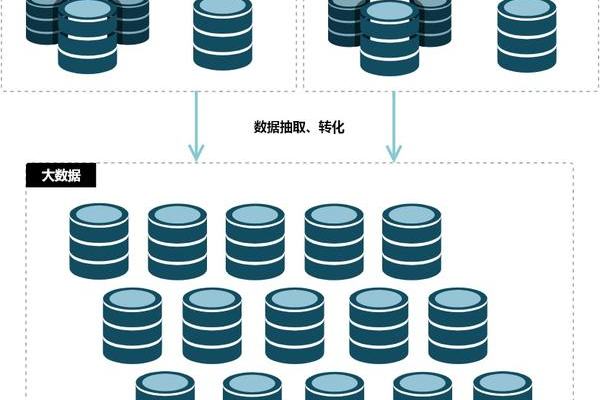

大数据的复杂性主要体现在处理大容量数据库时的挑战,包括数据存储、管理、分析和提取有用信息。随着数据量的增加,确保数据处理的效率和准确性变得至关重要。

大数据复杂性与大容量数据库

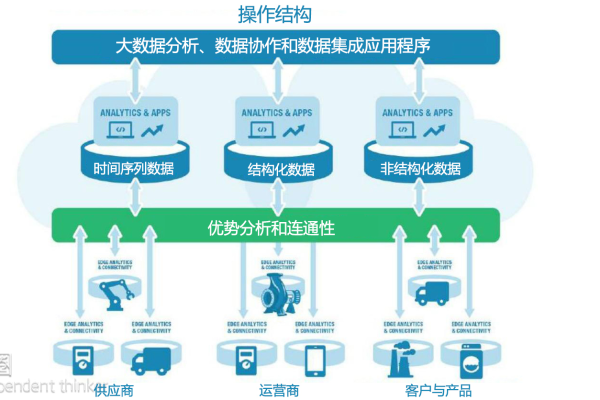

在信息时代,数据量呈指数级增长,企业和组织需要处理和分析的数据量越来越大,这给传统的数据处理和存储方法带来了挑战,大数据的复杂性不仅体现在数据量上,还体现在数据的多样性、速度(实时性)、可变性等方面,大容量数据库是应对这些挑战的关键工具之一。

大数据的五个V特性

1、Volume(容量) 指的是数据的规模巨大,从TB到PB级别。

2、Variety(多样性) 数据类型多样,包括结构化数据、半结构化数据和非结构化数据。

3、Velocity(速度) 数据生成和处理的速度要求极高,需要支持实时或准实时处理。

4、Veracity(真实性) 数据的准确性和可信度问题。

5、Value(价值) 如何从大量数据中提取有价值的信息。

大容量数据库的挑战

存储挑战:需要存储海量数据,对存储系统的扩展性和成本效率提出了高要求。

性能挑战:查询响应时间要快,尤其是在高并发环境下。

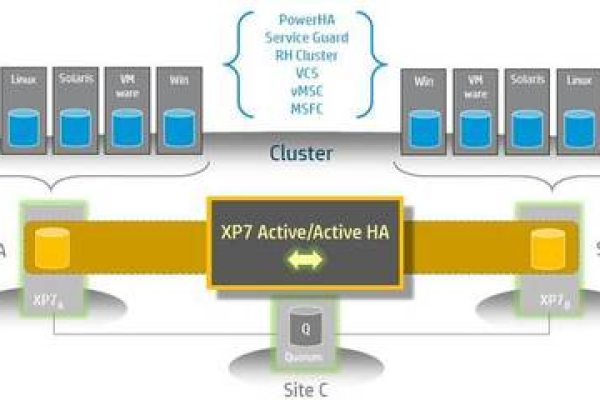

数据一致性和可靠性:保证数据的准确性和完整性,特别是在分布式系统中。

数据安全:保护数据不被未授权访问和防止数据泄露。

数据整合:将来自不同源的数据整合到一个统一的视图中。

大容量数据库的类型

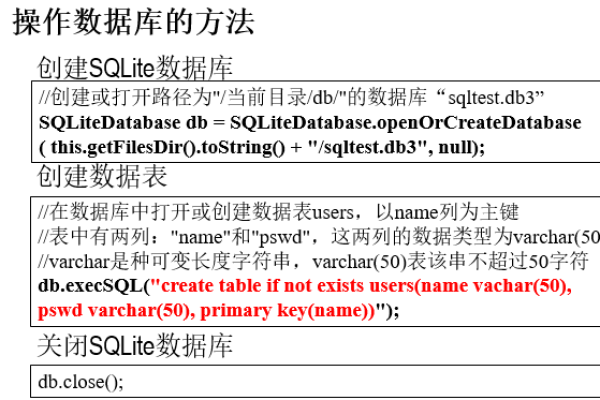

关系型数据库(RDBMS):如Oracle, MySQL, PostgreSQL等,适合结构化数据存储。

NoSQL数据库:如MongoDB, Cassandra, HBase等,更适合非结构化和半结构化数据。

新型数据库:如Google BigTable, Amazon DynamoDB等,专为大数据设计。

解决方案和技术

分布式存储系统:如Hadoop HDFS,提供高容错性的分布式存储解决方案。

数据湖:集中存储所有类型的原始数据,支持大规模数据分析。

云存储服务:如AWS S3, Google Cloud Storage等,提供可扩展的存储解决方案。

内存计算:如Apache Spark,提高数据处理速度。

数据仓库:如Amazon Redshift, Google BigQuery,优化数据分析查询性能。

最佳实践

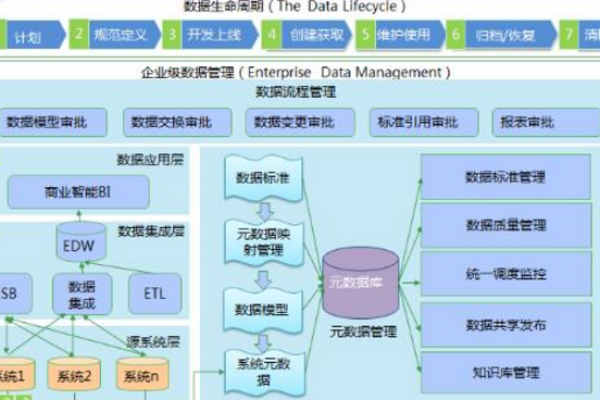

数据治理:建立严格的数据管理政策和流程,确保数据质量和安全。

性能优化:通过索引、分区、缓存等技术提高查询性能。

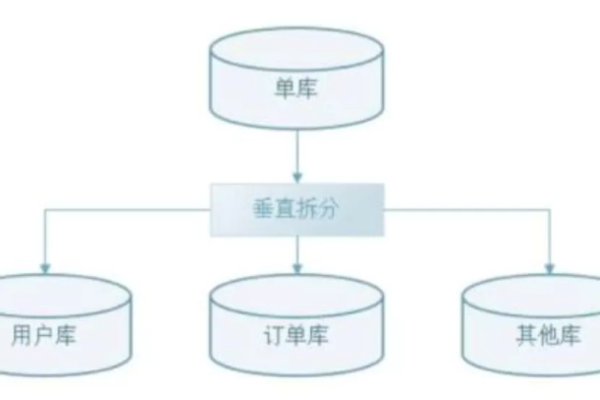

可扩展架构:采用模块化、微服务架构,便于系统扩展和维护。

定期审计和监控:监控系统性能和数据质量,及时调整策略。

大容量数据库是应对大数据挑战的关键工具,选择合适的数据库类型和架构,结合先进的技术和最佳实践,可以有效管理和分析海量数据,为企业带来洞察和价值,随着技术的不断进步,大容量数据库和相关技术将继续发展,以更好地满足未来的数据处理需求。

| 序号 | 数据复杂性描述 | 大容量数据库应对策略 |

| 1 | 海量数据存储与管理 | 采用分布式存储技术,如Hadoop、Spark等 |

| 2 | 复杂的数据结构 | 使用NoSQL数据库,如MongoDB、Cassandra等 |

| 3 | 高并发访问与实时数据处理 | 采用内存数据库,如Redis、Memcached等 |

| 4 | 多维度数据分析与报表展示 | 使用数据仓库,如Hive、Greenplum等 |

| 5 | 数据安全性与隐私保护 | 实施数据加密、访问控制、审计等安全策略 |

| 6 | 数据一致性、完整性与可靠性 | 采用分布式事务管理、数据备份与恢复技术 |

| 7 | 大规模数据迁移与整合 | 使用数据迁移工具,如Apache Sqoop等 |

| 8 | 高性能计算与查询优化 | 采用并行计算、索引、缓存等技术 |

| 9 | 复杂的业务逻辑与流程管理 | 使用工作流引擎、规则引擎等 |

| 10 | 多源异构数据集成与融合 | 采用数据集成工具,如Apache Nifi等 |

这个介绍简要描述了大数据复杂性及大容量数据库在面对这些挑战时的应对策略,实际应用中,需要根据具体业务场景和需求来选择合适的解决方案。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/176336.html