普通云服务器_专属主机与普通云服务器的区别?

- 行业动态

- 2024-07-08

- 4

【普通云服务器_专属主机与普通云服务器的区别?】

普通云服务器和专属主机在多方面存在显著差异,这些差异主要体现在资源独享、性能稳定性以及安全隔离性等方面,具体如下:

1、资源独享性

专属主机:提供完全的资源独享,用户拥有整台物理服务器的所有资源,无需与其他用户共享,这种独享环境确保了服务器的计算能力、内存和存储空间可以完全用于支持用户的特定需求。

普通云服务器:资源在多个用户之间共享,虽然云服务商通常会提供资源隔离保证每个用户服务质量,但在高负载时段,共享资源可能导致性能波动。

2、性能稳定性

专属主机:由于资源的独享,专属主机能够提供更稳定和可靠的性能,这对于需要处理高流量或执行高强度计算任务的应用来说尤为重要。

普通云服务器:尽管现代云计算技术已经能够很好地平衡多租户环境下的资源使用,但在一些极端情况下,仍然可能出现因资源共享而导致的性能不稳定现象。

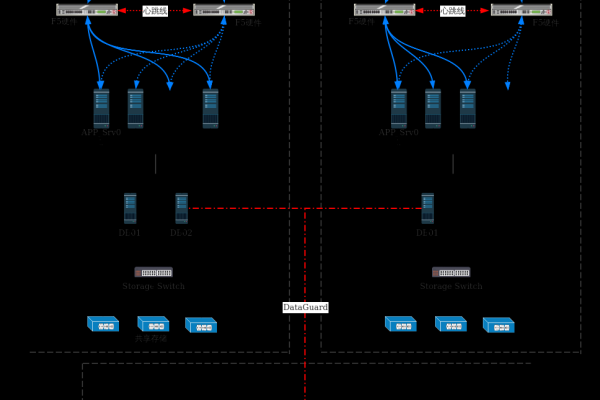

3、安全隔离性

专属主机:专属主机因其物理上的独立性,为用户提供了更高级别的安全保障,这种物理隔离减少了与其他用户的数据交叉风险,更适合处理敏感或需要高度保密的数据。

普通云服务器:虽然云服务商提供了多种安全措施来保护数据安全,如加密技术和访问控制,但由于硬件资源的共享,理论上普通云服务器的安全隔离性较专属主机为低。

4、成本考量

专属主机:通常情况下,由于提供专用资源和更高的服务水准,专属主机的成本高于普通云服务器,这使得它更适合对性能和安全性有高要求且预算较为充足的用户。

普通云服务器:较低的成本是普通云服务器的一大优势,它适合初创企业或预算有限的项目,以及对性能要求不是特别高的普通应用。

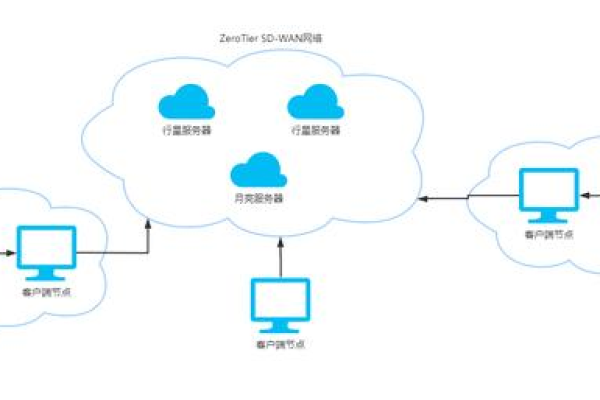

5、灵活性与扩展性

专属主机:专属主机通常提供多种配置选项,购买过程灵活,可以根据用户需求进行个性化定制,物理限制可能使得扩展性不如基于虚拟化技术的云服务器。

普通云服务器:云计算的本质使得它在灵活性和扩展性方面表现出色,用户可以快速调整资源配置,以应对突发的业务需求变化。

针对上述分析,提出以下几点建议:

对于数据密集型或高计算需求的应用场景,专属主机是更优选择。

对于初创企业或中小型项目,考虑成本因素,可以选择普通云服务器起步,随着业务发展逐步升级至专属主机。

在选择服务提供商时,应考虑其技术支持和服务级别协议(SLA),以确保业务连续性和数据安全。

可以看到专属主机与普通云服务器各有千秋,专属主机在资源独享、性能稳定性、安全隔离性上具有明显优势,而普通云服务器则在成本效益和灵活性上表现更为突出,根据具体的业务需求和预算安排选择适合的服务器类型至关重要。