移动校园卡是否提供流量服务?

- 行业动态

- 2024-09-18

- 8

关于移动校园卡流量卡,我们可以从其、费用计算以及适用场景等方面进行了解,以下将具体介绍这一服务于学生群体的移动通信产品:

1、

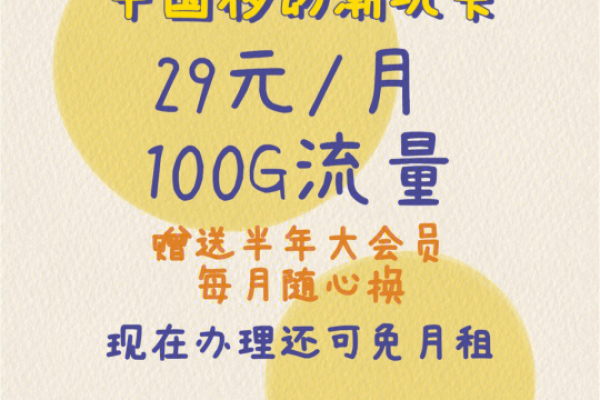

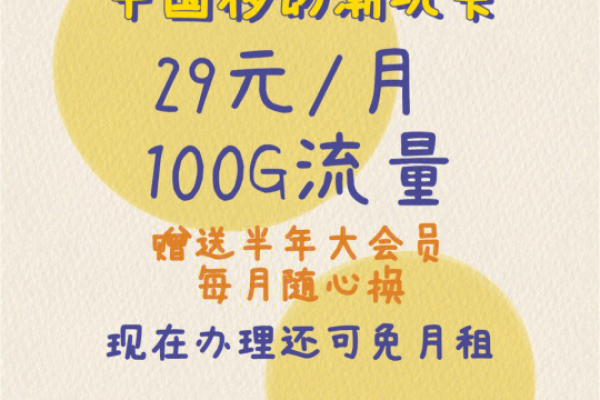

基本套餐构成:移动校园卡的基本月租费通常较低,例如某些地区的移动校园卡月租费为19元,其中包含了一定量的校园区域和定向流量,如30G。

流量与通话:除了基础的流量,移动校园卡还提供了额外的语音通话分钟数,有的版本包含100分钟的语音通话时间。

2、费用计算

超出部分计费:一旦用户使用流量超过套餐所提供的部分,移动校园卡通常会按照一定的费率进行计费,比如按照1元/1G的数据流量费用计收。

通话费用:对于超出套餐内含的通话时长,也将单独计费,例如以0.19元/分钟的费率计收国内电话费用。

3、适用场景

学生需求定制:移动校园卡特别适用于经常需要上网课或是使用大量数据流量的学生群体,由于疫情等原因,线上学习变得更加普遍,这种卡片因其高额流量而受到欢迎。

校园区域优惠:部分移动校园卡设计了校园区域内更优惠的数据处理方案,这使得在校园内使用网络服务更为经济。

4、激活与充值

激活流程:用户在选择并办理了移动校园卡后,通常需要进行激活,并根据具体套餐要求进行初次充值,如充值100元领取额外的流量和语音优惠。

充值优惠:通过激活和充值,用户可以获得额外的流量或语音通话时间,这有助于降低长期的使用成本。

5、办理步骤

官方网站操作:用户可以通过访问中国移动的官方网站进行在线申请和办理,过程中需要填写个人信息并选择相应的套餐类型。

6、使用攻略与优惠活动

节省费用的策略:了解如何最大化移动校园卡的流量使用,参与各种优惠活动可以进一步降低费用,同时利用校园网络热点也可以节约数据使用。

为了更好地帮助用户了解和使用移动校园卡,以下是相关问题与解答部分:

1、问:移动校园卡是否只限于在校园内使用?

答:不是的,虽然移动校园卡提供了校园区域内的特殊优惠,但它同样支持全国范围的使用,这使得学生不论是在校内还是校外都能享受到方便的通信服务。

2、问:移动校园卡的流量可以共享给其他号码使用吗?

答:通常情况下,移动校园卡的流量是不可以共享给其他号码的,它主要是为了单一用户的使用而设计,特别是针对学生用户的需求,如果需要共享数据,可以考虑其他的家庭套餐或团体套餐。

移动校园卡作为一种专为学生设计的通信产品,不仅提供了大量的数据流量和合理的通话时长,还通过低月租和丰富的激活优惠政策吸引了广泛的学生用户,通过合理利用这些资源,学生可以在学习和日常生活中享受到极大的便利和经济效益。