杭州独立服务器的网络环境如何?

- 行业动态

- 2024-07-13

- 7

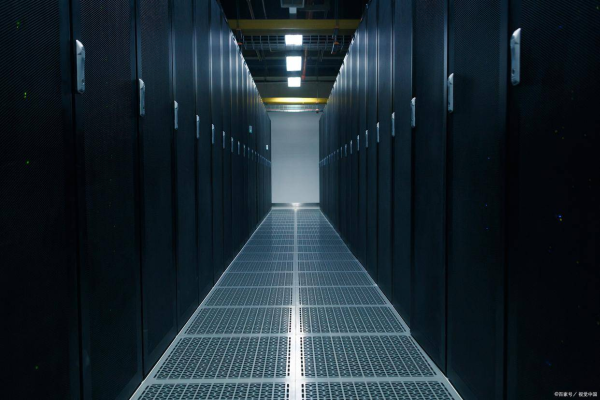

杭州的网络环境在国内属于先进水平,独立服务器在该地区运行的网络环境通常具有高带宽、低延迟和稳定的连接质量,该市的网络基础设施完善,带宽资源充足,能够为服务器稳定运行提供坚实支撑。

杭州独立服务器的网络环境具备多方面的优势,主要体现在以下几个方面:

1、网络资源丰富:

杭州拥有丰富的网络基础设施,包括高速光纤网络和多个数据中心。

带宽资源充足,可支持大数据量传输和高并发访问。

2、地理优势显著:

杭州位于长三角经济圈核心位置,与多个主要经济城市如上海、苏州紧密相连,形成高效的经济合作圈。

优越的地理位置为服务器提供了稳定的物理环境和便捷的连接性。

3、服务商选择多:

杭州有众多专业的服务商提供优化服务,例如CDN加速和数据库性能优化等。

这些服务商的存在保障了服务器性能和网站访问速度的优化。

4、用户体验提升:

选择当地服务器可以显著降低延迟,提高访问速度,从而提升用户体验。

对于面向最终用户服务的企业和开发者来说,这是增强竞争力的关键因素。

5、业务需求匹配:

企业应根据自己的业务需求,选择符合自己业务规模的服务器类型和配置。

杭州的服务器市场提供了多样化的选择,满足不同规模和类型业务的需求。

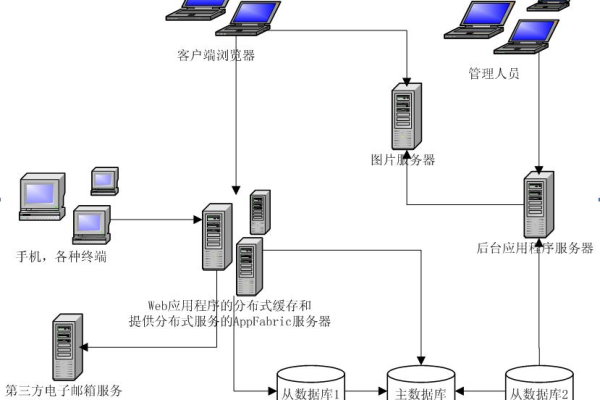

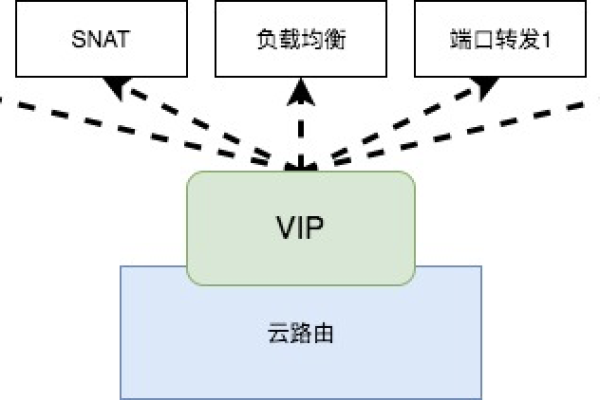

6、自定义拓扑:

独立服务器允许用户拥有一览无余的控制权,实现自定义网络拓扑的无限可能。

这意味着企业可以根据具体需求,配置专属的网络架构和安全策略。

7、稳定性与安全性:

独立服务器的稳定性和安全性高于共享主机,因为用户不需要与他人共享服务器资源。

这有助于保护数据安全,并且能够及时对服务器进行维护和升级。

8、经济合作圈效应:

杭州作为长三角经济圈的一部分,与其他主要城市形成了紧密的经济合作关系。

这种区域合作为数据流通和信息交换提供了便利,促进了商业活动和技术创新。

杭州独立服务器的网络环境得益于当地发达的网络基础设施和优越的地理位置,不仅保证了连接速度和稳定性,而且通过专业服务商的支持,进一步提升了服务器的性能和网站的访问体验,对于追求高性能和高稳定性的企业及开发者而言,在杭州部署独立服务器是一个值得考虑的选择。