qq为什么搜索群聊搜不到

- 行业动态

- 2024-05-20

- 9

QQ搜索群聊失败的可能原因

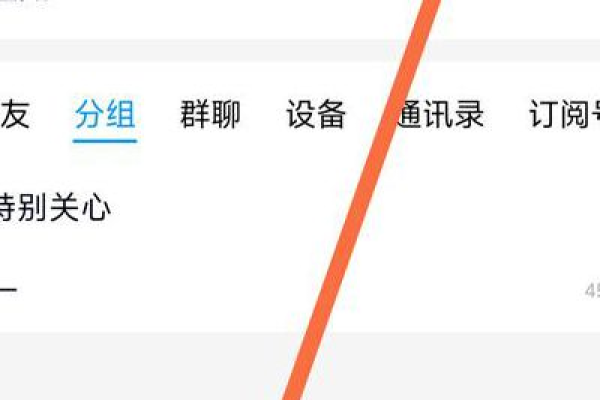

使用腾讯QQ进行社交时,群聊功能是用户常用的一个选项,但有时用户可能会遇到无法通过搜索找到特定群聊的情况,以下是一些可能导致搜索不到QQ群聊的原因:

1、关键词匹配问题:输入的搜索关键词可能与群聊名称不完全匹配,QQ搜索功能通常要求关键词和群名称有较高的匹配度才能显示结果。

2、群设置隐私:有些群主为了保护群成员的隐私,会将群设置为不可搜索,在这种情况下,即使输入正确的群名,普通用户也无法通过搜索找到该群。

3、账号权限限制:部分账号可能因为违反了QQ的使用规则而受到限制,这可能会影响搜索群聊的功能。

4、网络或系统问题:网络连接不稳定或者QQ软件本身存在bug也可能导致搜索功能异常。

5、版本更新:如果QQ客户端版本过旧,可能不支持某些新的搜索算法或功能,建议检查是否有新版本更新。

6、缓存问题:有时候QQ客户端的缓存数据可能会导致搜索功能出现错误,清理缓存后重新启动QQ可能解决问题。

7、敏感词过滤:如果搜索的关键词包含系统认定的敏感词汇,搜索结果可能会被屏蔽。

8、设备兼容性问题:在不同的设备上,尤其是移动设备和PC端,搜索功能的实现机制可能存在差异,导致搜索结果不一致。

9、群解散或转让:如果群聊已被解散或转让给其他用户,原群聊名称可能不再出现在搜索结果中。

10、搜索频率限制:为了防止反面搜索,QQ可能对频繁的搜索请求进行了限制。

解决QQ搜索群聊问题的常见方法

针对上述可能的原因,用户可以尝试以下几种解决方法来恢复搜索群聊的功能:

1、确认输入的关键词准确无误,并尝试使用不同的关键词组合进行搜索。

2、询问群主是否设置了群聊为不可搜索状态,并请求其更改设置。

3、检查自己的账号状态,确保没有被限制使用搜索功能。

4、重启网络设备或切换网络环境,以排除网络问题。

5、更新QQ至最新版本,以获取最佳的功能支持和体验。

6、清理QQ缓存或重启QQ客户端。

7、避免使用可能的敏感词汇作为搜索关键词。

8、在多个设备上尝试搜索,查看是否是设备兼容性问题。

9、确认群聊未被解散或转让,并且自己仍然是群成员。

10、适当降低搜索的频率,避免触发系统的防护机制。

FAQs

Q1: 我输入的群名是正确的,但是为什么还是搜不到?

A1: 除了关键词匹配问题外,还可能是由于群设置了隐私保护,不允许通过搜索加入,请与群主联系确认。

Q2: 我以前可以搜索到这个群,现在为什么突然搜不到了?

A2: 可能是因为群设置变更、网络或系统问题、账号权限变更等多种原因,建议先检查网络连接,然后更新QQ版本,最后联系群主确认群聊状态。