为什么穿越火线越南服务器遭遇了泛滥的科技问题?

- 行业动态

- 2024-09-11

- 1

在越南服务器的CF游戏中,开挂现象尤为严重,这背后的原因复杂多元,涉及技术、管理、文化等多个方面,下面将围绕此问题展开详细分析:

1、技术层面的挑战

对抗开挂的技术难度:FPS游戏自诞生之初就面临着与开挂对抗的局面,随着开挂技术的不断进步,游戏厂家需要持续更新反开挂技术和策略,这对技术实力有很高的要求。

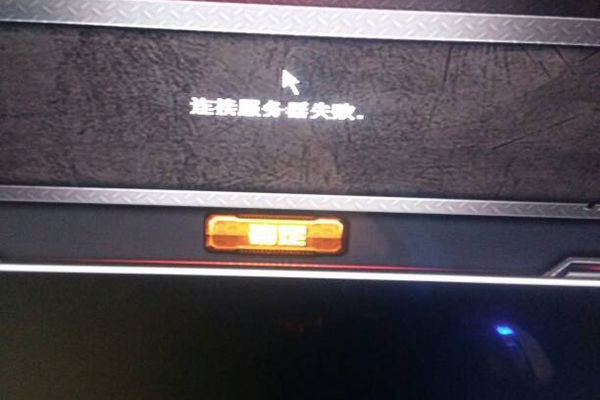

服务器规模和网络问题:越南服务器频繁出现问题,可能与服务器规模不足、网络连接不稳定有关,这些技术问题可能间接助长了开挂的使用。

2、管理监督的缺失

官方打击力度不足:相比于其他地区,越南服务器在管理和监管上可能存在不足,导致开挂现象泛滥,开挂的猖獗也反映出官方打击力度的不足,使得开挂行为得不到有效遏制。

游戏管理政策的不完善:有效的游戏管理政策对于遏制开挂至关重要,如果相关政策不够严格或执行不力,将难以有效治理开挂问题。

3、玩家心态与文化

追求胜利的极端心理:部分玩家为了追求胜利和优越感,选择使用开挂这种捷径,这种心态在一定程度上助长了开挂文化的蔓延。

社会文化的影响:在某些社会文化背景下,竞争意识尤为强烈,这可能导致一些玩家在无法通过正常手段获得优势时,倾向于使用开挂。

4、法律与惩罚措施

法律法规的缺失:如果相关的法律法规不够完善,或对此类行为的惩处不足以形成有效的威慑,开挂问题将更加难以根治。

惩罚措施的执行难度:即便有相关法律法规,由于跨国执法的难度,实际执行起来可能会受到诸多限制,使得开挂制作者和使用者往往逍遥法外。

5、游戏设计缺陷

游戏机制的破绽:任何游戏的设计都不可能完美无缺,FPS游戏尤其如此,设计上的破绽可能被开挂制作者利用,成为他们制挂的突破口。

公平性的缺失:当玩家感觉到游戏的公平性不足时,可能会被诱导去寻求开挂的帮助,以弥补实力上的不平衡。

6、玩家社区的影响

玩家社区的文化氛围:在一些玩家社区中,使用开挂可能被视为“正常”甚至“必要”的行为,这种扭曲的文化氛围对开挂的泛滥起到了推波助澜的作用。

非开挂玩家的沉默:面对开挂行为,一些坚持公平游戏的玩家可能会选择沉默或离开,这种不作为在一定程度上放任了开挂文化的生长。

7、经济因素的考量

开挂的经济诱因:对于一些玩家来说,获取开挂的成本远低于通过正常途径提升技能的成本,这种经济上的诱惑使得开挂具有一定的市场。

游戏公司的经济考虑:对抗开挂需要投入大量的资金和技术,一些游戏公司可能会在成本和收益之间进行权衡,影响到反开挂措施的实施。

可以进一步探讨一些具体解决方案和建议,旨在改善当前的状况:

加强技术支持:提升服务器稳定性和安全性,采用更先进的技术手段来检测和防范开挂。

完善管理制度:建立严格的游戏内规章制度,对使用开挂的行为进行严厉的惩罚。

强化法律约束:呼吁相关法律法规的完善,并加强国际合作,提高开挂制作和使用的法律风险。

培养健康游戏文化:通过教育和引导,树立正确的游戏观念,倡导公平竞争的游戏环境。

CF越南服务器开挂泛滥的问题是一个多因素交织的复杂现象,解决这一问题需要游戏开发者、玩家社区以及相关管理机构共同努力,从技术、管理、法律、文化等多个层面入手,采取综合措施,才能有效地减少开挂的发生,为所有玩家提供一个公平、健康的游戏环境。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:https://www.xixizhuji.com/fuzhu/169631.html