服务器为何会显示虚拟内存不足?

- 行业动态

- 2024-11-09

- 5

服务器显示虚拟内存不足通常是指服务器的物理内存已经被耗尽,操作系统正在使用硬盘上的虚拟内存(也称为页面文件或交换空间)来补充,以下是对虚拟内存不足问题的详细解释:

一、虚拟内存概念

虚拟内存是操作系统为了弥补物理内存不足而采用的一种技术,它通过在硬盘上划分一部分空间作为虚拟内存,当物理内存用尽时,将部分数据暂时存储到这个虚拟内存中,由于硬盘的读写速度远低于物理内存,因此频繁使用虚拟内存会导致系统性能下降。

二、虚拟内存不足的原因

1、物理内存过小:服务器配置的物理内存不足以支持当前运行的应用程序和服务。

2、资源占用过高:某些应用程序或进程占用大量内存,导致系统内存资源紧张。

3、虚拟内存设置不合理:默认情况下,操作系统可能会自动管理虚拟内存的大小,但在某些情况下,手动调整虚拟内存设置可能更为合理。

4、硬盘空间不足:虚拟内存依赖于硬盘空间,如果硬盘剩余空间不足,也可能导致虚拟内存不足的问题。

三、解决方法

1、优化服务器资源使用

检查并优化进程:检查服务器上运行的进程和服务,确定是否有任何资源占用过高的情况,特别是内存使用率较高的进程,可以考虑优化其配置或更新相关软件版本来改善内存使用情况。

2、增加服务器内存

升级硬件:如果云服务器的虚拟内存经常不足,可以考虑增加服务器的物理内存,根据云服务提供商的规格,可以升级到具有更高内存容量的机型,或者增加额外的内存资源。

3、调整虚拟内存设置

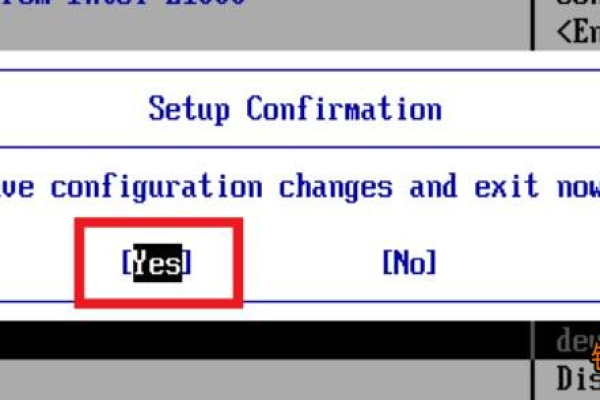

Windows系统:打开“控制面板”,选择“系统和安全”,进入“系统属性”页面,在“高级”选项卡下点击“性能”设置,再点击“更改”按钮,取消选中“自动管理所有驱动器的分页文件大小”,选中“自定义大小”,输入初始大小和最大大小(以MB为单位),然后点击“设置”和“确定”。

Linux系统:可以通过编辑/etc/fstab文件或使用sysctl命令来调整虚拟内存设置,具体步骤可以根据你使用的Linux发行版进行调整。

4、清理硬盘空间

确保硬盘有足够的剩余空间用于虚拟内存,如果硬盘空间不足,可以尝试删除不必要的文件或移动数据到外部存储设备。

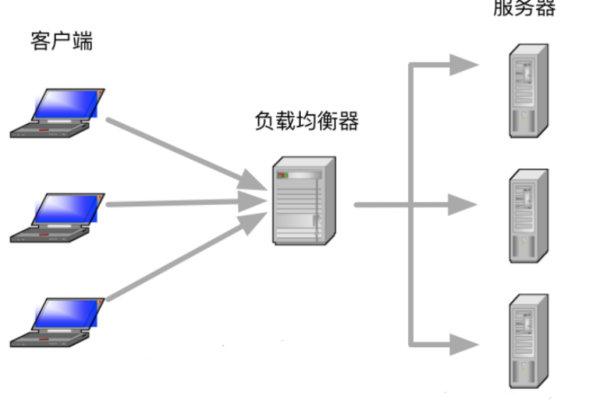

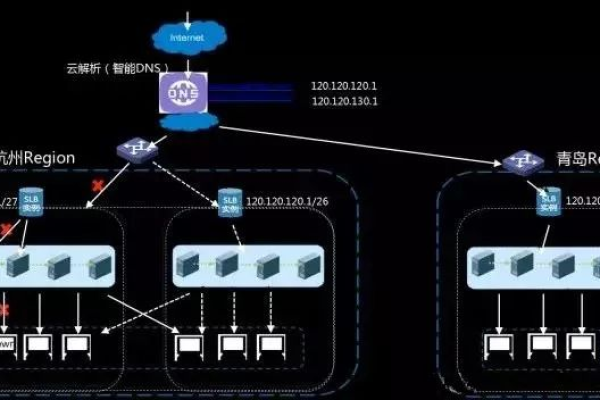

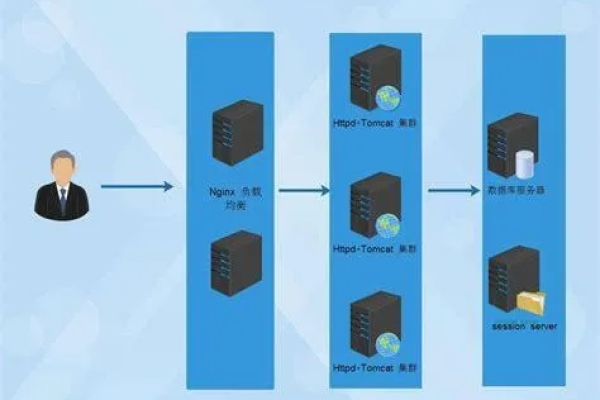

5、分散负载

如果是多台云服务器组成的集群,可以考虑通过负载均衡将请求分发到多个服务器上,以减轻单个服务器的内存压力。

6、升级服务器配置

如果上述方法无法解决问题,可能需要考虑升级到更高配置的云服务器,以满足更高的资源需求。

四、注意事项

在使用虚拟内存时,应尽量保持其连续性和固定性,避免频繁地动态变化,以减少磁盘碎片的产生。

定期监控服务器的内存和硬盘使用情况,及时发现并解决问题。

在进行任何配置更改之前,建议备份重要数据以防万一。

信息仅供参考,如果问题持续存在或影响业务运行,建议咨询专业的IT技术人员或云服务提供商的技术支持团队。