国际网站如何做seo_网站推广(SEO设置)

- 行业动态

- 2024-07-07

- 6

国际网站如何做 SEO_网站推广(SEO 设置)

在当今数字化时代,拥有一个强大的在线存在对于企业和个人来说至关重要,特别是对于国际网站,通过搜索引擎优化(SEO)来提高网站在搜索引擎结果页面(SERP)中的排名,可以吸引更多的潜在客户和流量,本文将详细介绍国际网站如何进行 SEO 网站推广,包括关键词研究、网站结构优化、内容创作和优化、外部链接建设等方面。

关键词研究

1、确定目标市场和受众:了解你的网站面向的国际市场和受众,包括他们的语言、文化、需求和搜索习惯。

2、使用关键词研究工具:利用关键词研究工具,如 Google 关键词规划师、SEMrush、Moz 等,来发现与你的网站相关的热门关键词和短语。

3、分析竞争对手:研究竞争对手的网站,了解他们使用的关键词和排名情况,以便找到竞争优势。

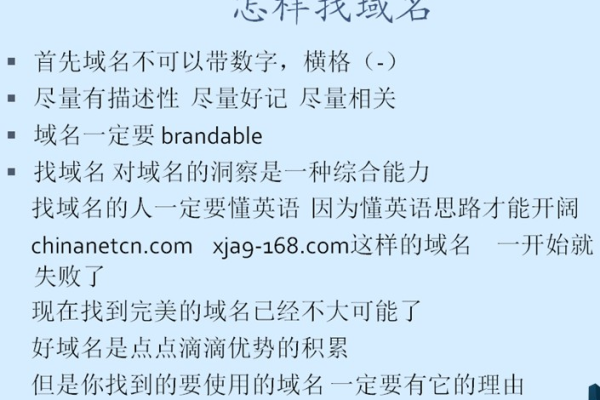

4、选择合适的关键词:根据目标市场和受众的需求,选择具有一定搜索量和商业价值的关键词,并确保这些关键词与你的网站内容相关。

网站结构优化

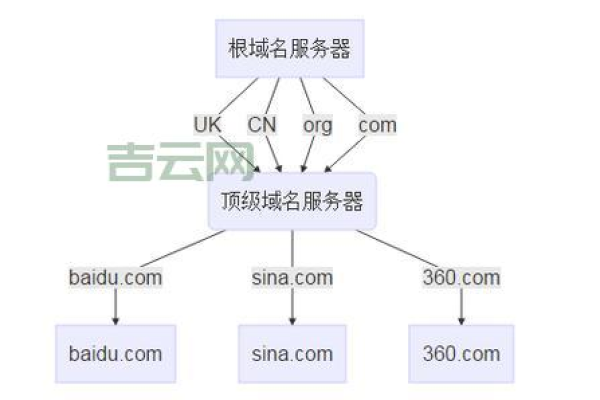

1、创建清晰的网站结构:确保网站的结构简单、清晰,易于导航和搜索引擎抓取,使用目录和子目录来组织网站内容。

2、优化网站 URL:使用简洁、有意义的 URL,包含关键词,以便搜索引擎更好地理解网站内容。

3、设置网站地图:创建一个 XML 网站地图,提交给搜索引擎,以便搜索引擎更好地索引网站内容。

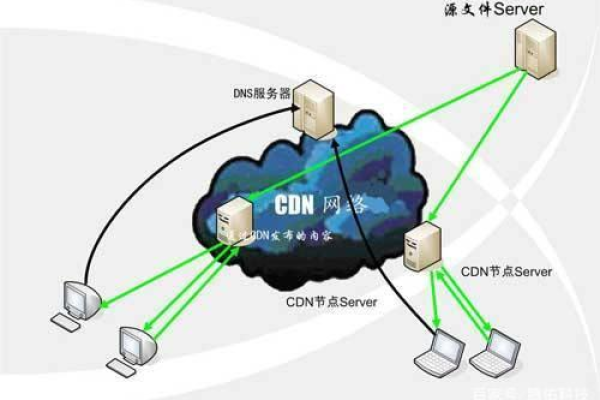

4、优化网站速度:确保网站加载速度快,减少页面加载时间,提高用户体验和搜索引擎排名。

1、提供有价值的内容:创建高质量、有价值的内容,满足用户的需求和兴趣,内容可以包括文章、博客、图片、视频等。

2、标题和描述:使用包含关键词的标题和描述,吸引用户点击和搜索引擎索引。

3、使用内部链接:在网站内容中使用内部链接,链接到相关的页面,提高网站的内部链接结构和用户体验。

4、定期更新内容:定期更新网站内容,保持网站的新鲜感和活跃度,吸引搜索引擎蜘蛛的爬行。

外部链接建设

1、寻找高质量的外部链接:与其他相关网站建立链接,提高网站的权重和排名,可以通过交换链接、发布客座文章、参与社交媒体等方式来获取外部链接。

2、避免低质量的链接:避免与低质量、垃圾网站建立链接,以免影响网站的排名和声誉。

3、监测外部链接:定期监测网站的外部链接,确保链接的质量和有效性,及时删除无效或低质量的链接。

社交媒体推广

1、创建社交媒体账号:在主要的社交媒体平台上创建账号,如 Facebook、Twitter、Instagram 等。

2、分享网站内容:定期分享网站内容到社交媒体平台上,吸引用户点击和关注。

3、与用户互动:回复用户的评论和私信,建立良好的用户关系,提高用户忠诚度。

4、利用社交媒体广告:可以考虑使用社交媒体广告来推广网站,吸引更多的潜在客户和流量。

技术 SEO

1、优化网站代码:确保网站代码简洁、规范,符合搜索引擎的要求。

2、使用 HTTPS:使用安全的 HTTPS 协议,提高网站的安全性和信任度。

3、优化图片和视频:对网站中的图片和视频进行优化,减少文件大小,提高加载速度。

4、确保网站的移动友好性:随着移动设备的普及,确保网站在移动设备上的显示效果和用户体验良好。

数据分析和监测

1、安装分析工具:安装 Google Analytics 等分析工具,跟踪网站的流量、用户行为和转化率等数据。

2、分析数据:定期分析网站的数据,了解用户的需求和行为,以便优化网站和营销策略。

3、监测排名:使用搜索引擎排名监测工具,定期监测网站在搜索引擎结果页面中的排名情况,及时调整 SEO 策略。

通过以上步骤,你可以为你的国际网站进行有效的 SEO 网站推广,需要注意的是,SEO 是一个长期的过程,需要持续的努力和优化,要遵守搜索引擎的规则和指南,避免使用黑帽 SEO 技术,以免受到搜索引擎的惩罚,祝你在国际网站的 SEO 推广中取得成功!

以下是一个国际网站 SEO 推广的示例表格:

| 步骤 | 描述 | 工具和资源 |

| 关键词研究 | 确定目标市场和受众,使用关键词研究工具,分析竞争对手,选择合适的关键词 | Google 关键词规划师、SEMrush、Moz |

| 网站结构优化 | 创建清晰的网站结构,优化网站 URL,设置网站地图,优化网站速度 | Google Search Console、Yoast SEO |

| 内容创作和优化 | 提供有价值的内容,优化内容标题和描述,使用内部链接,定期更新内容 | WordPress、Yoast SEO |

| 外部链接建设 | 寻找高质量的外部链接,避免低质量的链接,监测外部链接 | Ahrefs、Majestic |

| 社交媒体推广 | 创建社交媒体账号,分享网站内容,与用户互动,利用社交媒体广告 | Facebook、Twitter、Instagram |

| 技术 SEO | 优化网站代码,使用 HTTPS,优化图片和视频,确保网站的移动友好性 | Google Search Console、W3C Markup Validation Service |

| 数据分析和监测 | 安装分析工具,分析数据,监测排名 | Google Analytics、SEMrush |

请注意,以上表格仅为示例,你可以根据自己的需求和情况进行调整和补充。