ModelScope微调后效果不理想和训练数据集的质量有关系、微调时参数、模型还是chat-awq?

- 行业动态

- 2024-05-29

- 1

当使用ModelScope进行微调后,效果不理想时,可能与以下因素有关:

1、训练数据集的质量:

数据集的覆盖范围是否足够广泛,能够涵盖各种不同场景和问题?

数据集中的样本是否具有代表性,能够反映真实世界中的情况?

数据集是否存在标注错误或不一致的情况?

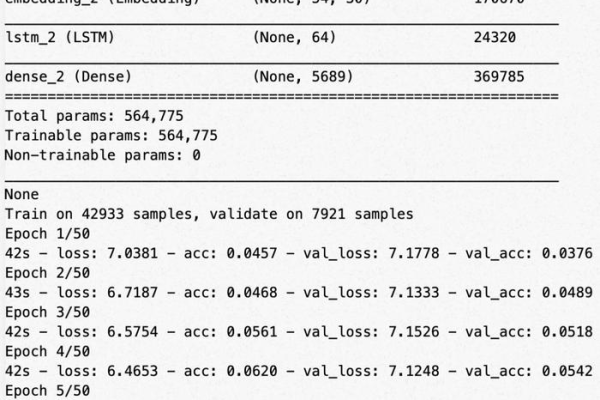

2、微调时的参数设置:

学习率是否过高或过低,导致模型无法收敛或收敛速度过慢?

优化器的选择是否合适,是否能够有效地更新模型参数?

正则化参数是否设置得当,是否能够防止过拟合?

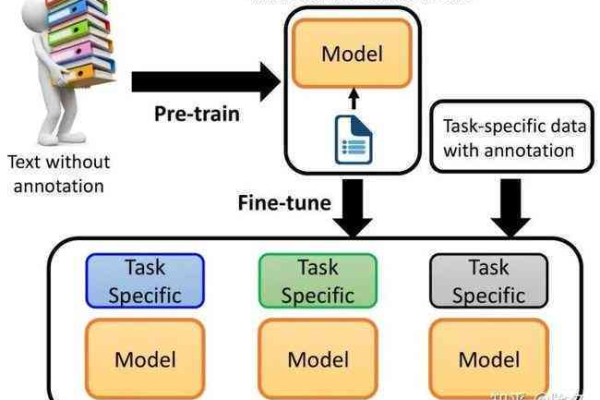

3、模型选择:

所选择的预训练模型是否适用于目标任务?

预训练模型的结构和规模是否适合目标任务的复杂性?

预训练模型是否已经过充分的训练和验证,是否具有良好的泛化能力?

4、chatawq的使用:

chatawq是否能够准确地理解和回答用户的问题?

chatawq是否能够处理复杂的语义和上下文信息?

chatawq是否能够生成连贯、准确的回答?

以下是一些可能的解决方案:

1、数据集质量的提升:

收集更多的数据,增加数据集的覆盖范围和多样性。

对数据集进行清洗和预处理,去除噪声和异常值。

对数据集进行标注一致性检查,修正错误的标注。

2、微调参数的调整:

根据经验或实验结果,选择合适的学习率和优化器。

使用学习率调度策略,逐渐减小学习率以提高模型的稳定性。

调整正则化参数,平衡模型的复杂度和泛化能力。

3、模型选择的优化:

根据目标任务的特点,选择合适的预训练模型。

如果预训练模型过于庞大,可以考虑使用更小的规模或更简单的结构。

对预训练模型进行充分的训练和验证,确保其具有良好的泛化能力。

4、chatawq的改进:

对chatawq进行进一步的训练和调优,提高其理解和回答的准确性。

引入更多的上下文信息,使chatawq能够更好地理解问题的背景和意图。

对chatawq的回答进行后处理,使其更加连贯和准确。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/169093.html