扣扣群为什么解散失败

- 行业动态

- 2024-05-19

- 10

扣扣群解散失败的原因

在网络社交中,QQ群是人们常用的一种交流工具,有时候我们会遇到扣扣群解散失败的问题,这可能会让群主感到困扰,扣扣群解散失败的原因有哪些呢?本文将从以下几个方面进行分析。

1. 网络问题

网络问题是导致扣扣群解散失败的一个常见原因,当网络连接不稳定或者速度较慢时,可能会导致解散操作无法正常进行,此时,建议群主检查网络连接,确保网络畅通后再尝试解散。

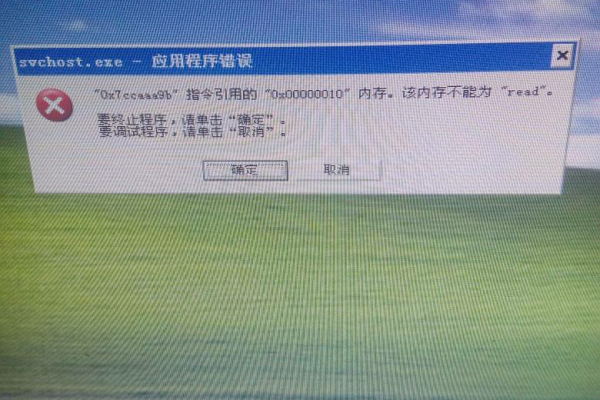

2. 系统故障

扣扣群解散失败的另一个可能原因是系统故障,由于腾讯服务器的问题,可能导致解散操作无法正常执行,这种情况下,群主可以稍后再尝试解散,或者联系腾讯客服寻求帮助。

3. 权限不足

如果群主的权限不足,也可能导致解散失败,如果群主被其他管理员撤销了管理权限,或者群主账号被封禁,那么解散操作将无法进行,此时,群主需要重新获取管理权限后再尝试解散。

4. 群成员数量过多

如果群成员数量过多,也可能导致解散失败,根据腾讯的规定,群成员超过一定数量时,解散操作需要进行多次确认,群主需要在解散前仔细核对群成员数量,并按照提示进行操作。

5. 群类型限制

部分特殊类型的扣扣群(如企业群、班级群等)可能存在解散限制,对于这类群,群主需要按照相关规定和流程进行解散操作,否则可能导致解散失败。

6. 操作失误

群主在解散群聊时可能会因为操作失误导致解散失败,误点击了取消解散按钮,或者在解散过程中意外关闭了页面,此时,群主只需重新进行解散操作即可。

如何避免扣扣群解散失败

了解了扣扣群解散失败的原因后,我们可以采取以下措施来避免这一问题:

1、确保网络连接稳定,避免在网络状况不佳的情况下进行解散操作。

2、关注腾讯官方公告,了解系统故障情况,避免在系统故障期间进行解散操作。

3、定期检查自己的管理权限,确保自己具备解散群聊的权限。

4、在解散前仔细核对群成员数量,按照提示进行操作。

5、针对特殊类型的群聊,了解相关规定和流程,按照规定进行解散操作。

6、在解散过程中保持耐心,仔细操作,避免因操作失误导致解散失败。

通过以上措施,我们可以有效降低扣扣群解散失败的风险,提高解散成功率。

相关问答FAQs

Q1: 为什么有时候扣扣群解散失败?

A1: 扣扣群解散失败的原因可能有以下几点:网络问题、系统故障、权限不足、群成员数量过多、群类型限制以及操作失误,了解这些原因后,可以采取相应措施避免解散失败。

Q2: 如何在解散扣扣群时避免操作失误?

A2: 在解散扣扣群时,可以采取以下措施避免操作失误:仔细阅读解散提示,确保自己了解解散流程;在解散过程中保持耐心,不要急躁;在操作过程中避免误点击其他按钮或关闭页面,通过以上措施,可以有效降低操作失误的风险。