购物网站的详细设计_CDN能否加速本地访问购物网站的速度从而抢购商品?

- 行业动态

- 2024-07-06

- 9

CDN 能否加速本地访问购物网站的速度从而抢购商品?

一、CDN 的基本原理和作用

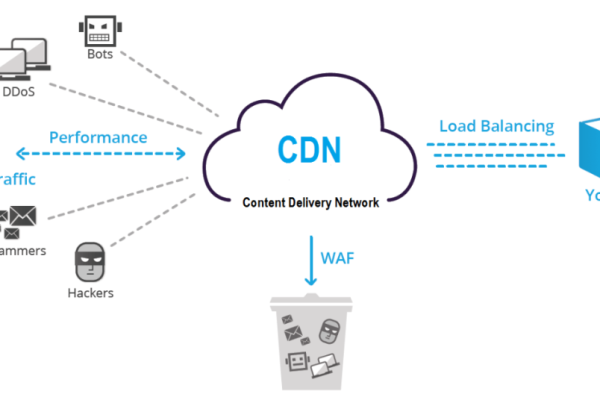

CDN(Content Delivery Network)即内容分发网络,是一种通过在多个地理位置部署服务器来加速内容分发的技术,当用户访问购物网站时,CDN 会根据用户的地理位置和网络状况,选择最近的服务器提供服务,从而减少数据传输的延迟和提高网站的访问速度。

CDN 的主要作用包括:

1、加速网站访问速度:通过将网站的内容缓存到 CDN 服务器上,用户可以更快地获取所需的内容,提高网站的响应速度和用户体验。

2、减轻源站服务器压力:CDN 可以将大量的用户请求分发到多个服务器上,从而减轻源站服务器的压力,提高网站的稳定性和可靠性。

3、提高网站的安全性:CDN 可以提供一些安全功能,如 DDoS 攻击防护、WAF(Web Application Firewall)等,保护网站免受攻击。

二、CDN 对本地访问购物网站速度的影响

CDN 可以加速本地访问购物网站的速度,从而提高抢购商品的成功率,CDN 可以通过以下方式提高网站的访问速度:

1、减少数据传输的延迟:CDN 服务器通常部署在离用户较近的地理位置,因此可以减少数据传输的延迟,提高网站的响应速度。

2、缓存网站的内容:CDN 可以将网站的内容缓存到服务器上,当用户再次访问时,可以直接从缓存中获取内容,而不需要再次从源站服务器获取,从而提高网站的访问速度。

3、优化网络路由:CDN 可以通过优化网络路由,选择最优的路径传输数据,从而提高数据传输的效率和速度。

三、CDN 在购物网站中的应用

CDN 在购物网站中得到了广泛的应用,主要包括以下几个方面:

1、图片和视频加速:购物网站中通常包含大量的图片和视频,这些内容的加载速度会直接影响用户的体验,CDN 可以将这些内容缓存到服务器上,从而提高图片和视频的加载速度。

2、静态文件加速:购物网站中的静态文件,如 CSS、JavaScript 等,也可以通过 CDN 进行加速,提高网站的访问速度。

3、动态内容加速:对于一些动态内容,如商品详情页、购物车等,CDN 也可以通过缓存和优化网络路由等方式提高访问速度。

四、CDN 加速本地访问购物网站速度的局限性

虽然 CDN 可以加速本地访问购物网站的速度,但也存在一些局限性:

1、CDN 服务器的覆盖范围有限:CDN 服务器通常部署在一些主要的城市和地区,如果用户所在的地区没有 CDN 服务器覆盖,CDN 就无法发挥作用。

2、CDN 缓存的内容可能不是最新的:CDN 缓存的内容通常是一段时间之前的,如果网站的内容更新频繁,CDN 缓存的内容可能不是最新的,从而影响用户的体验。

3、CDN 可能会受到网络拥塞的影响:如果网络拥塞严重,CDN 也可能会受到影响,从而降低网站的访问速度。

五、如何选择合适的 CDN 服务提供商

选择合适的 CDN 服务提供商是非常重要的,以下是一些选择 CDN 服务提供商的建议:

1、考虑 CDN 服务提供商的覆盖范围:选择覆盖范围广的 CDN 服务提供商,以确保在不同的地区都能够获得良好的加速效果。

2、考虑 CDN 服务提供商的性能和稳定性:选择性能和稳定性好的 CDN 服务提供商,以确保网站的访问速度和稳定性。

3、考虑 CDN 服务提供商的价格:选择价格合理的 CDN 服务提供商,以确保在获得良好的加速效果的同时,不会增加过多的成本。

4、考虑 CDN 服务提供商的技术支持:选择技术支持好的 CDN 服务提供商,以确保在遇到问题时能够及时得到解决。

六、上文归纳

CDN 可以加速本地访问购物网站的速度,从而提高抢购商品的成功率,CDN 也存在一些局限性,因此在选择 CDN 服务提供商时,需要综合考虑覆盖范围、性能和稳定性、价格和技术支持等因素,购物网站也可以通过优化网站的内容和结构,提高网站的性能和用户体验,从而更好地满足用户的需求。

| CDN 的基本原理和作用 | CDN 对本地访问购物网站速度的影响 | CDN 在购物网站中的应用 | CDN 加速本地访问购物网站速度的局限性 | 如何选择合适的 CDN 服务提供商 | |

| CDN 是一种通过在多个地理位置部署服务器来加速内容分发的技术。 | CDN 可以通过减少数据传输的延迟、缓存网站的内容和优化网络路由等方式提高网站的访问速度。 | CDN 在购物网站中可以用于图片和视频加速、静态文件加速和动态内容加速等方面。 | CDN 服务器的覆盖范围有限、缓存的内容可能不是最新的和可能会受到网络拥塞的影响。 | 选择 CDN 服务提供商时需要考虑覆盖范围、性能和稳定性、价格和技术支持等因素。 | CDN 可以加速本地访问购物网站的速度,但也存在一些局限性,因此在选择 CDN 服务提供商时需要综合考虑各种因素。 |