如何在Oppo手机上设置接入点并填写正确的服务器信息?

- 行业动态

- 2024-08-19

- 5

在当今社会,智能手机已成为大家日常生活中不可或缺的一部分,OPPO作为市场上流行的智能手机品牌之一,提供了丰富的功能和良好的用户体验,其中网络连接功能是智能手机使用中最基础也是最重要的部分,掌握OPPO手机的接入点设置方法,对于确保手机网络连接的顺畅非常关键,下面将详细介绍OPPO手机如何设置接入点,并指导如何填写服务器信息:

1、进入设置菜单

打开手机设置:需要找到并打开手机上的“设置”应用,它的标志是一个齿轮状图标,在主屏幕上找到该图标并点击进入设置菜单。

2、选择网络选项

进入网络与互联网设置:在设置菜单中滑动屏幕,找到“网络与互联网”或类似名称的选项,然后点击进入,这一步骤是确保你处于正确的设置分类中。

3、 配置移动网络

选择移动网络:在“网络与互联网”设置下,寻找“移动网络”、“蜂窝网络”或相似命名的选项,并点击进入,此处将管理与移动网络相关的设置。

4、 接入点名称设置

进入APN设置界面:在移动网络设置中找到“接入点名称”(APN)或相应条目,点击进入APN设置页面,此页面列出了当前所有已配置的网络接入点。

5、新建APN配置

新增APN:在APN页面中,点击菜单按钮(可能是三个垂直点或其他形式),选择“新增APN”或“添加新接入点”,这将允许您创建一个新的网络接入配置。

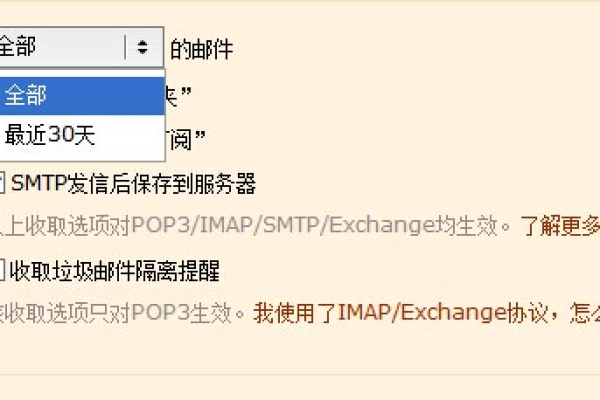

6、填写服务器信息

详细参数配置:在新建APN页面中,您需要填写各项参数,如“APN名称”、“服务器”、“APN类型”等,这些参数通常由您的网络运营商提供,确保按照运营商给出的准确信息填写。

7、保存并激活APN

保存设置:完成所需信息的填写后,记得点击页面上的“保存”、“确定”或相似的按钮,保存您所做的设置,这样,新的APN配置就会生效。

8、配置双卡APN

针对双卡手机:如果您使用的是双卡OPPO手机,在设置APN时,注意选择正确的SIM卡,并为每张SIM卡分别配置APN,这保证了每张卡都能按照正确的配置使用网络。

在实际操作过程中,还有一些注意事项和常见问题解决的策略,这些都是为了帮助您更顺利地完成设置:

确保您正在编辑的APN设置是与您的当前网络运营商合约相匹配的,错误的APN设置可能会导致无法上网或网速变慢。

在填写APN参数时,对于一些加密或特定类型的网络(如LTE),可能需要设置特定的APN类型和代理、端口等信息,请根据运营商的指示填写这些字段。

如果在修改APN设置后发现网络速度变慢或无法连接,建议检查输入的参数是否完全正确,或恢复默认设置后再重新尝试。

您可以顺利地在OPPO手机上设置接入点,并填写适当的服务器信息来保证网络连接的畅通无阻,通过合理配置,不仅可以享受到快速的网络服务,还能避免不必要的网络问题。