MapReduce的工作机制是如何优化大数据处理的?

- 行业动态

- 2024-08-21

- 1

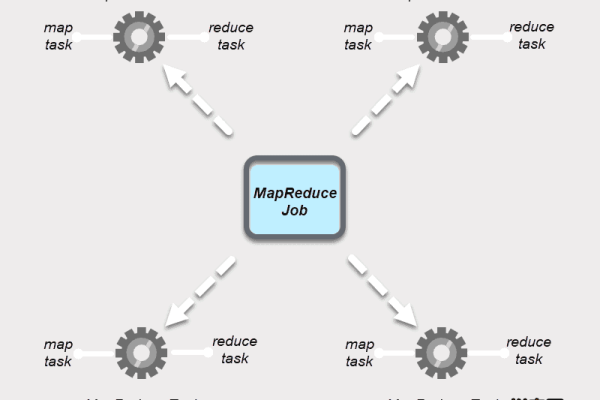

MapReduce是一种编程模型,用于处理和生成大数据集。它包括两个主要阶段:Map和Reduce。在Map阶段,输入数据被分割成小块并分配给多个处理器并行处理;在Reduce阶段,中间结果被合并以得到最终输出。这种模型通过将计算任务分布到多个节点上,有效提高了数据处理速度和效率。

MapReduce工作原理

MapReduce是Hadoop框架中的一个核心组件,它为大规模数据集的处理提供了一个简洁而强大的编程模型,通过将复杂的问题分解为更小的任务,并以并行方式执行这些任务,MapReduce能高效地处理和分析大量数据,本文将深入探讨MapReduce的工作原理,包括其架构设计、执行流程以及关键技术要点。

基本概念

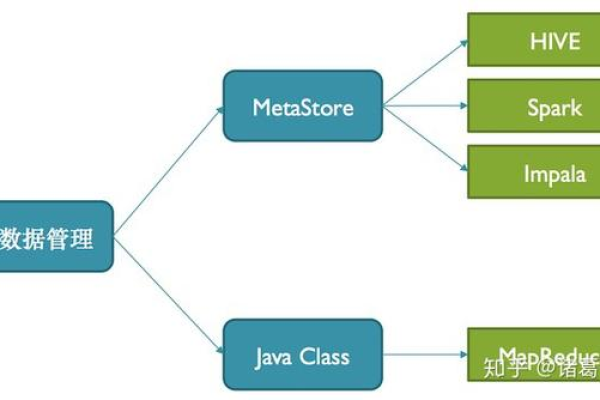

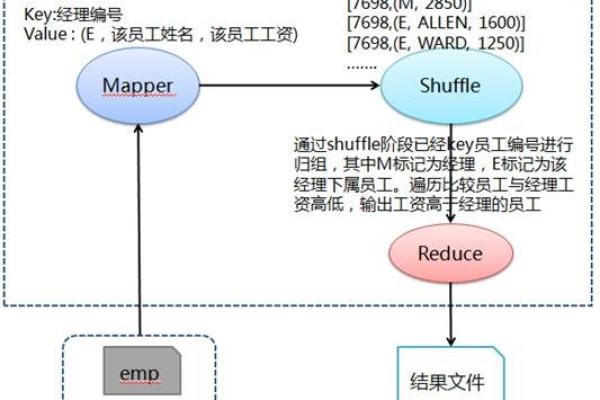

MapReduce名称来源于它的核心操作:Map(映射)和Reduce(归约),简单地说,Map函数负责将输入数据映射成键值对,而Reduce函数则将所有具有相同键的值聚集在一起进行归约操作,这一过程隐藏了分布式计算的复杂性,允许开发者专注于数据处理逻辑本身。

工作流程

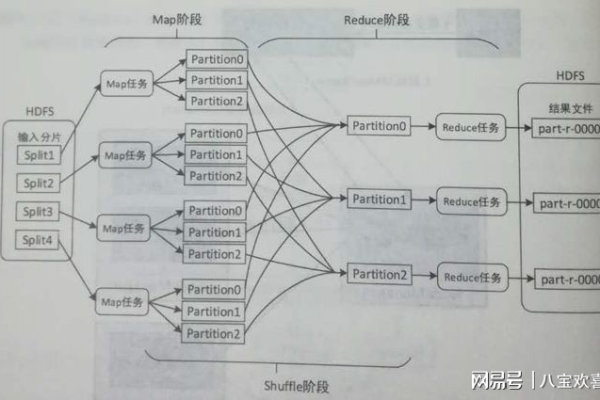

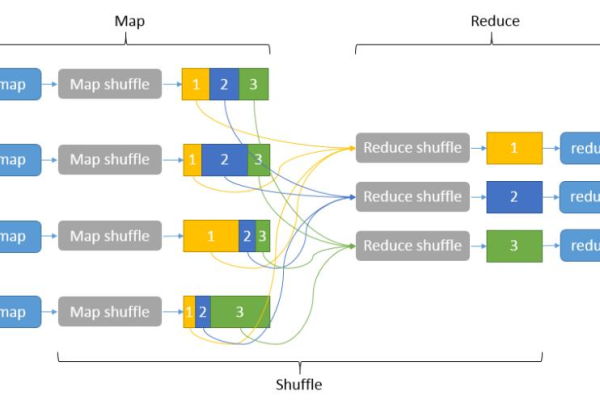

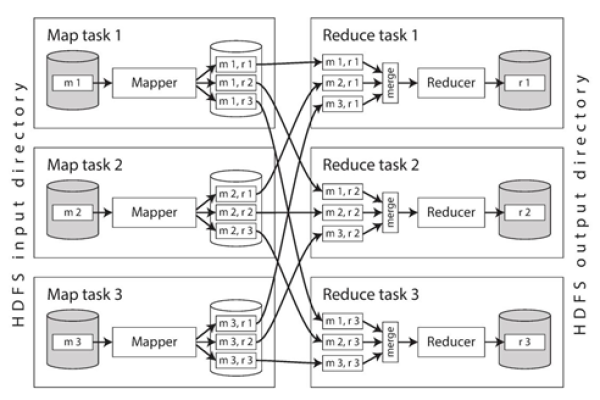

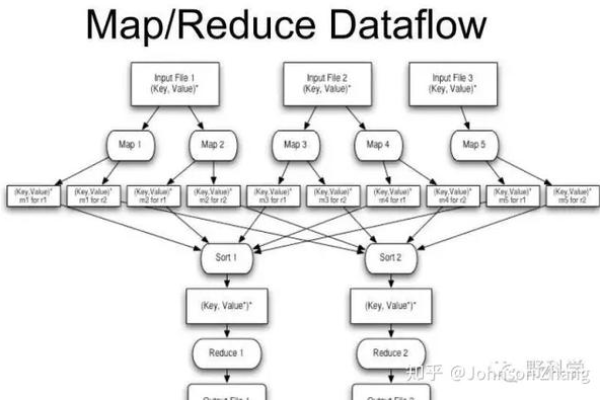

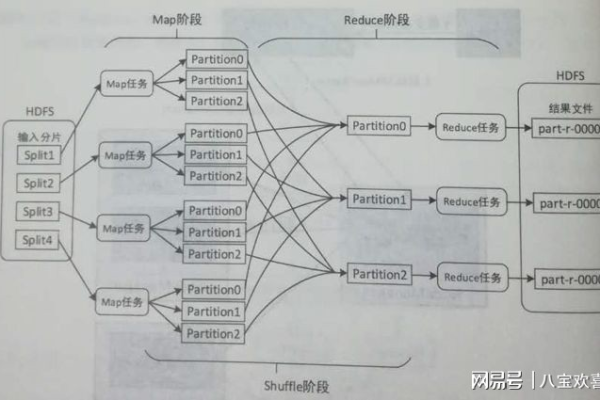

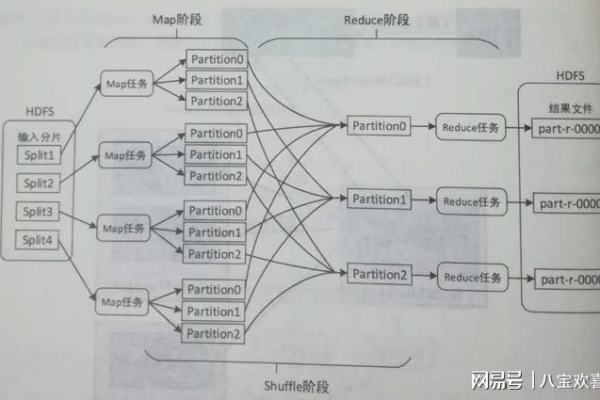

MapReduce的工作流程可以分为五个主要阶段:输入分片、Map阶段、Shuffle阶段、Reduce阶段和输出结果。

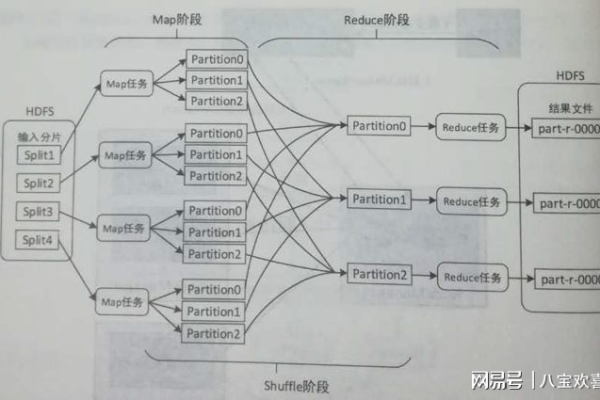

1、输入分片:在Map阶段开始前,框架会根据文件的大小和位置,将其分成若干个切片(splits),每个切片将由一个Map任务处理。

2、Map阶段:Map任务读取切片中的数据记录,然后解析成键值对,并传递给用户定义的Map函数,Map函数的输出会进入一个缓冲区,并周期性地写入磁盘。

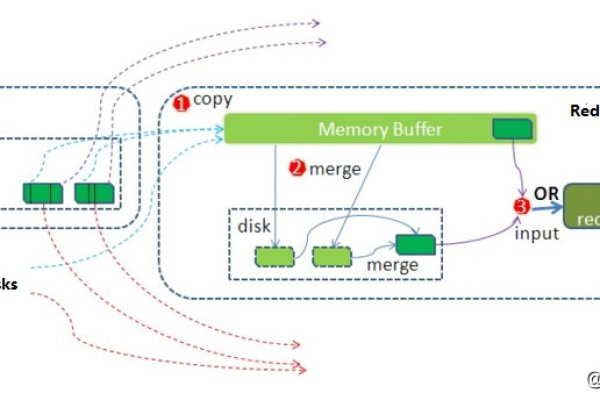

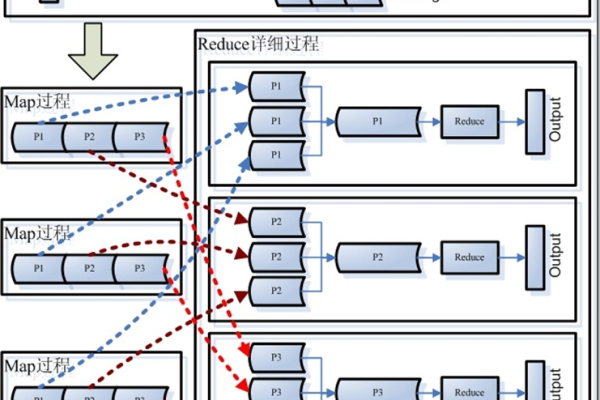

3、Shuffle阶段:这是连接Map和Reduce的阶段,框架会对Map的输出按键进行排序和分组,以确保相同键的值被发送到同一个Reduce任务。

4、Reduce阶段:Reduce任务接收到所有相关数据后,根据键对其进行遍历,并将对应的值传递给用户定义的Reduce函数,Reduce函数的输出将被写入到输出文件中。

5、输出结果:所有的Reduce任务完成后,结果会存储在HDFS(Hadoop Distributed File System)中,可以被其他任务或应用程序使用。

关键特性

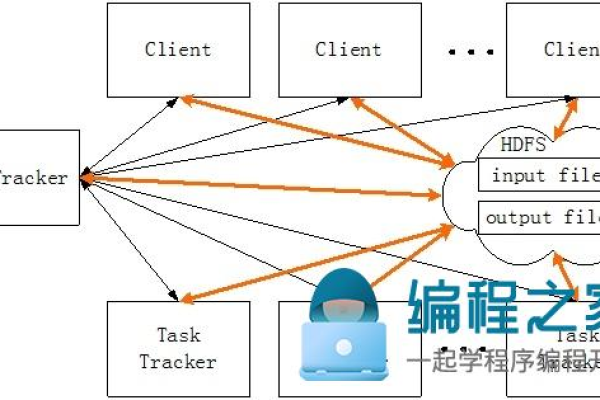

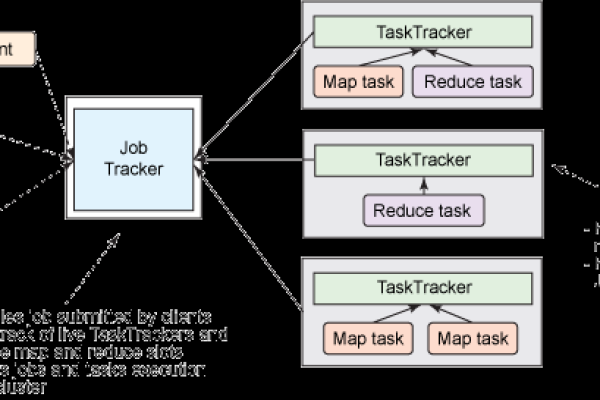

容错性:MapReduce的设计考虑到了系统的容错性,如果某个任务失败,系统会自动重新调度该任务到其他节点执行。

可扩展性:由于其分布式的特性,MapReduce可以轻松扩展以处理更大的数据集或加入更多的计算资源。

数据本地化:为了减少网络传输带来的开销,MapReduce尽量将任务调度到数据所在的节点上执行,这称为“数据本地化优化”。

实际应用

MapReduce适用于各种需要大数据处理的场景,如日志分析、数据挖掘、机器学习等,在日志分析中,Map函数可以用于过滤和统计日志条目,而Reduce函数则可以进行全局的聚合操作,从而得到整体的分析结果。

通过上述讨论,我们可以看到MapReduce通过其独特的设计,为处理大规模数据集提供了一种高效且可靠的方法,我们将通过相关的问答来进一步巩固对MapReduce工作原理的理解。

FAQs

Q1: MapReduce如何处理数据倾斜问题?

A1: 数据倾斜是指某些键的值远远多于其他键,导致处理这些键的Reduce任务运行时间远长于其他任务,解决这一问题的策略包括在Map阶段的输出中对键进行采样,并在Reduce阶段使用范围分区或Hash分区确保负载均衡。

Q2: MapReduce与Spark有何不同?

A2: Spark是一个更现代的大数据处理框架,它提供了超越MapReduce的功能,如内存计算、流处理等,尽管两者都用于大数据处理,但Spark在速度和易用性方面通常优于MapReduce,特别是在需要频繁迭代的计算场景中,MapReduce因其简单性和稳定性,在一些特定场合仍然有其独特的优势。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/149498.html