如何在MySQL数据库中有效管理用户和数据库?

- 行业动态

- 2024-12-23

- 8

CREATE USER 创建新用户,

ALTER USER 修改现有用户属性,

DROP USER 删除用户。通过

GRANT 和

REVOKE 命令来赋予或撤销用户对数据库的操作权限。

在MySQL数据库中,用户和数据库的管理是确保系统安全、稳定运行的重要环节,本文将详细探讨如何在MySQL下进行用户和数据库管理,包括创建用户、删除用户、修改用户密码、分配权限以及回收权限等操作。

一、用户管理

1. 用户信息

MySQL中的用户信息存储在系统数据库mysql的user表中,可以通过以下命令查看用户信息:

USE mysql; SELECT host, user, authentication_string FROM user;

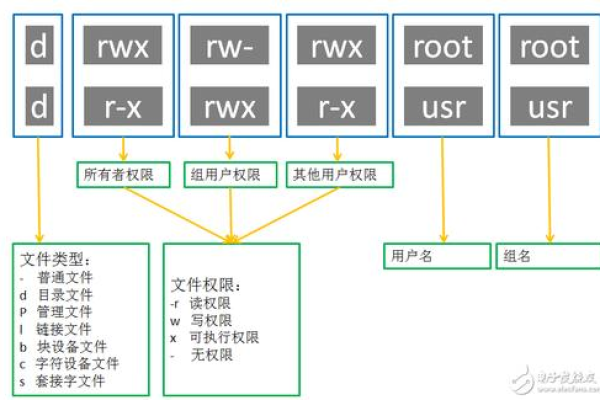

字段解释:

host:表示这个用户可以从哪个主机登录,如果是localhost,表示只能从本机登录。

user:用户名。

authentication_string:用户密码经过加密后的字符串。

_priv:用户拥有的权限。

2. 创建用户

创建用户的语法如下:

CREATE USER 'username'@'host' IDENTIFIED BY 'password';

创建一个只能在本机登录的用户:

CREATE USER 'test_user'@'localhost' IDENTIFIED BY 'Dhj123456.';

如果希望用户能从任意主机登录,可以使用%作为通配符:

CREATE USER 'test_user'@'%' IDENTIFIED BY 'Dhj123456.';

创建用户后,需要刷新权限使其生效:

FLUSH PRIVILEGES;

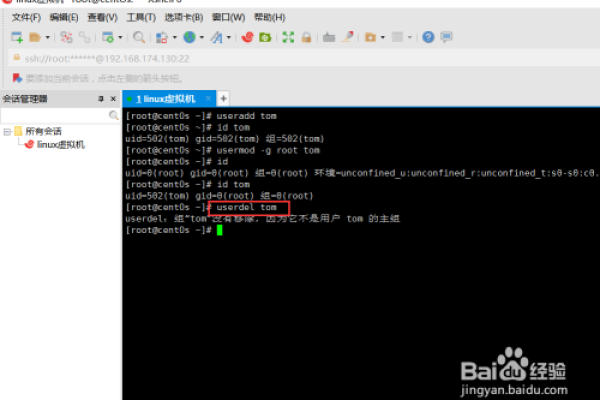

3. 删除用户

删除用户的语法如下:

DROP USER 'username'@'host';

删除名为test_user的用户:

DROP USER 'test_user'@'%';

注意:删除用户时必须指定完整的用户名和主机名。

4. 修改用户密码

修改用户密码有两种方式:使用ALTER USER语句或SET PASSWORD函数,推荐使用ALTER USER语句,因为它更直观且易于理解。

使用ALTER USER语句修改密码:

ALTER USER 'username'@'host' IDENTIFIED BY 'new_password';

修改test_user的密码:

ALTER USER 'test_user'@'localhost' IDENTIFIED BY 'NewPassword123!';

使用SET PASSWORD函数修改密码(不推荐):

SET PASSWORD FOR 'username'@'host' = PASSWORD('new_password');

SET PASSWORD FOR 'test_user'@'localhost' = PASSWORD('NewPassword123!');

二、数据库权限管理

1. 给用户分配权限

分配权限使用GRANT语句,语法如下:

GRANT privileges ON database.table TO 'username'@'host';

privileges可以是ALL、SELECT、INSERT、UPDATE、DELETE等权限类型;database.table表示具体的数据库和表;username@host表示授予权限的用户及其允许登录的IP地址。

示例:

授予所有权限:

GRANT ALL PRIVILEGES ON *.* TO 'test_user'@'localhost';

授予特定表的权限:

GRANT SELECT, INSERT ON mydb.mytable TO 'test_user'@'localhost';

2. 回收权限

回收权限使用REVOKE语句,语法与GRANT类似,只是将关键字换成REVOKE。

示例:

回收所有权限:

REVOKE ALL PRIVILEGES ON *.* FROM 'test_user'@'localhost';

回收特定权限:

REVOKE SELECT, INSERT ON mydb.mytable FROM 'test_user'@'localhost';

三、相关FAQs及解答

FAQ 1: 如何更改MySQL用户的主机限制?

答:要更改MySQL用户的主机限制,可以使用RENAME USER语句,将用户test_user的主机限制从localhost改为%,使其可以从任何主机登录:

RENAME USER 'test_user'@'localhost' TO 'test_user'@'%'; FLUSH PRIVILEGES;

FAQ 2: 如何查看当前MySQL用户拥有的权限?

答:可以使用SHOW GRANTS语句查看当前用户拥有的权限,查看root用户的权限:

SHOW GRANTS FOR 'root'@'localhost';

小编有话说

MySQL的用户和数据库管理是数据库运维中的重要组成部分,通过合理的用户管理和权限分配,可以有效保障数据库的安全性和稳定性,定期审查和更新用户权限也是维护数据库健康的重要手段,希望本文能帮助大家更好地理解和掌握MySQL下的用户和数据库管理技巧。