如何确保织梦网站的安全性,三个关键设置你掌握了吗?

- 行业动态

- 2024-10-21

- 11

织梦(DedeCMS)作为一款流行的内容管理系统,其安全性设置对于网站防护尤为重要,以下是三个最重要的安全设置:

1、改变data目录位置

操作步骤:

1. 新建一个目录用于存放data目录,例如命名为mydataabc,将DATA目录移动到该目录下,这样data的完整目录变成/mydataabc/data。

2. 修改配置文件include/common.inc.php,找到语句define(‘DEDEDATA’, DEDEROOT.’/data’); 修改为 define(‘DEDEDATA’, DEDEROOT.’/mydataabc/data’);。

3. 调整验证码图片位置:修改文件/include/vdimgck.php(红色部分是修改过的代码)。

作用:data目录用于存放织梦系统一些重要的配置文件与数据,应该予以重点保护,通过改变data目录的位置,可以增加破解攻击的难度,提高网站的安全性。

2、删除不必要的系统文件

操作步骤:

1. 在Plus目录下,只保留必要的文件,例如mytag_js.php、ad_js.php(广告显示)、count.php(文章访问次数统计)、search.php(文章搜索)、feedback.php feedback_ajax.php feedback_js.php(评论用)、list.php(频道动态页),而plus目录中的其他php文件全部删除。

2. 在dede目录下,可以删除用于后台文件管理的几个文件:file_manage_control.php、file_manage_main.php、file_manage_view.php、media_add.php、media_edit.php、media_main.php。

3. 如果不需要会员系统,可以删除member文件夹;如果不需要专题,可以删除special文件夹。

作用:删除不必要的系统文件可以减少潜在的安全破绽,降低被破解利用的风险。

3、合理设置敏感目录权限

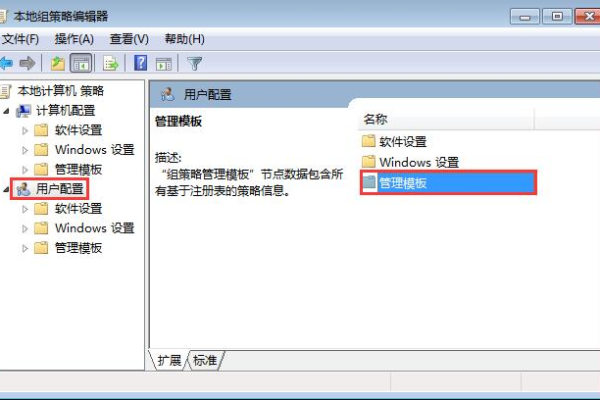

操作步骤:

1. 禁止data与upload目录的执行权限:即在ftp里右击目录,选择属性,将权限设置为666。

作用:通过限制敏感目录的执行权限,可以防止破解在这些目录下执行反面代码,从而保护网站的安全。

以下是两个关于织梦安全设置的常见问题及解答:

1、为什么需要改变data目录的位置?

回答:data目录存放着织梦系统的重要配置文件和数据,是破解攻击的重点目标,通过改变data目录的位置,可以增加破解攻击的难度,提高网站的安全性。

2、如何合理设置敏感目录的权限?

回答:对于敏感目录,如data和upload目录,应该禁止其执行权限,具体操作是在ftp里右击目录,选择属性,将权限设置为666,这样可以防止破解在这些目录下执行反面代码。

三个安全设置对于织梦系统的安全性至关重要,通过实施这些设置,可以有效地提高网站的安全防护能力,降低被破解攻击的风险。