cun存储

- 行业动态

- 2025-02-15

- 2

cun 存储通常指的是一种数据 存储方式, cun 可能代表某种特定的存储技术、设备或系统。不过,由于你提供的信息较为模糊,我无法给出更具体的解释或描述。

CUN存储:定义、类型及应用场景

CUN存储,即云存储(Cloud Storage),是一种基于云计算技术的存储方式,它将数据存储在通过网络连接的远程服务器上,而不是本地硬盘或内部服务器,这种存储方式具有高度的可扩展性、灵活性和成本效益,因此在现代数据管理中扮演着重要角色。

一、CUN存储的定义与特点

1、定义:

CUN存储是一种基于云计算技术的存储服务,它允许用户通过网络将数据存储在远程服务器上,并按需访问这些数据,与传统的本地存储相比,云存储提供了更高的灵活性和可扩展性。

2、特点:

高度可扩展性:云存储可以根据用户的需求动态调整存储容量,无需担心物理存储设备的容量限制。

灵活性:用户可以在任何有网络连接的地方访问存储在云端的数据,提高了数据的可用性和便携性。

成本效益:云存储通常采用按需付费的模式,用户只需支付实际使用的存储空间费用,降低了存储成本。

高可靠性:云存储服务提供商通常会采用多重冗余和备份机制来确保数据的安全性和可靠性。

二、CUN存储的类型

1、对象存储:

对象存储是云存储中最常见的一种类型,它将数据以对象的形式存储在分布式系统中,每个对象都有一个唯一的标识符,可以通过这个标识符快速访问对象,对象存储适用于存储非结构化数据,如图片、视频、日志文件等。

2、文件存储:

文件存储允许用户将文件存储在云端,并通过标准的文件协议(如NFS、CIFS)进行访问,文件存储适用于需要共享文件的场景,如团队协作、企业文档管理等。

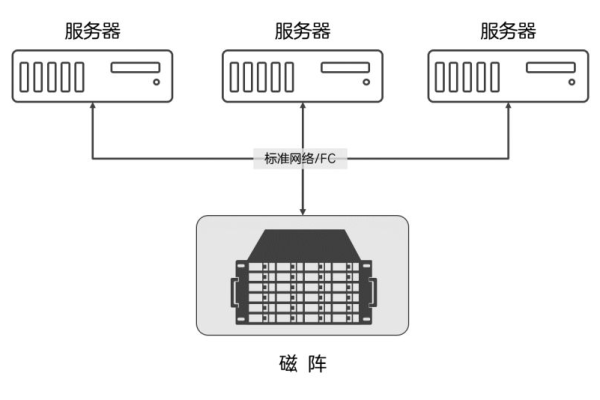

3、块存储:

块存储将存储空间划分为多个固定大小的块,每个块可以独立地被分配给不同的服务器或虚拟机使用,块存储适用于需要高性能和低延迟的应用场景,如数据库、高性能计算等。

4、归档存储:

归档存储是一种低成本、高持久性的存储方式,适用于长期保存不经常访问的数据,归档存储通常采用冷存储技术,以降低能耗和维护成本。

三、CUN存储的应用场景

1、数据备份与恢复:

云存储可以作为数据备份的理想选择,用户可以将重要数据定期备份到云端,以防止数据丢失或损坏,在需要恢复数据时,用户可以快速从云端恢复数据。

2、大数据分析:

云存储提供了强大的计算能力和存储能力,非常适合用于大数据分析,用户可以将大量数据存储在云端,并利用云端的计算资源进行数据处理和分析。

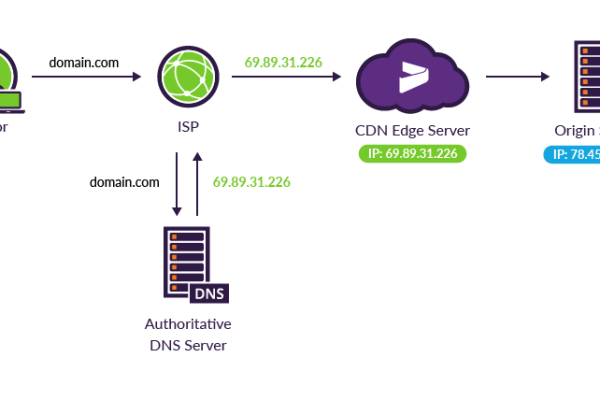

3、内容分发与流媒体:

云存储可以用于存储和分发大量的内容,如图片、视频、音频等,通过内容分发网络(CDN),云存储可以将这些内容快速分发到全球各地的用户手中。

4、物联网(IoT)应用:

随着物联网的发展,大量设备产生的数据需要被存储和处理,云存储可以为物联网应用提供可靠的数据存储和分析平台。

5、企业协作与文档管理:

云存储允许团队成员在不同地点同时访问和编辑文档,提高了工作效率和协作效果,云存储还可以提供版本控制和权限管理等功能,确保文档的安全性和完整性。

四、CUN存储的优势与挑战

1、优势:

成本效益:云存储降低了企业的硬件投资和维护成本。

灵活性与可扩展性:云存储可以根据业务需求快速调整存储容量和性能。

高可靠性与安全性:云存储服务提供商通常采用先进的技术和安全措施来保护用户数据的安全。

便捷性:用户可以通过任何设备随时随地访问存储在云端的数据。

2、挑战:

数据隐私与合规性:随着数据泄露事件的增多,用户对数据隐私和合规性的关注度越来越高,云存储服务提供商需要加强数据安全和隐私保护措施。

网络依赖性:云存储的性能和可用性受到网络条件的影响,在网络不稳定或中断的情况下,用户可能无法正常访问存储在云端的数据。

技术复杂性:对于一些复杂的应用场景和技术需求,云存储可能需要更多的技术支持和专业知识来实现。

CUN存储作为一种高效、灵活且成本效益高的存储方式,在现代数据管理中发挥着越来越重要的作用,随着云计算技术的不断发展和完善,相信CUN存储将会在未来发挥更加重要的作用。

五、FAQs

1、Q: CUN存储是否适合所有类型的数据?

A: 虽然CUN存储具有广泛的适用性,但并非所有类型的数据都适合存储在云端,对实时性要求极高的数据可能更适合本地存储解决方案,敏感数据也需要额外的加密和安全措施来确保其安全性。

2、Q: CUN存储的费用是如何计算的?

A: CUN存储的费用通常基于实际使用的存储空间、数据传输量以及所选服务级别来计算,不同的云存储服务提供商可能有不同的计费模式,因此建议在选择提供商之前仔细比较不同方案的价格和服务内容。

六、小编有话说

CUN存储以其独特的优势正在逐渐改变我们的数据管理方式,它不仅提供了前所未有的灵活性和可扩展性,还大大降低了企业的运营成本,我们也应清醒地认识到CUN存储所面临的挑战,特别是在数据隐私和网络安全方面,在选择CUN存储解决方案时,我们必须综合考虑各种因素,确保我们的数据得到妥善的保护和管理。