cpu深度学习加速

- 行业动态

- 2025-02-13

- 5

在深度学习领域,CPU作为重要的计算资源,其性能优化对于加速模型训练和推理至关重要,以下是关于CPU深度学习加速的详细探讨:

1、环境准备与模型加载

安装必要库:使用pip安装PyTorch、ONNX以及ONNX Runtime等库,这些库为后续的模型加载、转换和推理提供了基础支持。

加载预训练模型:以PyTorch为例,通过torchvision模块加载预定义的模型,如ResNet18,并设置模型为评估模式,以便进行推理任务。

2、模型优化

转换为ONNX格式:将模型导出为ONNX格式,使其能够在不同的推理引擎上运行,提高模型的可移植性和执行效率。

简化模型结构:考虑使用轻量级的网络架构,如MobileNet或SqueezeNet,减少计算量,从而加快推理速度。

3、代码优化

使用高效库:利用TensorFlow和PyTorch等优化过的深度学习库,并在训练时启用MKL(Math Kernel Library)或OpenBLAS等数学库来加速计算。

多线程和并行处理:使用Python的concurrent.futures模块实现多线程并行处理,提高CPU的利用率。

4、数据预处理

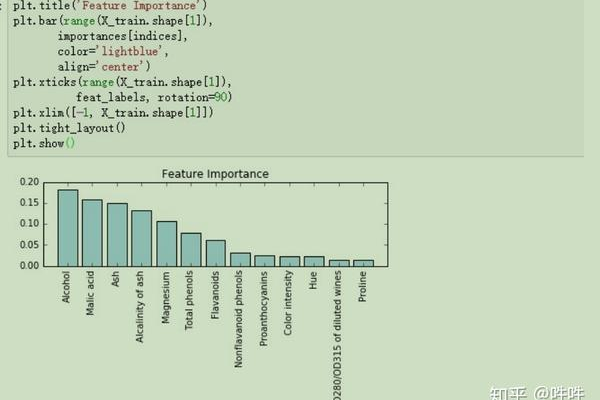

数据缩放:通过减少输入数据的尺寸,降低计算需求。

更改数据类型:使用更小的数据类型(如float16代替float32),减少内存占用和计算量。

5、硬件加速技术

英特尔高级矩阵扩展(AMX):英特尔至强可扩展处理器中的AMX技术,通过专用的矩阵计算单元加速底层矩阵计算,显著提升AI推理和训练性能。

其他内置加速器:包括数据流加速器(DSA)、英特尔存内分析加速器(IAA)和数据保护与压缩加速技术(QAT)等,分别提升数据存储与传输性能、数据库和数据分析应用的性能以及数据压缩吞吐量。

6、监控与调整

资源监控:使用psutil库监控CPU使用率和内存占用率,确保系统资源得到合理利用。

性能调优:根据监控结果适时调整模型参数、批处理大小等超参数,以达到最优性能。

7、实际案例与效果

莱斯大学的SLIDE算法:该算法基于CPU设计,通过哈希表解决深度神经网络的训练问题,实现了比GPU更高的训练速度。

英特尔至强可扩展处理器:第四代至强可扩展处理器通过内置的AMX和其他加速器,实现了相比前一代产品显著的AI性能提升。

CPU深度学习加速是一个涉及多个方面的综合过程,通过环境准备、模型优化、代码优化、数据预处理、硬件加速技术的应用以及持续的监控与调整,可以显著提升CPU在深度学习任务中的性能表现,这些方法不仅适用于个人开发者和研究人员,也为企业在实际应用中部署深度学习模型提供了有力的技术支持。

下面是关于CPU深度学习加速的两个常见问题及解答:

问题1:如何在没有GPU的情况下加速深度学习模型的训练?

答案:在没有GPU的情况下,可以通过以下几种方法加速深度学习模型的训练

1、使用高效的CPU库:利用TensorFlow和PyTorch等优化过的深度学习库,并在训练时启用MKL(Math Kernel Library)或OpenBLAS等数学库来加速计算。

2、简化模型结构:考虑使用轻量级的网络架构,如MobileNet或SqueezeNet,减少计算量,从而加快训练速度。

3、多线程和并行处理:使用Python的concurrent.futures模块实现多线程并行处理,提高CPU的利用率。

问题2:英特尔至强可扩展处理器如何助力AI任务加速?

答案:英特尔至强可扩展处理器通过内置的多种加速器助力AI任务加速

1、英特尔高级矩阵扩展(AMX):通过专用的矩阵计算单元加速底层矩阵计算,显著提升AI推理和训练性能。

2、数据流加速器(DSA):提升数据存储与传输性能。

3、英特尔存内分析加速器(IAA):提升数据库和数据分析应用的性能。

4、数据保护与压缩加速技术(QAT):提升数据压缩吞吐量。

这些加速器共同作用,使得至强可扩展处理器在AI任务的各个环节都能实现性能提升。

小编有话说:CPU深度学习加速是一个复杂而细致的过程,需要综合考虑多个方面,从环境准备到模型优化,再到代码编写和硬件选择,每一步都至关重要,随着技术的不断进步,我们有理由相信,未来CPU在深度学习领域的性能将会更加出色,为人工智能的发展注入新的动力。