Debian能干啥

- 行业动态

- 2025-02-11

- 3

Debian作为一个功能强大且灵活的操作系统,在多个领域都有着广泛的应用,以下是对Debian能做的事情的详细阐述:

1、个人桌面操作系统:Debian可以作为个人桌面操作系统使用,提供了丰富的软件资源和多种桌面环境选择,如GNOME、KDE、Xfce等,用户可以根据自己的喜好和需求进行定制,满足日常办公、娱乐、学习等各种需求。

2、服务器应用:Debian在服务器领域具有很高的知名度和广泛的应用,它可以支持多种服务器软件,如Web服务器(Apache、Nginx等)、数据库服务器(MySQL、PostgreSQL、MongoDB等)、邮件服务器(Postfix、Dovecot等)等,由于其稳定性和安全性,许多企业选择将其作为服务器操作系统来运行关键业务。

3、嵌入式系统:Debian的轻量级特性使其适用于嵌入式设备,能够在资源有限的硬件上运行,它可以为物联网设备、智能家居设备、工业控制系统等提供稳定可靠的操作系统支持,并且可以根据具体的应用场景进行定制和优化。

4、开发平台:Debian提供了丰富的开发工具和库,如GCC编译器、Python解释器等,方便开发人员进行软件开发,基于Linux内核的Debian还拥有强大的命令行工具,可用于各种开发任务,从简单的脚本编写到复杂的系统编程都能轻松应对。

5、教育用途:作为一款免费、开源、教育友好的操作系统,Debian被广泛应用于学校、培训机构和教育项目中,它提供了丰富的教育资源,如教育软件、课程资料等,有助于学生和教师进行教学和学习活动。

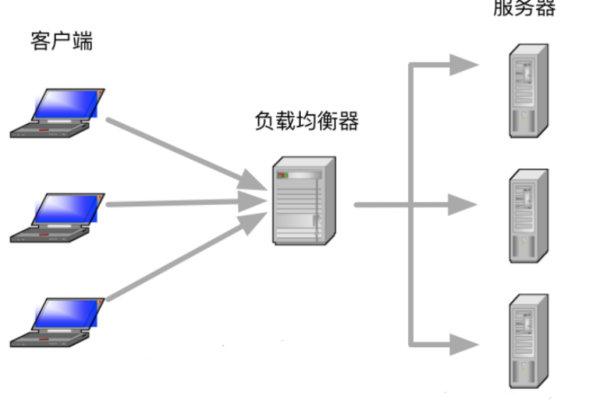

6、网络管理:Debian的强大网络功能使其成为网络管理的理想选择,用户可以利用Debian搭建局域网、进行远程控制,还可以配置各种网络服务,如DHCP服务器、DNS服务器等,Debian支持多种网络协议,方便与其他设备进行通信和数据交换。

7、家庭娱乐中心:除了上述应用外,Debian还可以作为家庭娱乐中心使用,用户可以在Debian上搭建家庭影院系统、媒体服务器,播放各种格式的音频和视频文件,Debian还支持多种游戏平台,如Steam、PlayStation等,为游戏玩家提供了更多的选择。

8、云计算:在云计算领域,Debian也发挥着重要作用,它可以作为云计算基础设施的操作系统,提供虚拟化和容器技术支持,运行在云计算平台上,为用户提供弹性计算资源和云服务,Debian也可以作为云计算平台的操作系统,支持应用程序的部署和运行,帮助开发者快速构建、部署和管理云原生应用。

Debian是一个多功能、灵活且强大的操作系统,无论是个人用户还是企业用户,都可以根据自己的需求和场景选择使用Debian,并享受到其带来的便利和优势。