如何确认服务器已成功安装MySQL?

- 行业动态

- 2025-01-17

- 7

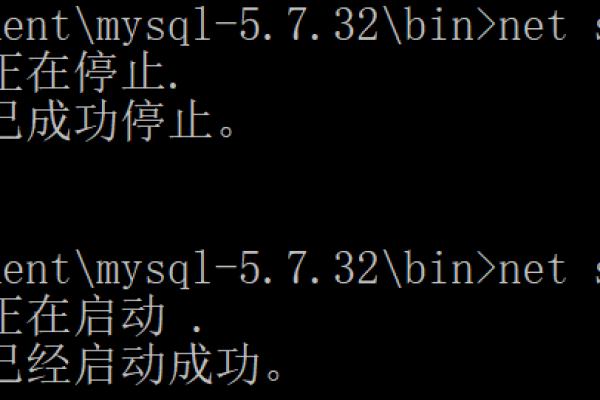

服务器已成功安装 MySQL,可以开始进行数据库的创建和管理操作。

服务器安装MySQL成功

在服务器上安装MySQL数据库是一个多步骤的过程,需要从选择合适的版本开始,到配置、启动服务以及设置用户权限,以下是详细的步骤和注意事项:

| 步骤 | 描述 | 命令/操作 |

| 1. 选择MySQL版本 | 根据服务器的操作系统版本、硬件配置以及业务需求选择合适的MySQL版本,社区版适合中小型企业和个人开发者,企业版提供更多高级功能和技术支持,适合大型企业使用。 | 访问MySQL官方网站下载对应版本。 |

| 2. 下载MySQL安装包 | 确保下载与操作系统版本匹配的安装包。 | wget https://dev.mysql.com/get/mysql57-community-release-el7-11.noarch.rpm(以CentOS为例) |

| 3. 安装MySQL | 使用包管理工具或手动安装下载的安装包。 | yum localinstall mysql57-community-release-el7-11.noarch.rpm 和yum install mysql-community-server |

| 4. 启动MySQL服务 | 配置完成后,启动MySQL服务并设置开机自启。 | systemctl start mysqld 和systemctl enable mysqld |

| 5. 检查MySQL服务状态 | 确保MySQL服务正常运行。 | systemctl status mysqld |

| 6. 设置root用户密码 | 为root用户设置密码,并进行其他安全配置。 | mysql_secure_installation |

| 7. 登录MySQL并修改密码 | 登录MySQL后,可以修改root密码或创建新用户。 | mysql -u root -p 和ALTER USER 'root'@'localhost' IDENTIFIED BY 'NewPassword!'; |

| 8. 授权远程访问 | 如果需要,配置MySQL以允许远程访问。 | GRANT ALL PRIVILEGES ON *.* TO 'root'@'%' IDENTIFIED BY 'rootpassword' WITH GRANT OPTION; FLUSH PRIVILEGES; |

| 9. 开放防火墙端口 | 确保防火墙允许MySQL的默认端口3306。 | firewall-cmd --permanent --add-port=3306/tcp 和firewall-cmd --reload |

| 10. 备份与恢复 | 定期备份MySQL数据库以防止数据丢失。 | mysqldump -u root -p --all-databases > all_databases_backup.sql(备份)和mysql -u root -p(恢复) |

| 11. 性能监控与调优 | 使用性能监控工具监控数据库性能,并根据实际需求调整MySQL参数。 | Performance Schema、InnoDB Monitor等 |

| 12. 安全性配置 | 包括网络安全、用户权限管理、SSL加密等。 | 配置防火墙、SSL证书、最小权限原则等 |

常见问题及解答

问题1: 无法启动MySQL服务怎么办?

答:如果无法启动MySQL服务,首先检查配置文件是否正确,特别是my.cnf文件中的配置项,然后查看日志文件/var/log/mysqld.log中的错误信息,根据错误提示进行相应的修复,如果问题依然存在,可以尝试重新安装MySQL或者寻求更专业的帮助。

问题2: 如何更改MySQL的默认端口号?

答:要更改MySQL的默认端口号,需要编辑MySQL的配置文件my.cnf(通常位于/etc/my.cnf或/etc/mysql/my.cnf),找到[mysqld]部分下的port配置项,将其值更改为新的端口号(例如3307),保存更改后,重新启动MySQL服务使更改生效,确保防火墙规则允许新端口上的通信。

小编有话说

安装和配置MySQL看似复杂,但只要按照步骤细心操作,其实并不困难,重要的是理解每一步的目的和作用,这样才能在遇到问题时迅速定位并解决,随着技术的不断发展,MySQL也在不断更新和优化,建议定期关注官方文档和社区动态,以便获取最新的信息和最佳实践,不要忘记备份你的数据,这是保障数据安全的最后一道防线。