服务器应用存储备份分开

- 行业动态

- 2025-02-12

- 3

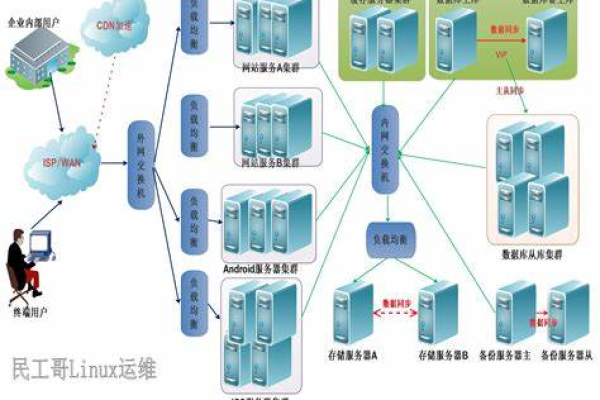

在当今数字化时代,服务器应用的存储与备份分开是一种常见且重要的实践,以下是关于这一主题的详细阐述:

服务器应用存储备份分开的意义

数据安全性提升

防止单点故障:当服务器应用的存储和备份分开时,即使存储设备出现故障,如硬盘损坏、磁盘阵列故障等,备份数据仍然可以在独立的存储介质或位置中保留完好,这样,企业可以迅速恢复业务运营,减少因数据丢失而导致的业务中断时间和经济损失。

抵御反面攻击:将存储和备份分开可以降低数据被反面攻击的风险,如果服务器受到干扰、勒索软件等反面软件的攻击,攻击者可能无法同时获取存储和备份中的数据,从而增加了数据的安全防护层级。

提高数据管理效率

灵活的数据访问和恢复:分开存储和备份可以使企业根据不同的需求灵活地管理数据,对于频繁访问的应用数据,可以存储在高性能的存储设备中,以提高数据的读写速度;而对于备份数据,可以选择成本较低的存储介质进行长期保存,在需要恢复数据时,可以根据具体情况快速定位和恢复相应的备份数据,提高数据恢复的效率。

便于数据分类和整理:通过将存储和备份分开,企业可以更方便地对数据进行分类和整理,不同类型的数据可以根据其重要性、使用频率等因素分别存储和备份,有助于更好地管理和保护数据资产。

实现服务器应用存储备份分开的方法

| 方法 | 描述 | 优点 | 缺点 |

| 本地存储与异地备份 | 将应用数据存储在本地服务器的硬盘或其他存储设备上,同时将备份数据存储在异地的数据中心或云存储中。 | 数据传输速度快,适合对实时性要求高的应用;备份数据与本地数据隔离,安全性高。 | 需要投入额外的资源用于异地数据中心的建设和维护;可能会受到网络带宽的限制,影响备份和恢复的速度。 |

| 存储区域网络(SAN)与备份服务器 | 构建存储区域网络,将多个存储设备连接成一个共享的存储池,供服务器应用使用;同时设置专门的备份服务器,定期从SAN中复制数据进行备份。 | 存储资源集中管理,方便扩展和共享;备份过程自动化程度高,减少人工干预。 | SAN的建设成本较高,需要专业的技术人员进行维护;备份服务器的性能和容量需要根据数据量的增长不断调整。 |

| 云存储与本地备份 | 将应用数据存储在云服务提供商的云存储中,同时在本地设置备份设备,定期从云存储中下载数据进行备份。 | 无需企业自行建设和维护存储基础设施,降低了成本;云存储具有高度的可扩展性和灵活性。 | 依赖网络连接的稳定性,如果网络中断,可能会影响数据的访问和备份;数据隐私和安全性可能受到云服务提供商的管理和技术能力的影响。 |

相关问答FAQs

问题1:如何选择合适的存储和备份方案?

答:在选择存储和备份方案时,需要综合考虑多个因素,如数据的重要性、数据量的大小、业务的需求、预算等,如果对数据的实时性和安全性要求较高,且预算充足,可以考虑采用本地存储与异地备份的方式;如果希望降低成本,同时又能保证一定的数据安全性和可扩展性,云存储与本地备份可能是一个不错的选择,还需要根据实际情况评估不同方案的性能、可靠性和易用性等方面的特点,选择最适合自己企业的方案。

问题2:如何确保备份数据的完整性和可用性?

答:为确保备份数据的完整性和可用性,可以采取以下措施:一是定期进行备份数据的校验和验证,检查数据是否完整、准确;二是采用冗余存储技术,如RAID(独立磁盘冗余阵列)等,提高备份数据的可靠性;三是制定完善的备份策略,包括备份的频率、保留的时间等,确保在需要时能够及时恢复数据;四是进行定期的灾难恢复演练,检验备份数据的可用性和恢复流程的有效性。

小编有话说

服务器应用的存储与备份分开是保障数据安全和管理效率的重要措施,企业在实施过程中,应根据自身的实际情况选择合适的方法和策略,并不断加强对数据的保护和管理,以应对日益复杂的数据安全挑战。