如何在dedeCMS中实现首页调用公司简介内容?

- 行业动态

- 2024-10-20

- 5

在DedeCMS中,首页调用公司简介的方法是通过在首页模板文件中使用标签来获取公司简介的内容。具体操作如下:,,1. 在 DedeCMS后台添加一个自定义宏标记,{dede:mycompany}

,并在该宏标记的参数中设置好公司简介的相关信息,如公司名称、地址、联系方式等。,,2. 在首页模板文件(通常是index.htm )中找到需要显示公司简介的位置,插入以下代码:,,` html,{dede:mycompany},“,,3. 保存修改后的模板文件,并更新网站缓存。这样,在访问首页时,就会自动调用并显示公司简介的内容。

在Dedecms系统中,首页调用公司简介的内容可以通过多种方法实现,以下是一些常见的方法:

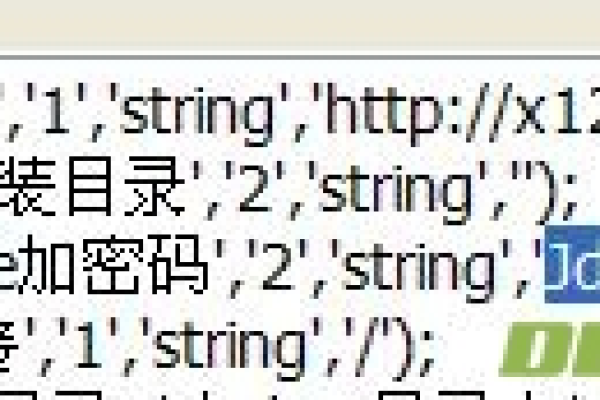

方法一:使用SQL语句调用

1、基本SQL语句:

通过SQL语句可以直接从数据库中提取指定栏目的内容,要调用ID为1的栏目内容,可以使用以下代码:

{dede:sql sql='Select content from dede_arctype where id=1'}

[field:content/]

{/dede:sql} 如果需要截取部分内容,可以使用substring函数或cn_substr函数,截取前100个字符:

{dede:sql sql='Select content, substring(content, 1, 100) as content from dede_arctype where id=1'}

[field:content/]

{/dede:sql} 2、带HTML标签截取:

如果内容包含HTML标签,可以先去除HTML标签再进行截取:

{dede:sql sql='Select content, substring(Html2text(content), 1, 100) as content from dede_arctype where id=1'}

[field:content function="cn_substr('@me', 100)"/]

{/dede:sql} 方法二:使用DedeCMS内置标签

1、{dede:channelartlist}标签:

这个标签可以用于调用顶级栏目的单页内容,要调用关于我们页面的内容,可以使用:

{dede:channel type="top" row=1}

[field:array runphp='yes'] global $dsql; @me ...

{/dede:channel} 2、{dede:arclist}标签:

如果要调用某篇文章的内容和简介,可以使用:

{dede:arclist idlist='指定文章ID号' titlelen='24' infolen='200'}

[field:description function='cn_substr(@me,200)'/]

{/dede:arclist} 方法三:使用自定义函数

1、自定义标签调用:

可以在模板文件中编写自定义函数来调用指定栏目的内容,这种方法更加灵活,可以根据具体需求进行调整。

方法都可以实现在Dedecms首页动态地调用公司简介或其他单页内容,根据具体需求和网站结构选择合适的方法,可以确保内容的准确展示和网站的优化效果。