MapReduce 中的 Map 阶段仅负责收集数据吗?

- 行业动态

- 2024-08-18

- 4648

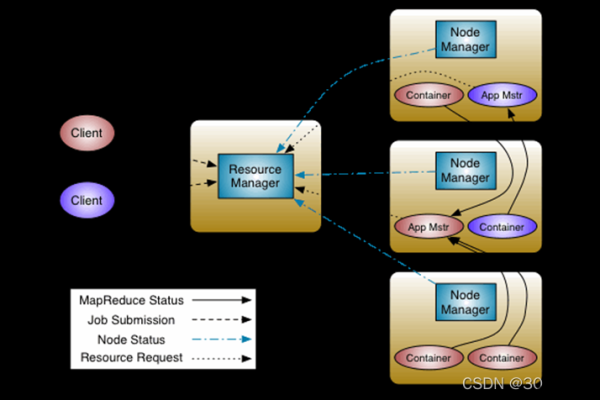

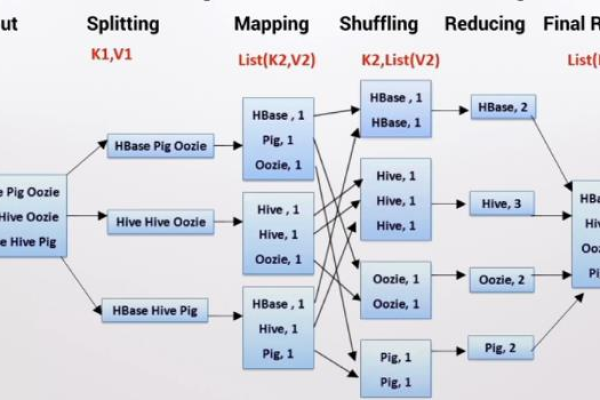

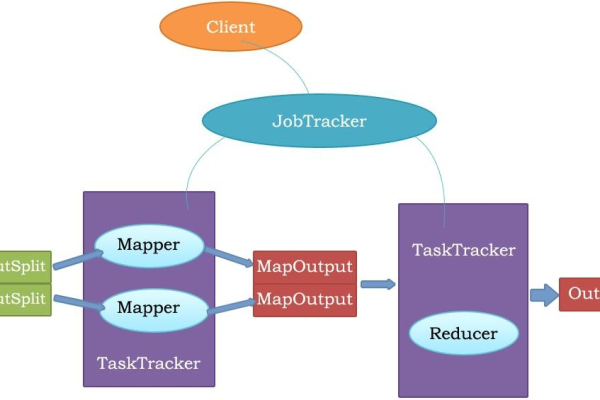

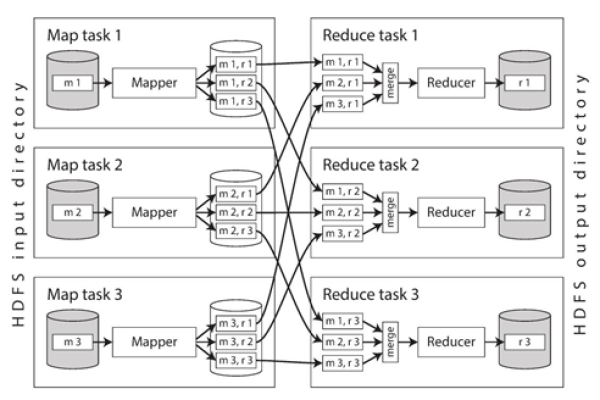

MapReduce是一种编程模型,用于大规模数据集(大于1TB)的并行运算。概念”Map(映射)”和”Reduce(归约)”是这个模型的主要思想。在映射阶段,系统对输入数据进行分割并分配给多个处理器并行处理。每个处理器输出中间键值对。在归约阶段,这些中间结果根据键进行汇总,以生成最终结果。

1、数据准备阶段

在MapReduce框架中,数据的准备工作是第一步,输入的数据集存储在分布式文件系统(如HDFS)上,根据配置的数据块大小(block size),数据集被自动分割成多个数据块,这些数据块随后被分配给不同的Map任务进行处理,每个Map任务负责处理一个或多个数据块,将数据转化为键值对的形式,以便后续的处理。

2、Mapper函数的应用

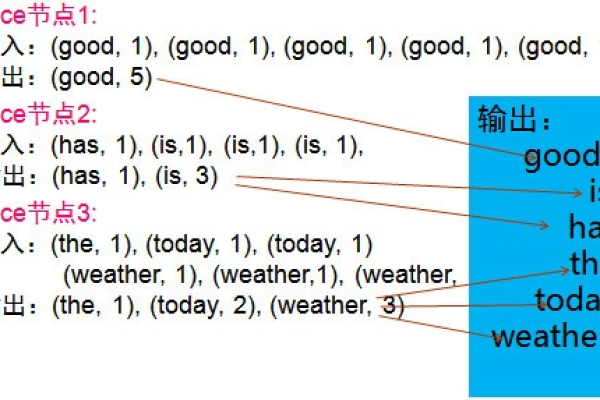

Mapper函数是MapReduce模型中用户自定义的处理逻辑,它决定了如何从输入数据中提取出键值对,在Map阶段,每个Mapper任务会独立运行用户定义的Mapper函数,这个函数接收原始数据作为输入,通过解析和转换,输出中间键值对,一个简单的Mapper函数可能会读取文本文件中的每一行,然后将每行拆分成单词,并输出每个单词及其出现次数。

3、中间键值对的生成

Map阶段的输出被称为“中间数据”,这是因为这些数据还需要经过Shuffle和Sort等后续步骤才会被传递给Reduce阶段,在Map任务完成数据处理后,生成的键值对会被暂时存储在本地磁盘上,为了优化存储和后续处理的效率,这些中间键值对通常会按照键进行排序,并可能进行本地的合并操作(combine)。

4、数据分区

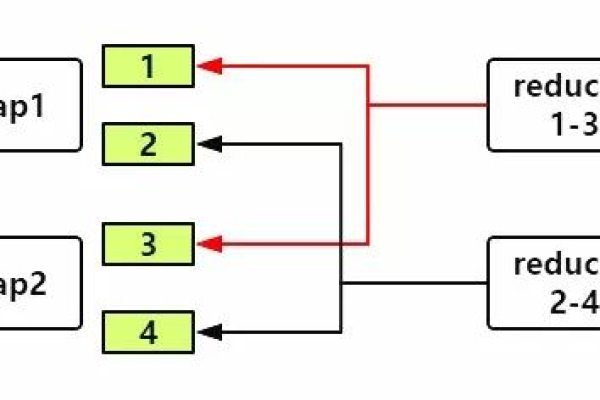

在MapReduce中,数据分区是一个关键步骤,它决定了哪些键值对会交由特定的Reduce任务处理,分区通常基于键的哈希值进行,这样可以确保具有相同键的键值对总是被发送到同一个Reduce任务,这种分区策略有助于实现数据的负载均衡,提高处理效率。

5、数据持久化

尽管Map阶段的输出存储在本地磁盘上,但为了保证系统的容错性,这些数据还会被复制到其他节点上,这一过程通常通过分布式文件系统自身的机制来实现,确保在任何节点失败的情况下,数据不会丢失,并且可以迅速地在另一个节点上恢复处理。

本文将深入探讨MapReduce中的Map阶段细节:

Map阶段的深入分析

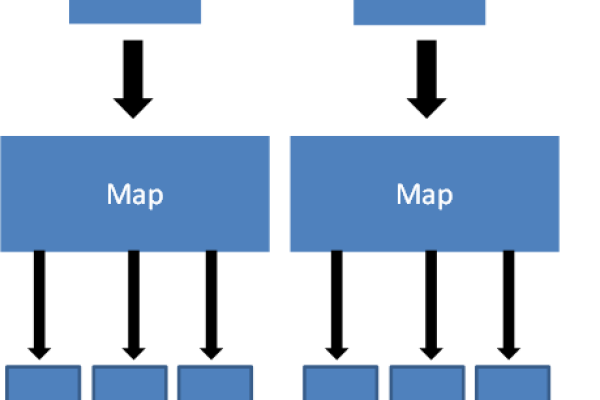

1、输入分片:在MapReduce框架中,输入数据首先需要被分割成多个分片,每个分片包含一定数量的数据块,这个过程是自动进行的,通常由框架根据数据的总大小和预设的分片大小决定,每个分片将被分配给一个Mapper任务进行处理。

2、映射函数:用户需编写具体的映射函数,该函数定义了如何处理每个数据块中的记录,如果输入是文本数据,映射函数可能会遍历每一行,提取出关键字,并生成关键字与频率的键值对。

3、中间键值对:映射函数的输出形成了一系列的中间键值对,这些键值对将被用于下一阶段的数据处理,在这个阶段,中间键值对通常会被缓存在内存中,如果内存不足,则会写入到磁盘中。

4、分区:Map阶段的输出必须进行分区处理,以确保具有相同键的键值对能够被同一个Reducer处理,分区通常根据键的哈希值进行,这样可以平均分布数据到各个Reducer。

5、Combiner:为了减少数据传输的开销,可以在Map端使用Combiner来对中间键值对进行局部聚合,这有助于减少数据在网络间的传输量,优化整体的处理速度。

Map阶段在MapReduce框架中扮演着至关重要的角色,它负责数据的初始处理和转换,通过合理设计映射函数,可以有效地生成和管理中间键值对,为后续的数据处理打下坚实的基础,了解和掌握Map阶段的工作原理及其相关技术细节,对于开发高效的MapReduce应用程序至关重要。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/147876.html