如何使用MapReduce中的Java API来优化数据处理任务?

- 行业动态

- 2024-08-17

- 3495

本文介绍了MapReduce的Java API接口,详细阐述了如何在Java中实现MapReduce编程模型。通过使用这些API,开发者可以方便地编写分布式数据处理任务,实现大规模数据集的高效处理。

在大数据领域,处理海量数据集是一项常见而重要的任务,MapReduce模型提供了一个简便的方法来并行处理数据,通过将计算任务分配到多个节点上同时运行,可以显著提高处理速度,Java API for MapReduce允许开发者利用Java语言编写MapReduce程序,这为Java开发者提供了便利,具体如下:

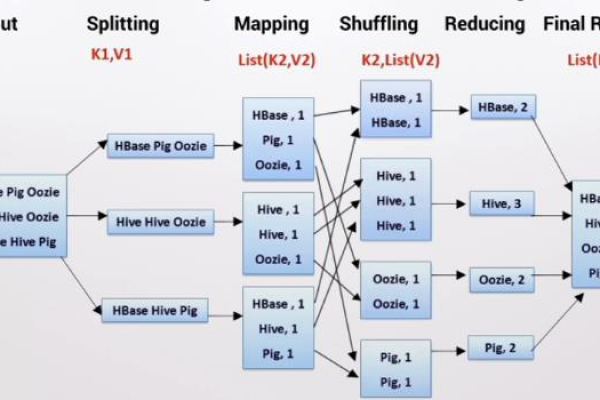

1、MapReduce程序的基本原理

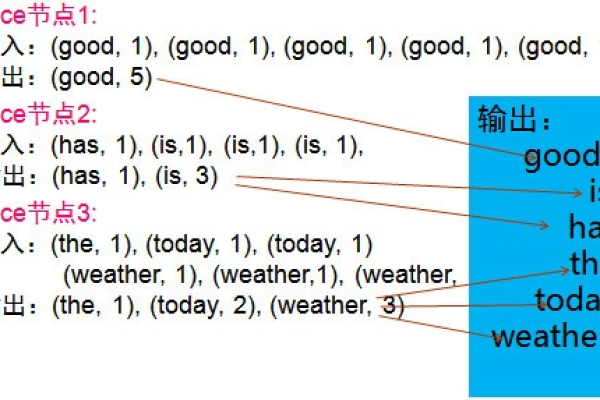

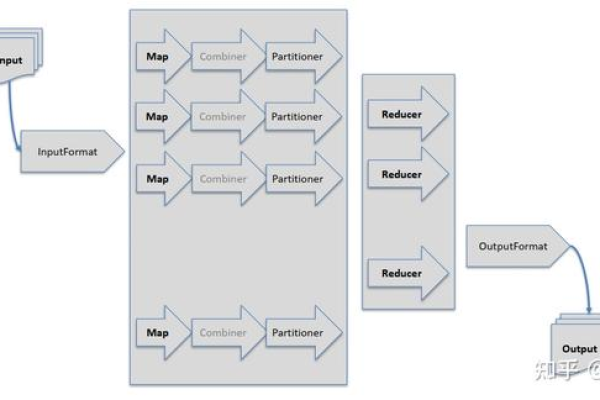

Map阶段:Map函数接收输入数据,然后将其转换为键值对形式的中间结果,这个阶段的主要作用是数据筛选和分类。

Shuffle阶段:框架会自动对Map阶段的输出进行排序和分组,确保具有相同键的值被一起传递给下一个阶段。

Reduce阶段:Reduce函数则接收Shuffle阶段后的输出数据,并将其汇总得到最终结果,这一阶段用于数据的最终聚合操作。

2、核心Java API接口

Mapper接口:开发者需要实现map方法,定义如何处理每个输入数据块并生成中间的键值对。

Reducer接口:开发者需实现reduce方法,指定如何对具有相同键的值进行归约处理。

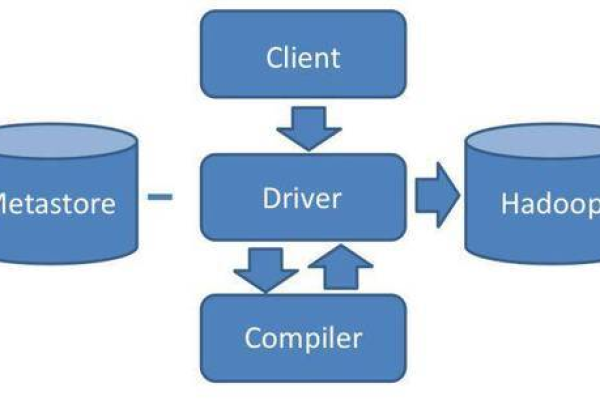

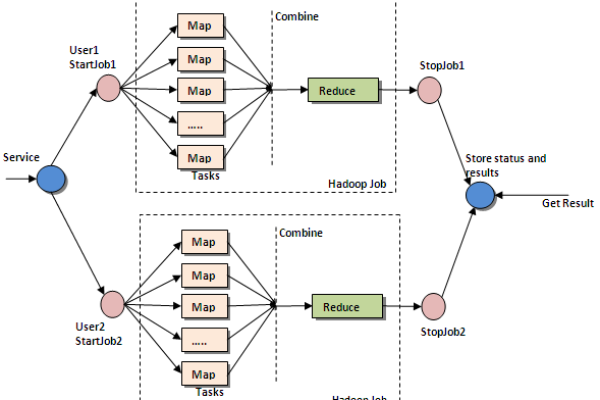

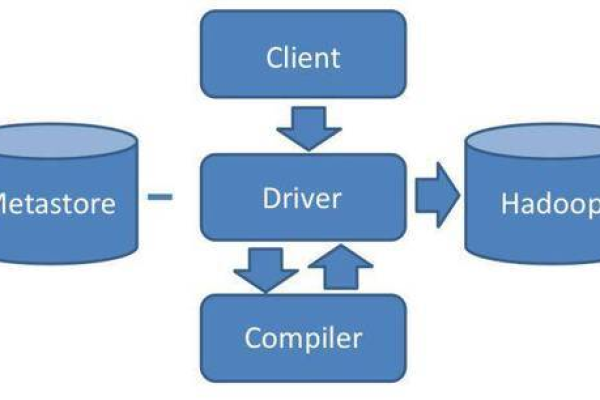

Driver编程:除了实现Mapper和Reducer外,还需要编写驱动程序,用于配置和提交MapReduce作业。

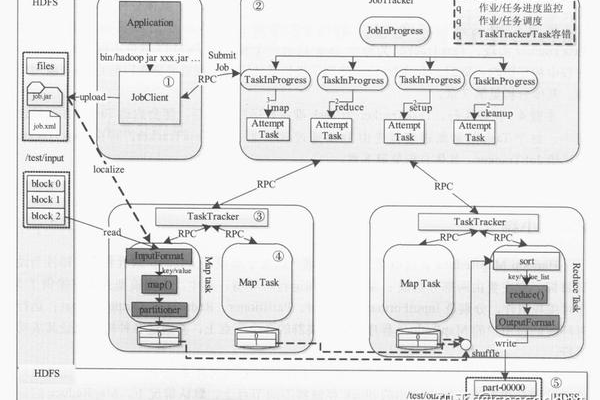

3、环境搭建和配置

依赖配置:使用MapReduce Java API前,需要确保环境中已正确安装并配置了Java和Hadoop。

IDE集成:大多数开发环境如Eclipse或IntelliJ IDEA可以方便地集成Hadoop支持,使得开发和调试MapReduce程序更为便捷。

4、编译和运行

代码编译:编写完成后,需要使用Java编译器将程序编译成可执行的JAR文件。

命令行运行:通过Hadoop命令行工具,可以方便地提交和管理MapReduce作业。

5、高级特性和优化

输入输出格式:MapReduce支持多种数据输入输出格式,包括文本、序列化文件等,这可以根据具体需求选择最合适的格式。

性能优化:合理设置MapReduce作业参数,如调整Map和Reduce任务的数量,可以优化作业的执行效率和资源消耗。

在利用MapReduce Java API进行开发时,不仅需要掌握基本的程序编写技巧,也需要了解如何在实际应用中根据数据特征和业务需求进行优化,持续跟进Hadoop生态系统的最新发展,也是提升工作效率和质量的关键,通过不断学习和实践,开发者可以更好地利用MapReduce模型处理大规模数据集,解决复杂的数据处理问题。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/147462.html