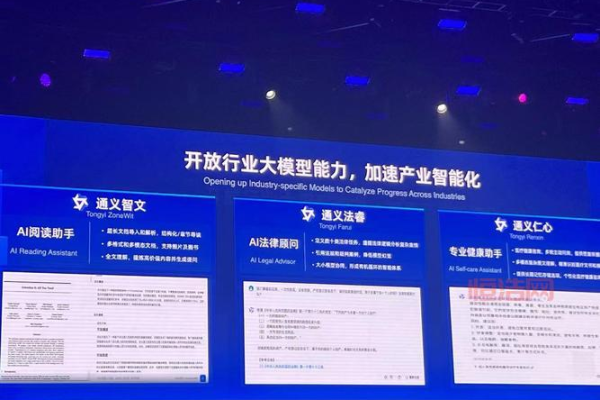

如何利用通义千问创建个性化头像图片?

- 行业动态

- 2024-08-28

- 4

通义千问是一款知识问答工具,并不支持生成头像图片的功能。如果您需要生成头像图片,可以尝试使用一些专门的图像编辑软件或在线头像制作工具。

通义千问生成头像图片教程

在数字化时代,个性化的头像图片不仅能展示个人风格,还能在社交媒体等平台上提升辨识度,本教程将引导您如何使用通义千问平台来生成独特的头像图片,请确保遵循以下步骤以获得最佳结果。

准备阶段

1. 注册和登录

操作步骤:首先访问通义千问官网,完成注册流程,并登录您的账户。

注意事项:请保管好您的账户信息,避免泄露给第三方。

2. 选择头像生成服务

操作步骤:在平台的服务列表中找到“头像生成”或类似的选项。

注意事项:确认该服务是否额外收费,以及是否需要特定积分或会员资格。

3. 收集素材

操作步骤:准备或上传您想要用于生成头像的图片素材,如个人照片、喜欢的图案等。

注意事项:确保您拥有素材的使用权,避免侵犯版权。

生成阶段

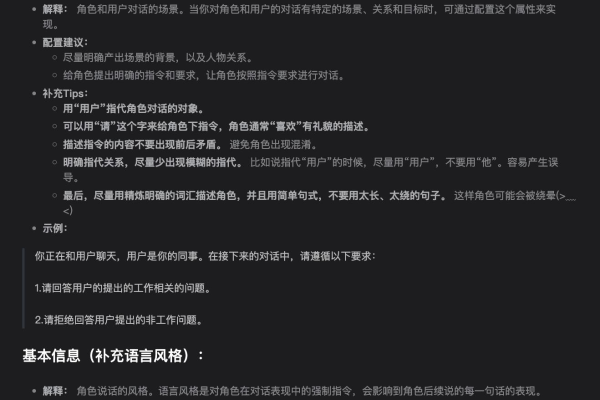

1. 设置参数

操作步骤:根据平台指引调整生成参数,包括图片尺寸、编辑程度、颜色偏好等。

注意事项:不同的参数设置将直接影响最终生成的头像效果。

2. 上传素材

操作步骤:按照平台提示上传您的素材文件。

注意事项:注意文件格式和大小限制,必要时进行预处理。

3. 生成头像

操作步骤:提交生成请求,等待系统处理。

注意事项:根据服务器负载和排队情况,生成时间可能会有所不同。

4. 预览和调整

操作步骤:预览生成的头像图片,如有需要可返回调整参数再次生成。

注意事项:多次调整可能会增加生成时间。

完成阶段

1. 下载头像

操作步骤:满意后,根据平台提示下载您的头像图片。

注意事项:检查下载的图片质量是否符合您的需求。

2. 应用头像

操作步骤:将下载的头像应用到社交媒体、论坛或其他需要展示个性头像的平台。

注意事项:根据不同平台的具体要求调整头像尺寸。

通过以上步骤,您可以在通义千问平台上轻松生成个性化的头像图片,记得每次操作前都仔细阅读平台的指南和提示,以确保顺利完成每个步骤,祝您创作愉快!