如何获取变频器源码的完整信息?

- 行业动态

- 2024-10-04

- 1

变频器源码通常涉及复杂的电机控制算法和硬件接口,不适宜在此简短回答中详述。

变频器源码是一种用于控制电动机转速和转矩的电子设备,广泛应用于工业控制领域,以下是对变频器源码的详细介绍:

概述

定义与作用:变频器(Variablefrequency Drive, VFD)是一种电源控制装置,主要用于调节电机的转速和转矩,它通过改变电机工作电源的频率来控制交流电动机,具有节能、调速等功能。

应用领域:变频器广泛应用于纺织、印染、石油、化工、制药、木工、造纸等行业,以及风机、泵类等负载的调速节能。

主要功能

变频节能:通过改变电机工作电源的频率,实现节能调速。

无级调速:能够实现电机的无级调速,满足不同工艺条件下的生产需求。

智能控制:采用闭环控制算法,如SVC3算法,实现对电机的精确控制和高效运行。

保护功能:具备过流、过压、过载等多种保护功能,确保电机的安全运行。

技术特点

低速转矩大:采用磁场定位控制和电流闭环控制等技术,实现低速时的大转矩输出。

高速速度波动小:通过速度闭环控制和噪声抑制设计,减小高速运行时的速度波动。

转子电阻和漏感辨识:引入新的辨识方法,提高系统的控制性能和稳定性。

源码分析

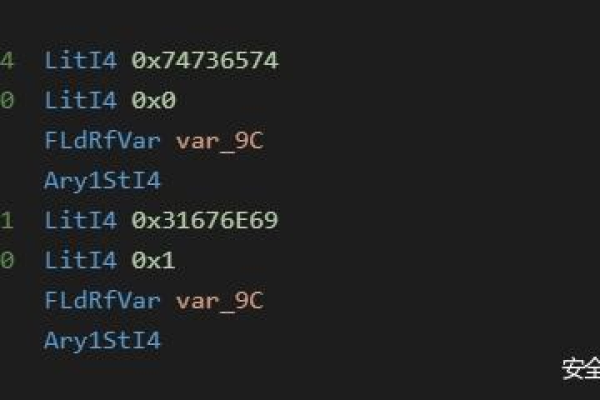

C语言编写:汇川MD500、MD380等变频器源码基于C语言编写,具有高度的可编译性和功能完整性。

算法优化:77版源码相较于71.01版在算法上进行了优化,如引入了新的SVC3算法和转子电阻、漏感辨识算法,提高了系统的性能和稳定性。

硬件支持:源码基于TMS320F28035芯片技术,结合实际电机特性和变频器状态,实现对电机参数的自适应估计和精确控制。

变频器源码是工业控制领域中不可或缺的一部分,其高效稳定的电机控制解决方案为工业生产带来了巨大的便利和效益,随着技术的不断进步,变频器将在更多领域发挥重要作用。

以上就是关于“变频器源码”的问题,朋友们可以点击主页了解更多内容,希望可以够帮助大家!

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:https://www.xixizhuji.com/fuzhu/146137.html