服务器全宽刀片是多少存储

- 行业动态

- 2025-03-16

- 5

服务器全宽刀片存储

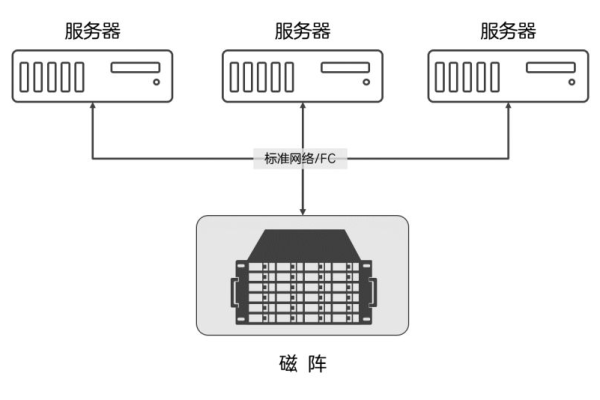

服务器全宽刀片是一种高性能、高密度的服务器设计,通常用于数据中心和云计算环境,这种服务器设计允许多个服务器节点集成到一个单一的机架中,每个节点都可以独立运行操作系统和应用软件,全宽刀片服务器的存储能力取决于多种因素,包括硬盘类型、RAID配置、内存大小以及具体的硬件配置等。

存储组件与配置

1、硬盘类型:

SATA硬盘:传统机械硬盘,容量大但速度较慢。

SSD固态硬盘:速度快,响应时间短,但成本较高。

NVMe SSD:非易失性快速存储器,速度更快,适用于高性能需求。

2、RAID配置:

RAID 0:条带化存储,提高读写速度,但不提供数据冗余。

RAID 1:镜像存储,提供数据冗余,但存储效率较低。

RAID 5/6:提供数据冗余和较高的存储效率,适用于多硬盘配置。

3、内存大小:影响系统性能和虚拟化能力,更大的内存可以支持更多的虚拟机或大型应用。

4、扩展能力:部分全宽刀片服务器支持通过扩展卡增加额外的硬盘或SSD。

示例配置与存储容量

以下是一个示例配置及其大致的存储容量估算:

| 组件 | 描述 | 数量 | 单件容量(GB) | 总容量(GB) |

| 处理器 | 双路Xeon Gold | 2 | ||

| 内存 | DDR4 3200MHz | 4 | 64 | 256 |

| 本地存储 | SATA HDD 7.6K RPM | 4 | 1.92 | 7.68 |

| 本地存储 | NVMe SSD | 2 | 3.84 | 7.68 |

| RAID配置 | RAID 1 (镜像) | |||

| RAID配置 | RAID 5 (至少3块硬盘+1块奇偶校验) | |||

| 总存储容量 | 基于上述RAID配置 | 约15.36 |

注:实际可用存储容量会因格式化、文件系统开销等因素而略有减少。

相关问题与解答

问题1:全宽刀片服务器是否适合所有企业?

解答:不一定,全宽刀片服务器主要适用于需要高密度计算和存储能力的企业,如数据中心、云计算提供商和大型企业,对于小型企业或预算有限的企业来说,传统的塔式或机架式服务器可能更为经济实惠,选择哪种类型的服务器应根据企业的具体需求、预算和技术能力来决定。

问题2:如何根据业务需求选择合适的全宽刀片服务器配置?

解答:选择合适的全宽刀片服务器配置需要考虑以下几个因素:

1、工作负载:分析业务的工作负载类型(如数据库、Web服务、虚拟化等),以确定所需的处理器性能、内存大小和存储类型。

2、存储需求:根据数据量和增长速度选择合适的硬盘类型和RAID配置,如果需要快速访问大量数据,可以考虑使用SSD或NVMe SSD。

3、扩展性:考虑未来业务增长的可能性,选择支持灵活扩展的服务器配置。

4、预算:在满足业务需求的前提下,尽量控制成本,通过优化配置(如选择更高效的RAID级别)可以在不牺牲性能的情况下降低成本。

5、技术支持:确保供应商提供良好的技术支持和服务,以便在遇到问题时能够及时解决。