如何理解MapReduce、MySQL和HDFS_Hive的基本原理及其相互关系?

- 行业动态

- 2024-08-15

- 1

MapReduce是一个编程模型,用于处理和生成大数据集。MySQL是一种流行的关系型数据库管理系统。HDFS是Hadoop的分布式文件系统,用于存储数据。而Hive是一个建立在Hadoop之上的数据仓库基础架构,可以将SQL查询转换为MapReduce任务来执行。

【MapReduce、MySQL、HDFS与Hive基本原理】

在大数据技术栈中,MapReduce、MySQL、HDFS和Hive各自承担着不同的角色,共同构成了数据处理的强大架构,本文将深入探讨这些技术的基本原理及其相互之间的关联。

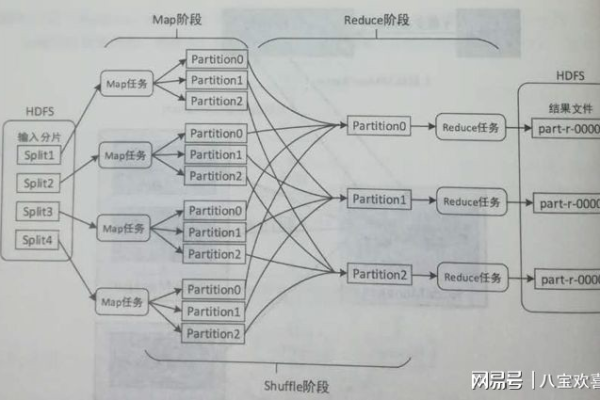

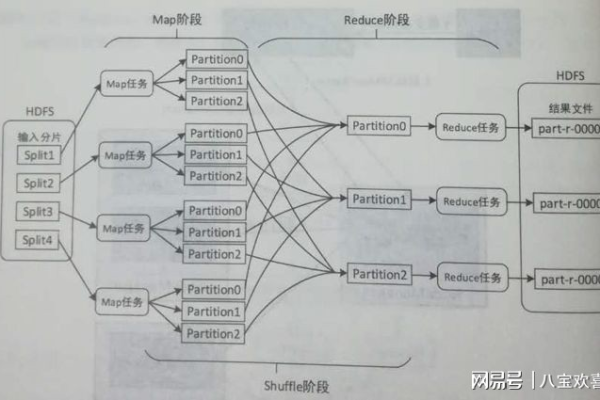

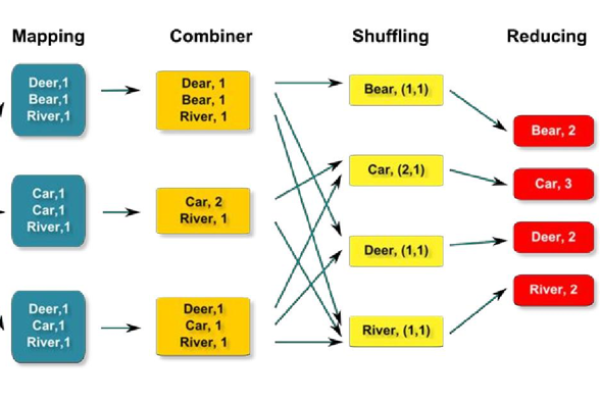

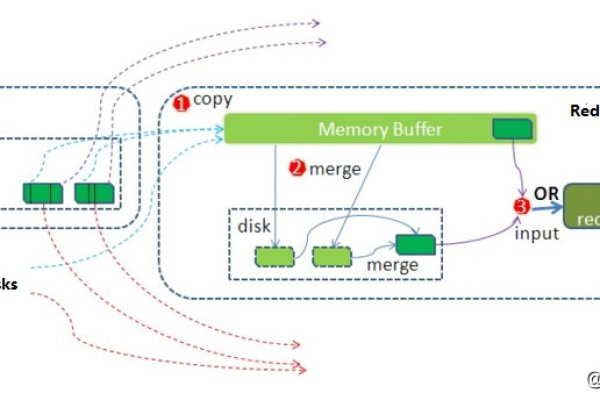

MapReduce是由谷歌提出的一种编程模型,适用于大规模数据集的并行处理,它主要包括两个阶段:Map阶段和Reduce阶段,在Map阶段,系统会将输入数据拆分成独立的数据块,然后由多个处理器并行处理这些数据块,每一块数据都会通过一个Map函数进行处理,生成一组中间键值对,在Reduce阶段,系统会根据中间键值对的键进行排序和分组,再交由Reduce函数处理,以获得最终结果,这种模型非常适合于需要对大量数据进行计数、排序等操作的场景。

MySQL是一种流行的开源关系型数据库管理系统(RDBMS),它使用标准的SQL作为其数据操作语言,MySQL软件提供了一个完整的数据库管理解决方案,包括数据的存储、检索、分析和整理等功能,由于其高性能、稳定性和易用性,MySQL被广泛应用于各种规模的系统中。

HDFS(Hadoop Distributed File System)是Hadoop框架中的分布式文件系统,专为存储大规模数据而设计,HDFS通过将数据块分布在多个计算机节点上,实现了高容错性和高吞吐量的数据访问,HDFS的设计解决了单点故障问题,并能够线性扩展以存储海量数据。

Hive则是基于Hadoop的一个数据仓库工具,它使得用户可以使用类似SQL的查询语言HiveQL来处理存储在HDFS中的数据,Hive的本质是将SQL查询转换为MapReduce程序,然后在Hadoop集群上执行,Hive的出现极大地降低了使用Hadoop进行数据分析的门槛,使得熟悉SQL的开发者可以轻松编写复杂的查询和分析任务。

Hive内部工作流程包括解析器、编译器、优化器和执行器,当用户提交一个HiveQL查询时,解析器首先对其进行解析,编译器将SQL语句编译成MapReduce作业,优化器对作业进行优化以提高效率,最后由执行器将作业运行的结果写入HDFS。

归纳而言,MapReduce提供了一种高效的并行计算模型,MySQL是广泛使用的数据库系统,HDFS为大数据存储提供了可靠基础,而Hive则将这些技术紧密集成,为用户提供了强大的数据仓库解决方案,通过这些技术的协同工作,可以有效地处理和分析大规模数据集,支撑起现代大数据应用的构建和发展。

相关问答FAQs

Q1: Hive与MySQL有何区别?

A1: Hive和MySQL虽然都可用于数据查询,但它们之间存在显著差异,Hive是基于Hadoop的数据仓库工具,主要用于处理存储在HDFS上的大规模数据集,使用的是类SQL查询语言HiveQL,并将查询转换为MapReduce任务执行,相比之下,MySQL是一个传统的关系型数据库管理系统,主要用于存储结构化数据,并使用标准的SQL进行数据操作,Hive的优势在于处理大规模数据,而MySQL更适合于需要快速响应时间的在线事务处理。

Q2: MapReduce和Hive的性能比较如何?

A2: MapReduce和Hive的性能比较取决于特定的应用场景,MapReduce提供了底层的并行计算框架,适合于自定义的数据处理任务,性能强大但编程复杂,而Hive通过将SQL查询转换为MapReduce任务,简化了编程过程,但在转换和执行过程中可能会引入额外的开销,对于复杂的数据分析任务,Hive能够提供更高层次的抽象,减少开发时间,但对于高度定制化且对性能要求极高的任务,直接使用MapReduce可能会更为合适。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/145931.html