如何理解MapReduce与Spark RDD在应用开发中的常用概念?

- 行业动态

- 2024-08-14

- 1

MapReduce是一种编程模型,用于大规模数据集(大于1TB)的并行运算。Spark是一个快速、通用、可扩展的大数据处理计算框架,RDD是Spark的核心抽象,代表一个不可变的、可分区、里面的元素可并行计算的集合。

在当今大数据时代,Spark作为一个高速、通用和支持多种语言的大数据处理框架,在实际应用中扮演着非常重要的角色,Spark的核心在于其能够处理大规模数据集,并且提供了一种高效的数据处理模型,本文将深入探讨Spark应用开发中的一些常用概念,特别是MapReduce模型和RDD(Resilient Distributed Datasets,弹性分布式数据集),以及它们如何共同作用于大数据处理。

MapReduce模型

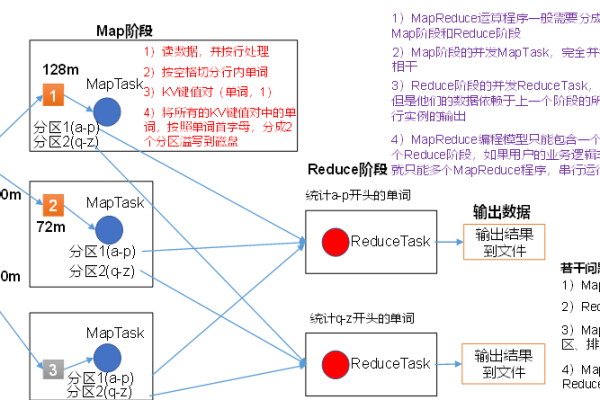

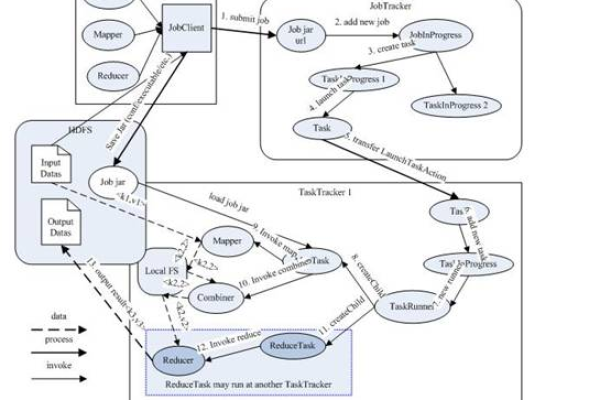

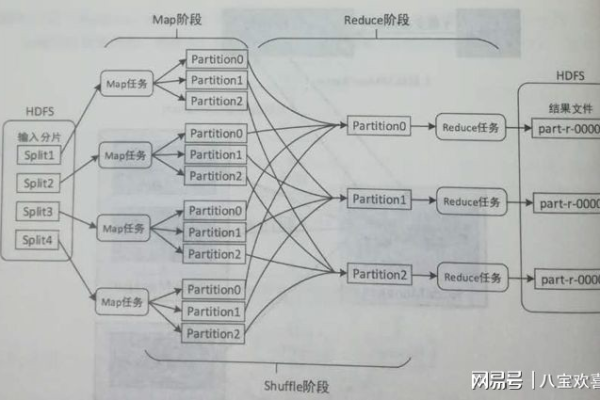

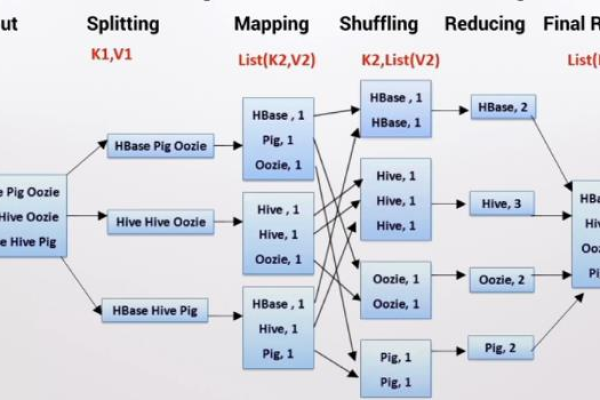

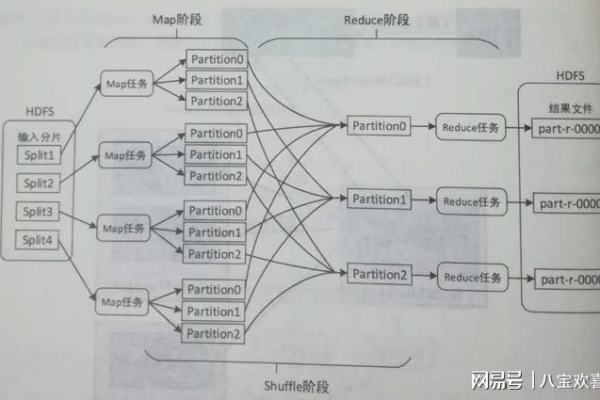

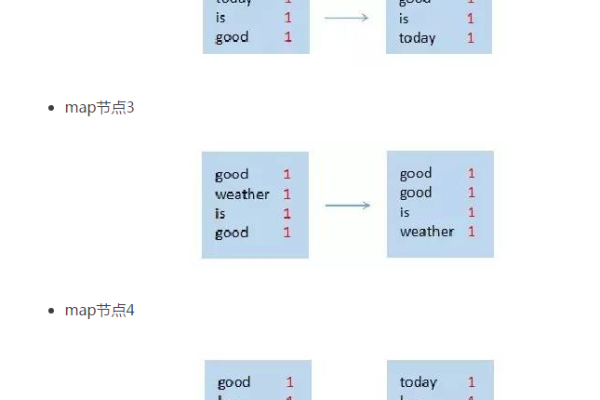

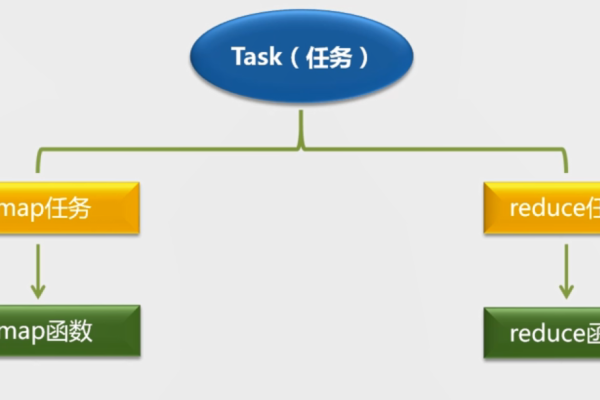

MapReduce是一种编程模型,用于处理和生成大数据集,这个模型包含两个主要部分:Map阶段和Reduce阶段,在Map阶段,系统将输入数据分成独立的数据块,这些数据块由Map任务以完全并行的方式处理,每个Map任务会处理一个数据块并生成一组中间键值对,通过Shuffle过程,所有具有相同键的值被聚合到一起,然后由Reduce任务对这些值进行处理,最终生成一组更小的结果集,这一模型因其简单性和高效性而被广泛应用于各种数据处理任务中。

RDD的基础与特性

RDD是Spark中的基本数据结构,它是一个不可变的、分布式的对象集合,每个RDD都被划分成多个分区,可以分布在集群的不同节点上进行并行处理,这种设计使得Spark能够非常高效地执行任务,如地图数据的叠加或网页页面的索引,RDD的一个重要特性是其“弹性”,即在面对节点故障时,RDD能够通过重新执行之前的计算步骤来重建丢失的数据分区,从而保证数据处理的正确性和可靠性。

Spark中的RDD操作

RDD支持两种类型的操作:转换(transformation)和动作(action),转换操作如map()、filter()、join()等,这些操作会生成一个新的RDD,但不会触发实际的计算,只有当动作操作如count()、first()、reduce()等被调用时,才会开始实际的计算过程,这种设计允许Spark优化计算过程,例如通过管道化转换操作减少任务执行的步骤。

容错机制与存储

Spark的RDD具有高度的容错性,除了上述的重新执行计算外,RDD还提供了持久化或缓存机制,允许用户将数据持久化到内存或磁盘上,这在需要频繁访问同一数据集的场景中非常有用,可以显著提高应用的性能。

执行模型

Spark采用DAG(有向无环图)执行模型来优化任务的执行,在这种模型中,Spark会分析RDD之间的依赖关系,并将多个转换操作串联起来形成阶段(stage),每个阶段的输出被缓存供下一阶段使用,这种优化减少了数据读写的次数和网络传输的开销,从而提高了整体的处理速度。

性能优化技巧

要充分利用Spark的性能,开发者需要注意几个方面,合理地设置RDD的分区数可以优化数据的分布和并行处理效率,避免不必要的数据洗牌(shuffle)可以显著提高性能,使用累加器(accumulators)和其他Spark内置的聚合工具可以在不引入全局通信的情况下进行统计和聚合操作。

相关FAQs

Q1: Spark中的RDD与MapReduce模型有何不同?

A1: RDD是Spark中的一种数据抽象,它允许系统以更灵活的方式进行数据处理和优化,而MapReduce是一种特定的数据处理模型,主要通过Map和Reduce两个步骤来处理数据,RDD提供更高级的转换和动作操作,支持更复杂的数据处理流程和优化策略。

Q2: 在什么情况下应该考虑使用RDD的持久化功能?

A2: 当需要在多个阶段或多个动作操作中重复使用同一个RDD时,应考虑使用RDD的持久化功能,这可以防止每次操作都需要从头开始计算,从而节约计算资源并加快处理速度,尤其是对于计算成本高的操作,如排序和分组,持久化可以显著提高性能。

Spark作为一款强大的大数据处理框架,通过其核心概念RDD和对MapReduce模型的支持,提供了高效且灵活的数据处理能力,了解并掌握这些基本概念和操作技巧,对于开发高性能的Spark应用至关重要。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/145830.html