Delphi7源码,探索经典编程工具的遗产与应用?

- 行业动态

- 2024-10-05

- 8

Delphi7是一个功能强大的集成开发环境(IDE),它由Borland公司推出,主要用于面向对象的可视化编程,以下是对delphi7源码的具体介绍:

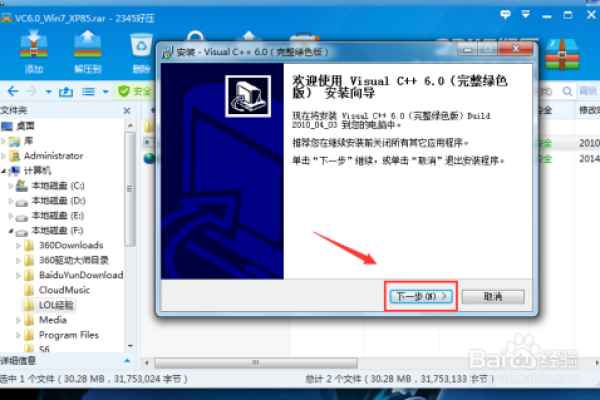

1、安装与配置:

要编译和运行Delphi7的源码,首先需要确保Delphi7的开发环境已经正确安装并配置,这包括设置正确的库路径和环境变量,在Delphi7中,可以通过“工具”>“选项”>“环境”来调整库路径。

对于特定的组件如Oracle Access控件(ODAC),还需要进行额外的配置,这包括将ODAC的bin目录中的文件复制到Delphi的Bin目录,并在Delphi中安装相应的包。

2、源码结构与功能:

Delphi7的源码通常包含多个文件,.dpr文件是项目文件,可以直接在Delphi7中打开并进行编译。

Delphi7利用了广泛的WinAPI函数,这些函数涵盖了从基本的内存管理到复杂的图形操作等多个方面,kernel32.dll、gdi32.dll等都是常用的动态链接库。

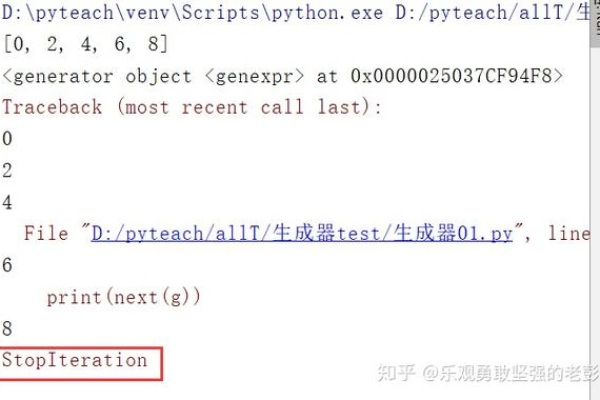

3、编译与调试:

在Delphi7中编译源码相对简单,只需打开项目文件后按F9键即可开始编译,如果遇到错误,可以根据错误提示进行相应的调整。

Delphi7提供了强大的调试工具,可以设置断点、单步执行代码以及查看变量状态等,这对于定位和修复代码中的问题非常有帮助。

4、示例与应用:

Delphi7附带了大量的示例程序,这些示例涵盖了从基本控件使用到复杂数据处理等多个方面,通过研究这些示例,可以快速掌握Delphi7的编程技巧。

Delphi7广泛应用于各种商业软件和系统软件的开发中,如数据库管理系统、企业资源规划(ERP)系统等,其强大的数据处理能力和灵活的用户界面设计使得它在软件开发领域具有很高的竞争力。

Delphi7的源码包含了丰富的内容和功能,通过深入了解和学习这些源码,可以更好地掌握Delphi7的编程技巧并开发出高质量的软件产品。

各位小伙伴们,我刚刚为大家分享了有关“delphi7 源码”的知识,希望对你们有所帮助。如果您还有其他相关问题需要解决,欢迎随时提出哦!