如何理解MapReduce模块的结构组成与组合方式?

- 行业动态

- 2024-08-13

- 3

MapReduce是一种广泛用于大规模数据处理的编程模型,可在大量计算机节点上并行处理大数据集,这个模型十分适用于结构化及非结构化数据的处理,并且能有效处理任务失败和节点失效的问题,下面详细探讨MapReduce模块的结构及其组件功能:

1、客户端(Client)

作业提交:客户端是用户与MapReduce系统交互的界面,负责提交作业至JobTracker,它通知用户作业的进度和状态,包括作业提交、执行和完成情况。

作业配置:通过客户端,用户可以配置作业的各种参数,例如输入输出格式、Mapper和Reducer类的设置等,这些配置对作业的执行效率和结果具有重要影响。

2、作业跟踪器(JobTracker)

作业调度:JobTracker是MapReduce框架中的主节点,负责协调作业的执行,它管理所有作业的资源分配,并调度任务到各个TaskTracker上执行。

任务监控:JobTracker监控各个TaskTracker的健康状况和任务进度,一旦发现任务失败或节点故障,它会在其他节点上重新调度失败的任务以确保作业能够顺利完成。

错误恢复:在分布式系统中,节点故障是常态,JobTracker通过错误恢复机制保证作业在面对硬件故障时仍能正确、完整地执行。

3、任务跟踪器(TaskTracker)

任务执行:TaskTracker管理所在节点的资源,执行由JobTracker指派的任务,每个TaskTracker同时负责汇报本节点上任务的执行状态给JobTracker。

数据本地化优化:为了减少网络传输带来的延迟,TaskTracker尽可能在数据存储的同一节点上执行任务,这被称为“数据本地化优化”。

任务反馈:TaskTracker定期向JobTracker发送心跳信息,包括任务执行状态、资源使用情况等,帮助JobTracker进行任务调度和错误恢复决策。

4、任务(Task)

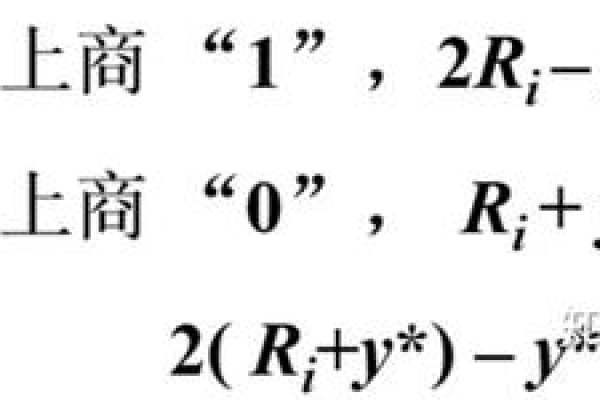

Map任务:Map任务读取原始数据,解析成键值对,经过处理后生成中间键值对,这些中间键值对会被Shuffle和Sort环节处理,为Reduce阶段做准备。

Reduce任务:Reduce任务从Map任务接收数据,将具有相同键的值归约起来,通常用于汇总或计算最终结果。

Shuffle和Sort阶段:这两个阶段是MapReduce的核心部分,它们负责将Map任务的输出按键分组和排序,确保Reduce任务能正确地接收到所有相关数据。

MapReduce作为一个高效的数据处理模型,其优势在于能够处理海量数据并实现容错处理,但其挑战在于作业调度和资源管理的复杂性,随着技术的发展,一些现代框架如Apache Spark开始提供更高效的解决方案,但了解和掌握MapReduce的基本结构对于从事大数据处理的专业人员仍然是必不可少的,相关技术和应用的最新动态也值得关注,以便在实际场景中更好地应用这一模型。

FAQs

Q1: MapReduce如何处理数据倾斜问题?

A1: 数据倾斜是指MapReduce作业中某几个键的数据量远大于其他键,导致处理时间延长,解决这一问题的方法包括在Map阶段的输出中加入随机前缀以分散Reduce任务的输入负载,或者使用范围分区等高级分区技术来确保数据均匀分布到各个Reduce任务上。

Q2: MapReduce与Apache Spark的主要区别是什么?

A2: Apache Spark提供了比Hadoop MapReduce更高级的数据处理功能,包括支持在内存中数据处理和迭代算法的优化,这使得Spark在处理需要频繁读写数据的作业时更加高效,而MapReduce更适合批量处理大规模数据,每次作业处理大量从磁盘读取的数据。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/145335.html