计算机实验室服务器究竟扮演着哪些关键角色?

- 行业动态

- 2024-10-12

- 4

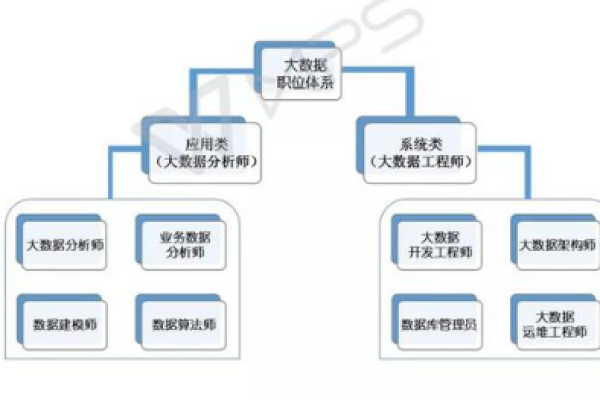

计算机实验室服务器主要用于提供高性能计算资源、存储空间和网络服务,支持科研实验、数据处理和软件开发等任务。

计算机实验室服务器的作用

在现代教育和技术研究环境中,计算机实验室服务器扮演着至关重要的角色,它们不仅为实验室内的计算需求提供了强大的支持,还确保了数据的安全、资源的高效分配和实验的顺利进行,以下是计算机实验室服务器的主要作用,通过小标题和单元表格进行详细阐述:

提供高性能计算资源

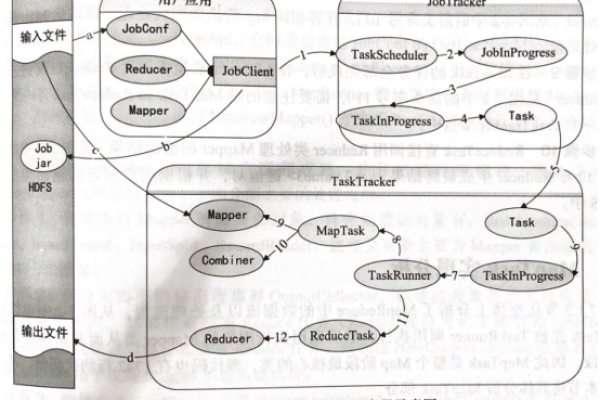

计算机实验室服务器通常配备有高性能的处理器、大容量内存和快速存储设备,能够处理复杂的计算任务和大数据量,这使得学生和研究人员能够在实验室内进行高级编程、数据分析、机器学习等需要大量计算资源的任务。

| 组件 | 说明 |

| 处理器 | 高性能多核CPU,支持并行计算 |

| 内存 | 大容量RAM,快速响应计算需求 |

| 存储 | SSD或高速硬盘,提供快速读写速度 |

实现资源共享

服务器在实验室中充当资源共享的中心节点,通过服务器,学生和研究人员可以共享软件、数据集和其他计算资源,避免了重复安装和配置的麻烦,提高了资源利用率。

| 资源类型 | 说明 |

| 软件 | 共享专业软件,如MATLAB、AutoCAD等 |

| 数据集 | 提供公共数据集,便于研究和学习 |

| 文档和资料 | 共享教学材料和研究文献 |

保障数据安全与备份

实验室服务器通常具备完善的数据安全机制,包括防火墙、载入检测系统和定期的数据备份,这些措施保护了实验室内的敏感数据免受外部威胁和意外损失。

| 安全措施 | 说明 |

| 防火墙 | 阻止未经授权的访问 |

| 载入检测系统 | 监控异常活动,及时响应潜在威胁 |

| 数据备份 | 定期备份重要数据,防止数据丢失 |

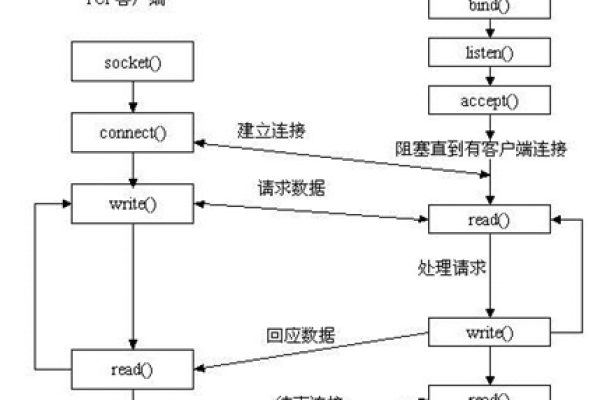

支持远程访问与协作

服务器使得实验室成员可以远程访问实验室资源,进行项目合作和数据交换,这对于分布在不同地点的团队成员来说尤为重要,它打破了地理限制,促进了团队协作。

| 功能 | 说明 |

| 远程桌面 | 允许用户从任何地点远程登录实验室服务器 |

| 文件共享 | 通过网络共享文件,便于团队成员间的数据交换 |

| 在线协作 | 支持多人同时在线编辑文档和代码,提高协作效率 |

促进教学与实验的融合

服务器为实验室提供了丰富的教学资源和实验环境,使得理论教学与实践操作紧密结合,学生可以在服务器上进行编程练习、模拟实验等,加深对知识的理解和应用。

| 应用场景 | 说明 |

| 编程练习 | 提供编程环境,让学生实践编程技能 |

| 模拟实验 | 使用软件模拟真实世界场景,进行实验操作 |

| 在线测试 | 进行在线测验和考试,及时反馈学生的学习情况 |

支持科研项目与创新

服务器为科研项目提供了必要的计算资源和数据支持,研究人员可以利用服务器进行大规模数据处理、复杂模型运算等,推动科研创新和技术进步。

| 科研支持 | 说明 |

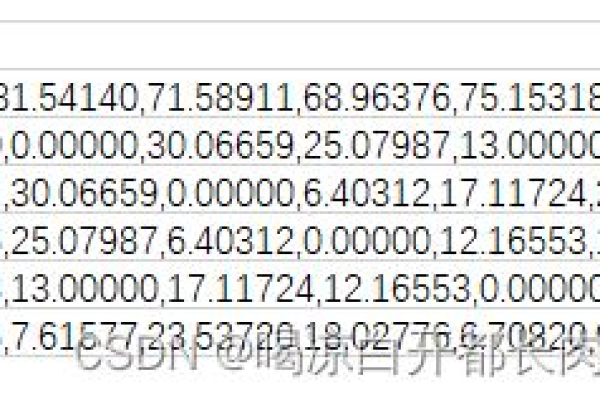

| 数据处理 | 分析大量数据,提取有价值的信息 |

| 模型运算 | 运行复杂的数学模型和算法,进行科学研究预测 |

| 成果展示 | 将研究成果以图表、演示等形式展示出来 |

计算机实验室服务器在提供高性能计算资源、实现资源共享、保障数据安全与备份、支持远程访问与协作、促进教学与实验的融合以及支持科研项目与创新等方面发挥着不可替代的作用,它是现代计算机实验室不可或缺的核心设备之一。

| 服务器功能 | 作用描述 |

| 文件存储与共享 | 提供大容量存储空间,方便用户存储和共享文件和数据。 |

| 数据库管理 | 运行数据库管理系统,存储、管理和查询大量数据。 |

| 软件分发 | 通过服务器安装和分发软件,方便用户统一管理和更新软件。 |

| 网络服务 | 提供网络服务,如Web服务、电子邮件服务、FTP服务等。 |

| 虚拟化 | 通过虚拟化技术,在一台物理服务器上运行多个虚拟机,提高资源利用率。 |

| 远程访问 | 允许用户通过远程桌面、SSH等方式访问服务器,实现远程管理和操作。 |

| 安全防护 | 部署防火墙、载入检测系统等安全措施,保护服务器和数据安全。 |

| 任务调度 | 自动执行定时任务,如备份、系统维护等,提高工作效率。 |

| 应用部署 | 部署和管理各种应用,如Web应用、数据库应用等。 |

| 流媒体传输 | 提供视频、音频等流媒体内容的传输服务。 |

| 打印服务 | 提供集中打印管理,方便用户共享打印机资源。 |

| 云计算服务 | 提供云计算资源,如虚拟机、存储等,满足用户不同的计算需求。 |