VOD系统如何实现KTV场所的实时监控?

- 行业动态

- 2024-07-27

- 3

在探讨KTV服务器VOD主机是否支持实时监控功能的问题时,可以明确地说,VOD(Video on Demand)系统确实支持实时监控功能,这种功能主要通过云监控服务(Cloud Eye Service, CES)来实现,它可以为用户提供丰富的数据监控和告警服务,小编将}

{概述}={深入分析这一功能的多个方面,详细讨论它的实际应用及影响:

1、实时数据监控

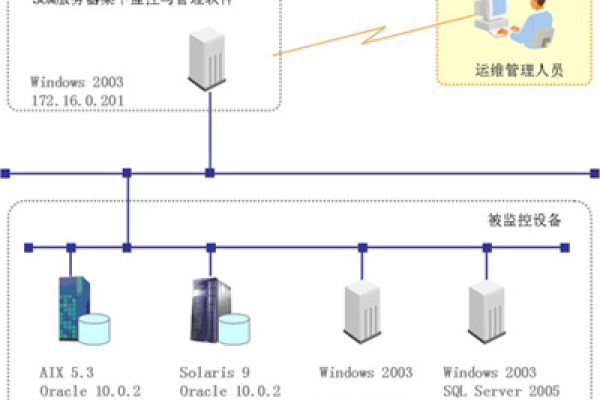

基础数据监控:通过云监控服务,VOD系统可以实时监控诸如流量、带宽及状态码等基础数据,这使得管理员能够及时了解系统的运行状态和性能指标。

实时流量监控:实时监控网络流量有助于确保系统不会因流量过大而出现过载,从而保障服务质量和用户体验。

2、系统告警配置

设置告警阈值:管理员可以预设某些关键性能指标的阈值,一旦实际数据超出这些阈值,系统即会自动发出告警,帮助及时发现并处理可能的问题。

自动化告警响应:这种自动化的告警机制能够加快问题解决速度,减少人工干预的需要,提高整体效率。

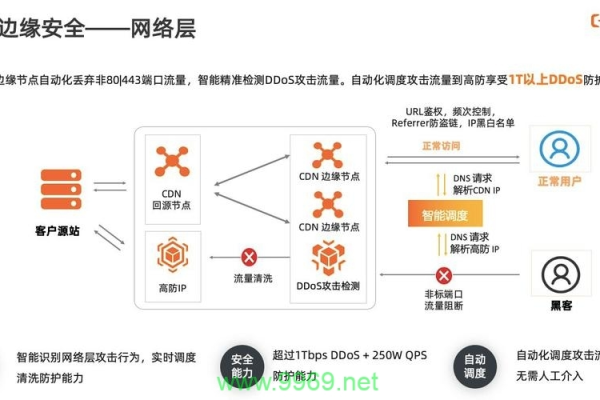

3、用户授权验证

控制访问权限:VOD服务器会验证用户的授权点数,确保只有经过授权的用户才能访问内容,这有助于保护版权和防止未授权访问。

安全:通过实时监控用户访问情况,可以及时发现异常访问模式,如多次失败的访问尝试,从而采取措施防范潜在的安全威胁。

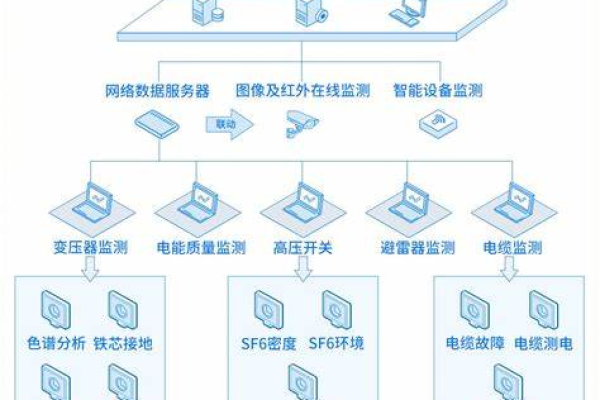

4、视频流传输管理

优化视频传输:通过监控视频流的传输状态,例如检查传输协议和歌曲码率,确保视频流畅播放无阻。

保证视频质量:实时监控可以帮助调整视频质量,根据网络状况动态调整视频码率,避免因网络问题影响用户体验。

5、故障快速定位

迅速诊断问题:当系统出现故障时,实时监控提供的数据可以帮助快速定位问题源头,缩短修复时间。

减少维护成本:快速的问题诊断和解决减少了系统的维护成本和运营中断的时间。

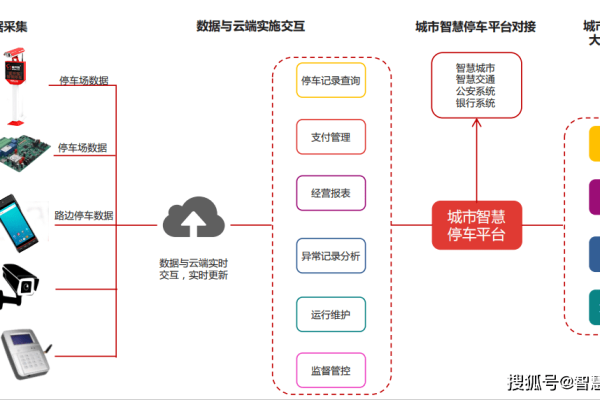

6、用户体验提升

即时响应用户反馈:实时监控允许运营商快速响应用户关于服务质量的反馈,及时改善服务,提升用户满意度。

个性化服务推荐:通过分析用户的观看习惯和偏好,实时监控系统可以协助提供更加个性化的内容推荐,增强用户体验。

7、技术支持与更新

持续的技术更新:由于技术的快速发展,实时监控功能也会不断更新和升级以适应新的技术需求。

技术支持服务:对于实时监控功能的实施和维护,技术支持团队提供必要的指导和帮助,确保功能的正确运用和执行效果。

KTV服务器VOD主机的实时监控功能不仅提高了系统的可靠性和安全性,还增强了用户体验和服务质量,通过实时收集和分析数据,管理员能够更有效地管理内容传递,优化系统性能,并在必要时进行快速响应和故障排除,随着技术的进一步发展,预计会有更多创新的功能加入,使得VOD系统更为智能和高效。