如何有效利用DDoS基础防护中的白名单机制?

- 行业动态

- 2025-01-15

- 1

DDoS基础防护中的白名单机制是一种有效的安全策略,通过允许特定IP地址和端口的流量进入服务器,同时拒绝其他所有未授权的访问,这种机制不仅提高了服务器的安全性,还能防止常见的网络攻击如洪水攻击和SYN Flood攻击。

什么是DDoS基础防护白名单?

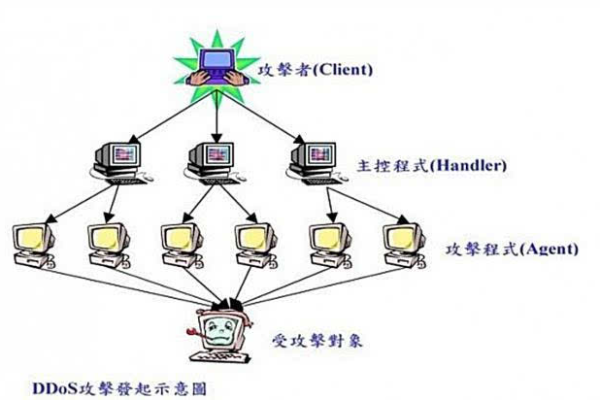

DDoS(分布式拒绝服务)攻击是一种常见的网络攻击方式,通过大量无效请求占用服务器资源,导致合法用户无法正常访问服务,DDoS基础防护白名单功能允许管理员指定某些IP地址和端口为可信来源,这些来源的流量将被优先处理,而其他未授权的访问则会被阻止或限制。

DDoS基础防护白名单的作用与优势

提高网络安全性

白名单机制通过仅允许指定的IP地址和端口访问服务器,有效防止了未经授权的流量进入系统,这种方式显著降低了遭受DDoS攻击的风险,因为只有列入白名单的请求才会被处理。

增强服务器稳定性

在启用白名单后,服务器可以更好地管理和分配资源,避免因处理大量反面请求而导致的性能下降,这样可以确保服务器在高流量情况下仍能保持稳定运行。

灵活管理

DDoS基础防护支持用户自定义端口白名单,根据实际需求灵活调整,在线游戏服务商、电子商务网站和大型企业通常需要处理大量流量和请求,使用白名单可以帮助他们更有效地防御针对服务器的攻击。

应用场景

在线游戏服务商

对于在线游戏服务商来说,启用DDoS基础防护端口白名单可以保护游戏服务器免受洪水攻击和SYN Flood攻击,确保玩家能够稳定地进行游戏。

电子商务网站

电子商务网站需要处理大量的交易和流量,使用白名单机制可以有效防御针对服务器的攻击,保障网站的正常运行和用户体验。

政府和企业网站

政府和企业机构的网站通常需要高稳定性和安全性,使用白名单可以帮助他们更好地保护服务器,避免因非规流量造成的服务中断。

常见问题解答

问:怎样启动DDoS基础防护服务?

每台云服务器都是默认启动DDoS基础防护服务,单台云服务器流量超过一定流量时将自动启动DDoS清洗设备进行流量清洗。

问:DDoS基础防护可以防syn攻击吗?

是的,DDoS基础防护服务可以防御syn洪水攻击。

问:查看DDoS防护情况的周期可以选择吗?

云盾DDoS基础防护控制台支持24小时内的DDoS攻击事件查询,需要更长周期请查看态势感知。

问:我的ECS服务器被20Mb的流量攻击了,云盾DDoS基础防护怎么不防护?

DDoS基础防护是公共的DDoS防护服务,不对很小的流量攻击(小于100Mb)进行防护,建议您优化服务器性能,或者安装云锁等主机防火墙应对小于100Mb的流量攻击。

小编有话说

DDoS基础防护中的白名单机制是一种非常实用的安全措施,能够帮助企业和机构有效防御各种网络攻击,通过合理配置和管理白名单,可以大大提高服务器的安全性和稳定性,希望本文的介绍能够帮助您更好地理解和应用这一机制,保护您的网络环境免受攻击。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/142067.html