如何有效控制自身断电以获取习题知识点?

- 行业动态

- 2024-07-25

- 7

要控制自身的断电行为并获取相关的习题知识点,首先需要了解断电的原因和如何预防不必要的断电,以下是一些可能的原因和对策:

断电原因分析

1. 电源问题

不稳定的电网供电:电网波动可能导致断电。

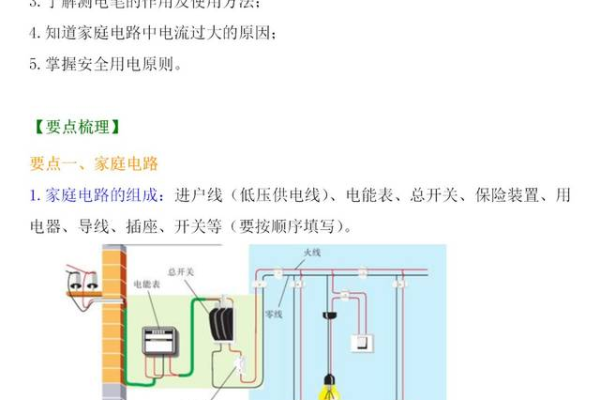

家庭电路老化:长时间使用后,电线可能会老化,导致断电。

2. 设备故障

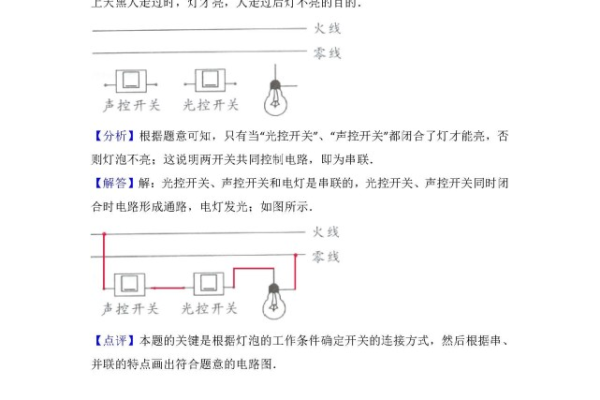

电器短路:电器内部短路是常见的断电原因。

过载保护:当电流超过安全值时,断路器会自动断开电路以防火灾。

3. 自然灾害

雷击:雷电可以直接击中电力设施,造成断电。

风暴和洪水:强风和洪水可以破坏电力基础设施。

预防措施

1. 提高电源质量

使用稳压器:安装稳压器可以避免电压波动导致的断电。

定期检查电路:请专业电工定期检查和维护家庭电路。

2. 设备维护

定期维护电器:定期检查和维护家中的电器,确保其良好运行。

合理分配负载:避免同时使用多个高功率设备,以免触发过载保护。

3. 应对自然灾害

安装防雷设施:在房屋中安装避雷针和浪涌保护器。

加固电力设施:在易受风暴影响的地区,应加固电力设施。

习题知识点获取

为了获取与断电相关的习题知识点,可以通过以下方式:

1. 在线教育平台

课程学习:注册在线教育平台,如Coursera、edX等,搜索与电力系统、电路理论等相关的课程。

练习题库:利用这些平台上提供的题库进行练习。

2. 专业书籍和教材

图书馆资源:访问图书馆,查找有关电力系统、电路分析和家庭用电安全的书籍。

在线书店:在亚马逊、当当等在线书店购买相关书籍。

3. 学术期刊和论文

数据库检索:使用Google Scholar、IEEE Xplore等数据库检索最新的研究论文。

订阅期刊:订阅电力行业的专业期刊,如《电力系统自动化》等。

4. 行业报告和新闻

行业网站:访问电力行业的官方网站,如国家电网公司网站,获取最新动态。

新闻聚合应用:使用Feedly、Flipboard等应用关注电力行业的新闻。

5. 社区和论坛

技术论坛:参与Electrical Engineering Stack Exchange等专业论坛,与其他专业人士交流。

社交媒体群组:加入LinkedIn、微信等社交媒体上的电力行业群组。

通过上述方法,可以有效地获取与断电相关的习题知识点,并采取措施预防断电,保障电力供应的稳定性。