ai的深度学习

- 行业动态

- 2025-03-16

- 8

一、深度学习基础

(一)定义与原理

深度学习是人工智能的一个分支,它试图模仿人脑的神经元网络结构和信息处理方式,通过构建多层神经网络,自动从大量数据中学习特征和模式,在图像识别中,输入图像经过多层神经元的处理,每层神经元会对图像的不同特征进行提取和抽象,从边缘、纹理等低层次特征逐渐到更复杂的物体形状、类别等高层次特征。

(二)关键技术

| 技术名称 | 功能描述 | 应用场景举例 |

| 卷积神经网络(CNN) | 主要用于处理具有类似网格结构的数据,如图像(二维网格),通过卷积层自动提取局部特征,池化层降低数据维度。 | 图像分类、目标检测、人脸识别等,例如在人脸识别系统中,CNN可以提取人脸的关键特征,用于身份验证。 |

| 循环神经网络(RNN)及其变体(如LSTM、GRU) | 适用于处理序列数据,RNN可以在序列的演进方向上传递信息,LSTM和GRU解决了RNN的长序列依赖问题。 | 机器翻译、语音识别、文本生成等,比如在机器翻译中,RNN可以按照句子的顺序处理单词序列,生成对应的译文。 |

二、深度学习模型训练

(一)数据准备

数据集收集:需要收集大量高质量的数据,以训练一个猫狗分类器为例,要从各种来源收集包含猫和狗的图像,并且图像的数量要足够多,以保证模型能够学习到足够的特征。

数据预处理:包括数据清洗(去除噪声、错误标记等)、归一化(将数据尺度统一,如将图像像素值归一化到0 1之间)、数据增强(通过旋转、翻转、裁剪等操作增加数据的多样性)。

(二)损失函数与优化器

损失函数:用于衡量模型预测结果与真实标签之间的差异,常见的有均方误差(MSE)用于回归问题,交叉熵损失用于分类问题,在二分类问题中,如果模型预测的概率为p,真实标签为y(y = 0或1),交叉熵损失公式为:$L = ylog(p)-(1 y)log(1 p)$。

优化器:其作用是更新模型的参数,使损失函数最小化,常见的优化器有随机梯度下降(SGD)、Adagrad、Adadelta、Adam等,Adam优化器结合了动量和自适应学习率的优点,在很多深度学习任务中表现出色。

三、深度学习应用案例

(一)计算机视觉领域

图像分类:如ImageNet大规模视觉识别挑战(ILSVRC)中的冠军模型,可以对数百万张图像进行数千个类别的分类,这些模型通过深度学习技术,能够准确地识别图像中的物体类别,如区分不同种类的花卉、动物等。

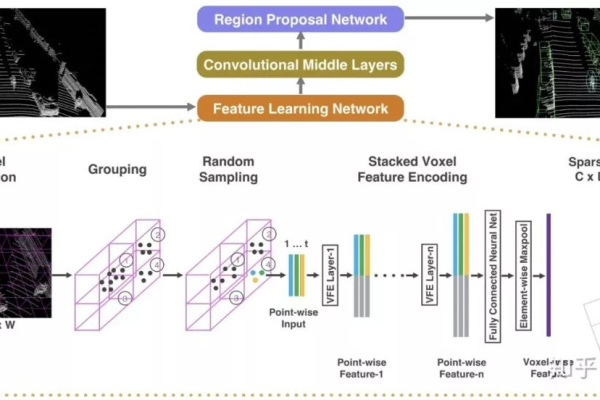

目标检测:YOLO(You Only Look Once)系列算法可以在图像中实时检测出多个目标物体的位置和类别,例如在自动驾驶场景中,YOLO可以检测道路上的车辆、行人、交通标志等目标,为车辆的决策系统提供重要信息。

(二)自然语言处理领域

情感分析:通过对文本的情感倾向(积极、消极、中性)进行分类,例如在社交媒体舆情监测中,可以分析用户评论的情感倾向,帮助企业了解用户对产品或服务的态度。

机器翻译:深度学习模型可以将一种语言自动翻译成另一种语言,像谷歌翻译采用了基于深度学习的神经机器翻译(NMT)技术,能够提供较准确的翻译结果,大大提高了翻译的效率和质量。

相关问题与解答

(一)问题

深度学习模型一定会出现过拟合吗?如何判断模型是否过拟合?

(二)解答

深度学习模型不一定会出现过拟合,但过拟合是比较常见的问题,判断模型是否过拟合可以通过以下方法:

训练集和验证集准确率对比:如果在训练集上准确率很高,但在验证集上准确率明显下降,很可能出现了过拟合,一个图像分类模型在训练集上的准确率达到98%,但在验证集上只有70%,这就表明模型可能过度学习了训练集的特征,而没有很好地泛化到新数据上。

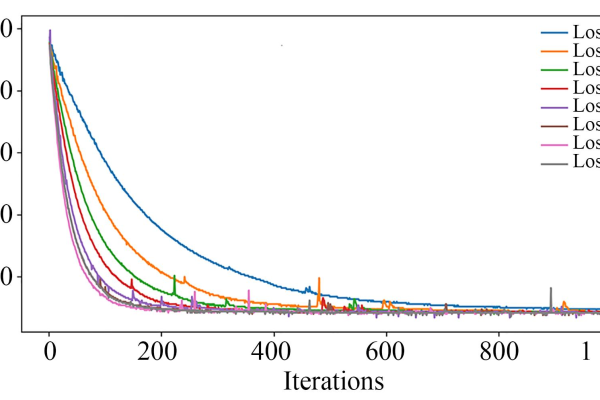

损失曲线观察:观察训练过程中的训练损失和验证损失曲线,如果训练损失持续下降,而验证损失在某一时刻后开始上升,这也是过拟合的迹象,这表示模型在训练集上不断优化损失,但对验证集数据的适应能力变差。

(一)问题

深度学习中的超参数有哪些?如何调整超参数?

(二)解答

深度学习中的超参数主要包括:

学习率:控制模型参数更新的步长,较大的学习率可能导致模型更快地收敛,但也可能会跳过最优解;较小的学习率会使模型收敛更稳定,但可能需要更多的训练时间,一般可以通过学习率调度策略(如学习率衰减)来调整,在训练初期使用较大的学习率让模型快速接近最优解所在的区域,然后逐渐减小学习率进行精细调整。

批次大小(Batch Size):决定了每次更新模型参数时使用的样本数量,较大的批次大小可以使梯度估计更准确,但会占用更多的内存;较小的批次大小可以使模型更新更频繁,但可能会导致梯度噪声较大,通常需要根据硬件资源和数据集大小来选择合适的批次大小。

网络层数和神经元数量:不同的任务需要不同深度和宽度的网络,更复杂的任务可能需要更深更宽的网络,但也会增加计算成本和过拟合的风险,可以通过实验和经验来确定合适的网络结构,对于简单的图像分类任务,可能只需要几个卷积层和全连接层,而对于复杂的对象检测任务,可能需要更深的卷积神经网络和使用更多的神经元。