负载均衡连接延时接受是如何实现的?

- 行业动态

- 2024-11-07

- 4275

负载均衡连接延时接受

背景介绍

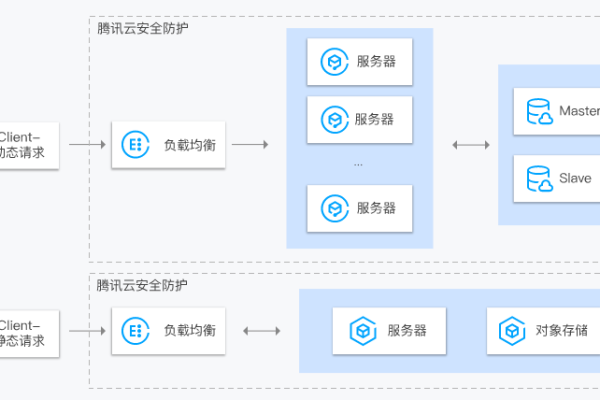

在现代网络架构中,负载均衡是一种关键的技术,用于将流量分配到多个服务器上,以确保应用的高可用性和性能优化,负载均衡策略的选择和实现直接影响到系统的响应时间和用户体验,特别是在分布式系统中,不同节点之间的延迟差异可能导致显著的性能问题,本文将深入探讨负载均衡中的连接延时接受问题,分析其原因、影响及优化方法。

一、负载均衡的基本概念

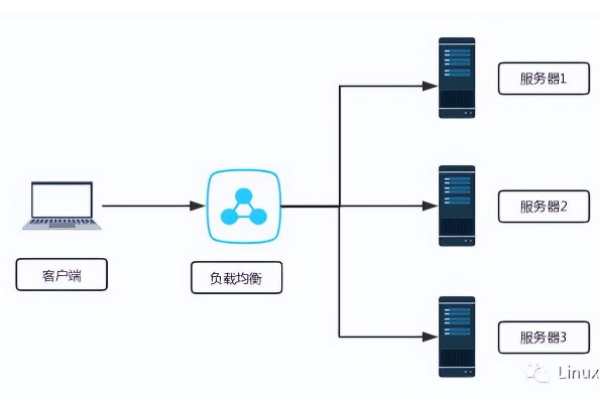

定义与作用

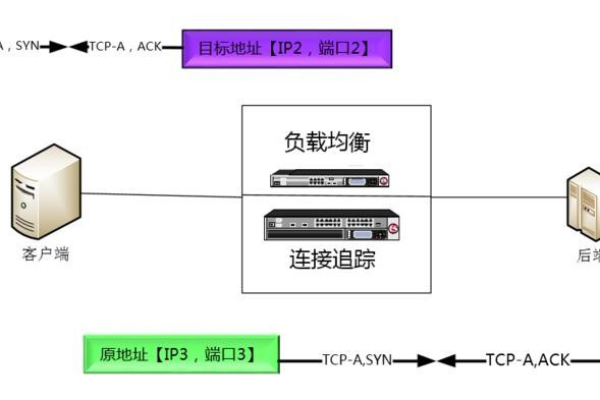

负载均衡通过将传入的请求分配到多个服务器上,以平衡每个服务器的处理负载,它的主要目标是优化资源使用,最大化吞吐量,最小化响应时间,并避免系统过载。

常见类型

静态负载均衡:预先设定请求的分配方式,例如轮询法。

动态负载均衡:根据实时监控的服务器状态(如CPU使用率、响应时间等)进行动态调整。

自适应负载均衡:结合静态和动态的优点,能够自动适应不断变化的工作负载。

二、连接延时的原因

网络延迟

网络延迟是指数据从客户端传输到服务器所需的时间,这种延迟可能由多种因素引起,包括物理距离、路由器跳数、带宽限制等。

服务器处理能力

服务器的处理能力直接影响请求的响应时间,如果服务器硬件配置不足或者存在软件瓶颈,都会导致处理速度下降。

并发连接数

当服务器同时处理大量请求时,会出现排队等待的情况,从而导致延时增加,这种现象在高并发场景下尤为明显。

负载均衡算法

不同的负载均衡算法对延时的影响也不同,轮询法简单但不考虑服务器的实际负载情况;而最少连接法则会根据当前的活跃连接数来分配请求。

三、负载均衡算法的影响

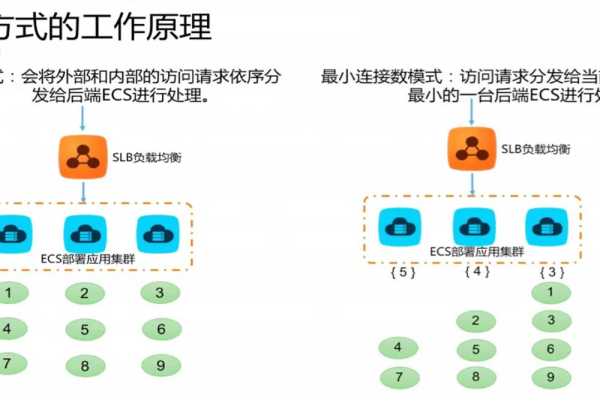

轮询法

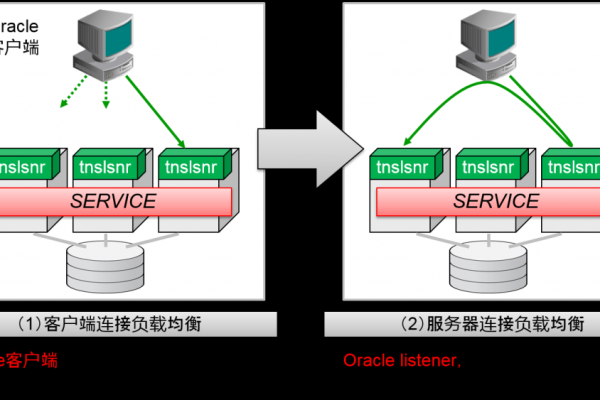

轮询法是最简单的一种负载均衡算法,它按照固定的顺序将请求依次分配给每台服务器,这种方法实现简单,但在面对不同性能的服务器时,无法有效利用资源。

最少连接法

最少连接法会将新的请求分配给当前活动连接数最少的服务器,这种方法在一定程度上考虑了服务器的负载情况,但对于瞬时高并发的场景仍然可能存在瓶颈。

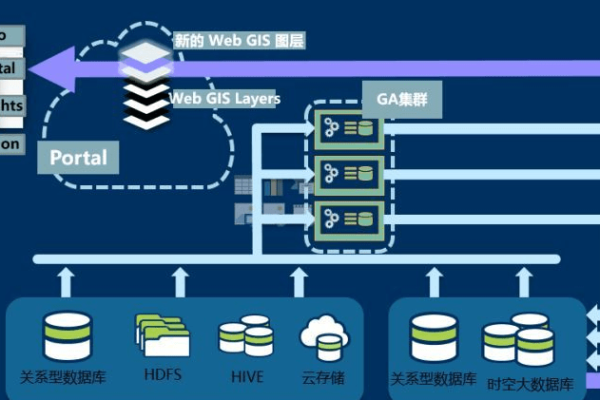

基于延迟的负载均衡

基于延迟的负载均衡算法通过测量各个服务器的响应时间,优先选择延迟最低的服务器,这种方法可以显著提高用户体验,特别是在分布式系统中效果更佳。

四、优化策略

动态调整

采用自适应负载均衡技术,根据实时监控的数据动态调整请求分配策略,以应对不断变化的工作负载。

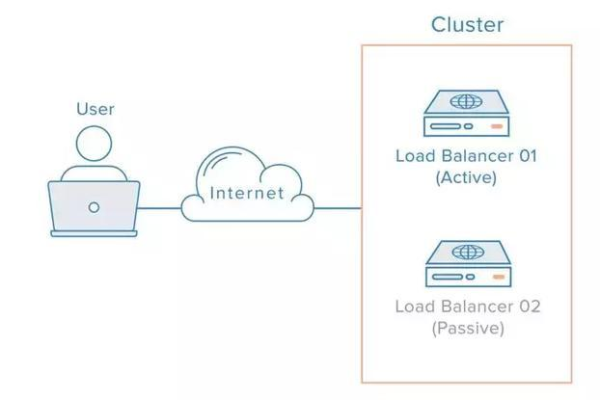

健康检查

定期对服务器进行健康检查,及时发现并剔除故障节点,确保只有健康的服务器参与请求处理。

流量控制

实施流量控制策略,避免单个服务器因过载而导致的整体性能下降,可以通过限流、熔断等机制来实现。

缓存机制

引入缓存机制,减少频繁的数据库查询或计算密集型操作,从而降低延迟,可以使用CDN、Redis等技术来提升性能。

五、未来展望

随着云计算和大数据技术的发展,负载均衡技术也在不断演进,未来的负载均衡解决方案将更加智能化,能够自动感知系统状态,预测工作负载变化,并做出相应的调整,结合人工智能和机器学习技术,可以实现更精细化的流量管理和更高效的资源利用。

六、上文归纳

负载均衡连接延时接受是一个复杂的问题,需要综合考虑网络环境、服务器性能、并发连接数以及负载均衡算法等多个因素,通过合理的架构设计和优化策略,可以有效降低延时,提升系统的整体性能和用户体验,希望本文能为您提供一些有价值的见解和思路,帮助您更好地理解和应对负载均衡中的延时问题。

以上就是关于“负载均衡连接延时接受”的问题,朋友们可以点击主页了解更多内容,希望可以够帮助大家!

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/1350.html