服务器公网的ip在哪里

- 行业动态

- 2025-03-15

- 7

服务器公网IP的查看方式有多种,常见的可通过在 服务器命令行输入

ip addr show(Linux系统)或 ipconfig(Windows系统)等命令来查找,也可在路由器管理界面、云服务提供商控制台等相关网络配置管理处查看相应服务器的 公网IP地址。

服务器公网 IP 的查找方法

一、通过命令行工具查找(以 Windows 和 Linux 为例)

| 操作系统 | 命令 | 示例结果 |

| Windows | 在命令提示符(CMD)中输入ipconfig 命令,查看网络适配器信息,IPv4 地址”对应的就是服务器的内网 IP 地址,要获取公网 IP 地址,可使用curl ifconfig.me 或访问一些提供公网 IP 查询的网站,如 https://www.ip138.com/ ,在浏览器中打开该网址后显示的 IP 地址即为公网 IP 地址。 | 执行ipconfig 后可能看到类似以下内容:“ 而通过curl ifconfig.me 命令可能得到类似123.123.123.123` 这样的公网 IP 地址。 |

| Linux | 在终端中使用ifconfig 或ip addr show 命令查看网络接口信息,找到类似inet 开头且后面跟着 IP 地址的行,其中非回环地址(通常不是127.0.0.1)且不是内网特定网段(如常见的10.x.x.x、172.16.x.x 172.31.x.x、192.168.x.x)的 IP 地址可能就是公网 IP 地址,也可以使用curl ifconfig.me 或访问公网 IP 查询网站来获取公网 IP 地址。 | 执行ifconfig 后可能看到如下内容:“ 这里192.168.1.101` 是内网 IP,若想获取公网 IP 还需进一步通过上述其他方式查询。 |

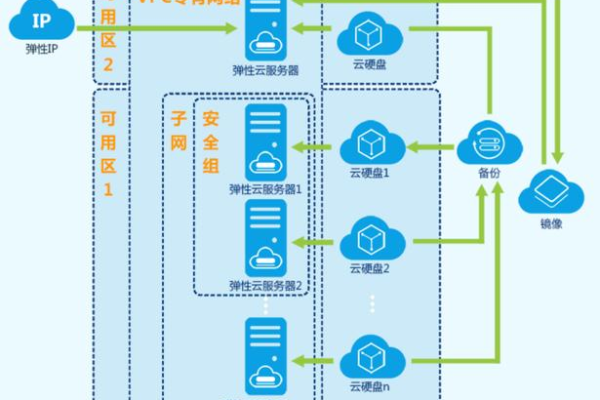

二、通过云服务提供商控制台查找(针对云服务器)

| 云服务提供商 | 操作步骤 |

| 阿里云 | 登录阿里云控制台,在顶部菜单栏选择“产品与服务” “计算” “实例”,进入实例列表页面,点击需要查看 IP 的实例名称或 ID,在实例详情页面的“基本信息”或“网络信息”板块中可以找到公网 IP 地址,如果实例绑定了弹性公网 IP(EIP),在 EIP 相关设置区域也能查看到对应的公网 IP 地址。 |

| 酷盾安全 | 登录酷盾安全控制台,点击左侧导航栏中的“云服务器”进入实例管理页面,找到目标实例并点击其 ID,在弹出的实例详情窗口中,于“网络信息”部分可查看公网 IP 地址,若有弹性公网 IP,同样在其对应配置区域能获取到相关信息。 |

三、通过域名解析服务商查找(如果服务器有域名)

| 域名解析服务商 | 操作步骤 |

| DNSPod | 登录 DNSPod 账号,进入域名解析管理界面,找到与服务器关联的域名,点击该域名进入解析记录设置页面,查看 A 记录(主机记录为 @ 或 www 等指向服务器的记录),其中的 IP 地址一般就是服务器的公网 IP 地址。 |

| Cloudflare | 登录 Cloudflare 账户,在域名管理列表中找到对应的域名并点击进入,在 DNS 解析设置区域,查找 A 记录部分,其指向的 IP 地址即为服务器公网 IP 地址。 |

相关问题与解答

问题一:为什么有时候通过不同方式查到的公网 IP 地址不一样?

解答:这种情况可能是由于服务器所在的网络环境存在多层网络架构或者使用了代理、负载均衡等原因导致的,在一些企业级网络中,内部服务器可能先经过企业内部的网络设备进行转发,这些设备可能会对流量进行处理并分配不同的出口 IP 地址,所以从不同的角度(如在服务器本地查询和从外部网络查询)看到的公网 IP 地址就可能不一致,如果使用了代理服务器,查询请求经过代理时会显示代理服务器的 IP 地址而不是服务器本身的公网 IP 地址。

问题二:服务器的公网 IP 地址会发生变化吗?

解答:在某些情况下会发生变化,如果是动态公网 IP 地址(常见于家庭宽带等非固定专线网络),每次服务器重启或者网络连接中断后重新连接时,ISP(互联网服务提供商)可能会分配一个新的公网 IP 地址,而对于云服务器,如果在云服务提供商的控制台中对服务器的网络配置进行了调整(如更换弹性公网 IP、调整网络策略等),也可能导致公网 IP 地址发生改变,不过,对于一些使用固定专线接入的企业级服务器,其公网 IP 地址通常是相对固定的,除非主动申请变更或者网络服务提供商那边进行网络结构调整等情况才会导致变化。