中国万网如何通过专业服务器托管服务确保网站的安全性和稳定性?

- 行业动态

- 2024-10-19

- 8

专业服务器托管服务,保障网站安全稳定

1、共享服务器托管

适用对象:个人网站、小型企业以及需要低成本托管的客户。

特点:多个客户共同使用一台服务器的硬件资源和带宽,价格低廉且部署迅速。

优点:价格实惠、部署快速。

缺点:性能和带宽受限,适合流量较小或对高性能要求不高的网站。

2、独立服务器托管

适用对象:大型企业网站、电商平台等对性能和灵活性要求高的客户。

特点:租用一台独立的物理服务器,拥有全部控制权限和独占的带宽与硬件资源。

优点:自由定制服务器配置和软件环境,具有更高的安全性和稳定性。

缺点:价格较高,但相对独立服务器托管提供了更强大的性能和灵活度。

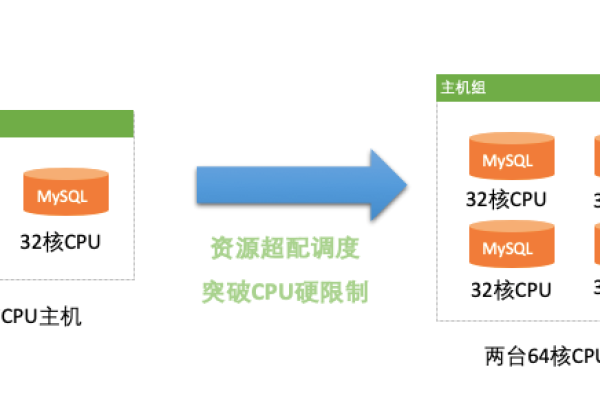

3、云服务器托管

适用对象:对弹性和可伸缩性有需求的客户,如网站流量波动大、临时需要扩容的站点。

特点:基于虚拟化技术,将一个物理服务器虚拟成多个云服务器,提供高度可弹性的资源调整能力。

优点:可根据需求随时调整服务器资源,如CPU、内存和存储空间。

缺点:相较于物理服务器,云服务器的性能可能受到一定限制。

4、CDN加速托管

适用对象:海量静态资源分发的客户,如视频站点、图片库等。

特点:通过全球分布的节点缓存静态资源,提高访问速度和响应效率。

优点:显著提升访问速度和用户体验,减轻源站服务器负载压力。

缺点:主要适用于静态内容的加速,动态内容效果有限。

5、安全与防护措施

防护安全:提供DDOS高级防护、CC攻击防御、Web网站防御、安全监控等服务,确保客户数据和信息的安全性。

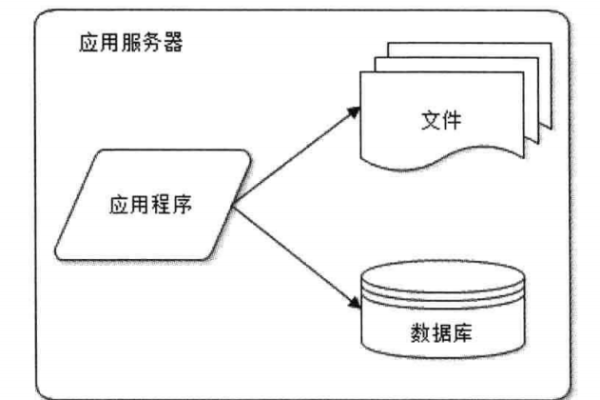

数据备份:提供稳定的数据备份服务,实现自动备份和灾难恢复功能,保障数据完整性和业务连续性。

压力测试:通过压力测试服务,帮助客户测试和提升服务器和网站的性能和稳定性。

安全加固:采用先进的管理技术和方案,持续改进安全保障措施,提高服务器的安全性和稳定性。

中国万网凭借其多样化的服务器托管方式、全面的安全防护措施以及高效的技术支持服务,为企业和个人客户提供了稳定可靠的网站托管解决方案,无论是小型网站还是大型企业平台,都能在中国万网找到适合自身需求的托管服务。

到此,以上就是小编对于“中国万网:专业服务器托管服务,保障网站安全稳定 (中国万网的服务器托管方式)”的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位朋友在评论区讨论,给我留言。