为何对象存储不适用于随机读写操作?HDFS应用开发中应如何应对?

- 行业动态

- 2024-08-12

- 1

对象存储不适用于随机读写,因此在进行HDFS应用开发时,建议避免使用 对象存储。可以考虑使用其他更适合 随机读写的存储系统,如分布式文件系统或块存储等。

对象存储不适用于随机读写

对象存储系统设计用于处理大量的数据,特别是在数据不需要频繁修改的环境中,这种类型的存储系统通常优化了写入操作,使其成为添加大量数据的理想选择,当涉及到随机访问和修改数据时,对象存储的性能可能不如其他类型的存储系统。

为什么对象存储不适用于随机读写?

数据访问模式

顺序访问优化:对象存储通常优化了对大规模数据集的顺序读写操作,这种优化使得它非常适合于批量数据操作,如备份、归档和数据湖的构建,在处理这些任务时,数据以较大的块为单位进行读写,而不是随机访问单个数据项。

高延迟的随机访问:由于对象存储的设计,随机访问数据时可能会遇到较高的延迟,这是因为系统内部的数据组织和管理方式更注重于优化大容量数据的存取效率,而非快速检索或修改单个数据对象。

技术架构限制

数据读写模型:对象存储系统通常采用平坦的结构来存储数据,其中每个对象都是独立存储的,这种结构简化了存储的管理,但同时也意味着缺乏传统文件系统那样的层次结构和随机访问能力。

一致性与并发控制:在需要高并发和一致性保证的应用场景(如数据库和实时处理系统)中,对象存储可能不是最佳选择,这是因为对象存储系统往往通过时间戳或版本控制来处理数据更新,这可能导致在高并发写操作下性能下降。

经济性考虑

成本效益:对于需要频繁读写的应用场景,使用对象存储可能不是最经济的选择,虽然对象存储的价格对于长期存储和档案保存来说较为合理,但其在频繁读写操作上的性能不足可能导致额外的成本。

替代方案的优势:对于需要高性能随机读写的应用,块存储或专用的文件系统可能是更合适的解决方案,这些系统设计用来支持高速的数据访问和修改,尽管它们的价格可能高于对象存储。

HDFS应用开发建议

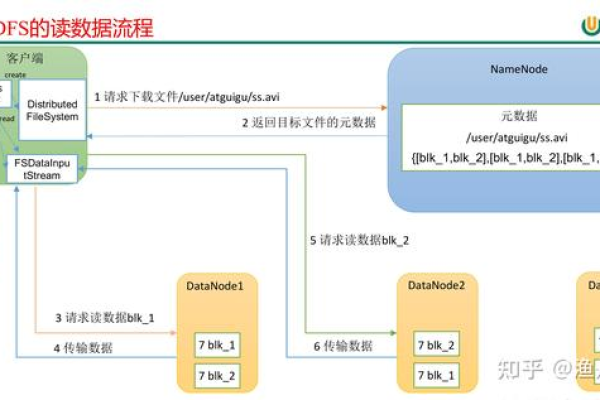

Hadoop Distributed File System(HDFS)是专为大规模数据集设计的文件系统,特别适用于Apache Hadoop框架,HDFS的设计强调数据的高吞吐量和容错能力,适合用于批量数据处理。

HDFS的核心特性

高容错性:HDFS能够在多个硬件故障的情况下保持数据完整性,它通过数据冗余复制来实现这一点,通常是将每个文件分割成多个块,并在集群的不同节点上存储这些块的副本。

适合大数据处理:HDFS可以处理PB级别的数据集,这使得它成为进行大数据分析,如数据挖掘和日志分析等任务的理想选择。

开发注意事项

追加而非随机写:在HDFS中,文件一旦创建后,只能在其末尾追加数据,不支持随机位置的写入,这要求开发者在设计应用时,必须考虑到数据追加的特性。

高效读取策略:为了优化性能,开发者应当尽量进行顺序读取,并避免小规模的随机读操作,因为HDFS优化了对大规模数据集的顺序访问。

通过了解对象存储的限制及HDFS的特性和最佳实践,开发者可以更有效地设计和实现大数据应用,这不仅可以提高数据处理的效率,还可以确保系统的可扩展性和可靠性。

接下来将探讨一些相关的常见问题及其答案,以便更全面地理解和利用这两种存储系统的优势。

FAQs

HDFS是否适合实时数据处理?

HDFS不适合实时数据处理,HDFS的设计是为了处理大规模的批处理任务,而不是低延迟的实时数据访问,对于需要快速响应时间的实时数据处理,应考虑使用其他类型的存储系统,如NoSQL数据库或专用的实时数据处理平台。

如何选择合适的存储系统?

选择合适的存储系统应基于数据访问模式、性能需求和成本考虑,对于大规模、一次写入、多次读取的数据,对象存储是一个很好的选择,对于需要频繁更新的数据集,文件系统或块存储可能更为合适,还应该考虑数据的规模、访问频率和预算。

通过以上分析,可以得出上文归纳,每种存储技术都有其独特的优势和最适合的应用场景,理解这些特性将帮助更好地设计和部署数据处理解决方案。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/132251.html