如何有效统计非重复数据库中的唯一记录数量?

- 行业动态

- 2025-01-24

- 8

在当今数字化时代,数据管理成为了企业运营和决策的核心环节,特别是在处理大量信息时,确保数据的质量和准确性显得尤为重要。“count 非重复数据库”这一概念,是数据分析师和数据库管理员经常遇到并需要解决的问题之一,本文将深入探讨如何有效管理和计算非重复数据库中的记录数量,提供实用的方法和策略,以优化数据处理流程。

理解非重复数据库的重要性

非重复数据库指的是一个数据集内没有重复项的数据库,在实际应用中,重复数据不仅会浪费存储空间,还可能导致数据分析结果的偏差,影响业务决策的准确性,维护一个清洁、无重复的数据环境对于保持数据质量至关重要。

方法一:使用SQL语句进行去重计数

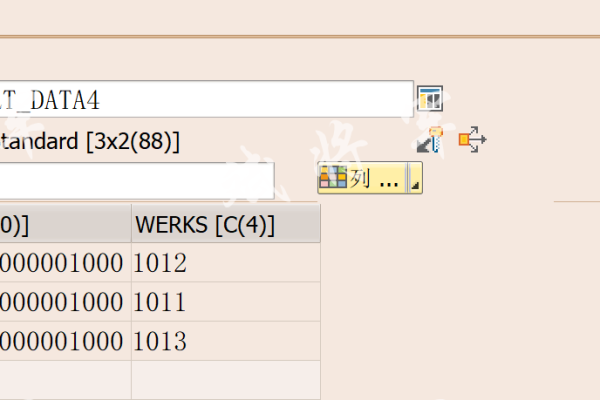

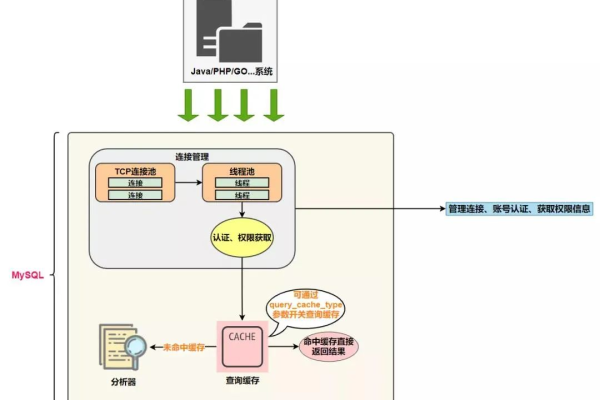

在关系型数据库管理系统(RDBMS)中,如MySQL、PostgreSQL等,可以通过SQL语句轻松实现对非重复记录的计数,最常用的方法是利用DISTINCT关键字结合COUNT函数,假设有一个名为users的表,包含字段user_id和email,要统计不同邮箱地址的用户数量,可以这样写SQL查询:

SELECT COUNT(DISTINCT email) AS unique_email_count FROM users;

这条语句会返回一个数字,表示表中不重复的邮箱地址总数。

方法二:利用编程语言处理

对于更复杂的数据处理需求,或者当数据存储在非关系型数据库(如NoSQL数据库)中时,可能需要借助编程语言如Python、Java等来手动实现去重逻辑,以Python为例,使用Pandas库可以高效地处理数据框中的重复行:

import pandas as pd

假设df是从数据库读取的数据框

df = pd.read_csv('data.csv')

unique_count = df['email'].nunique()

print(f"Unique email count: {unique_count}")

这里,nunique()函数直接返回指定列的非重复值数量。

方法三:使用数据库系统自带功能

一些现代数据库系统提供了内置的去重和计数功能,比如MongoDB的聚合框架,以下是一个MongoDB的例子,用于统计集合中唯一文档的数量:

db.users.aggregate([

{ $group: { _id: "$email" } },

{ $count: "unique_email_count" }

]);

这段代码首先按email字段分组,然后计算分组后的数量,即得到不同邮箱的数量。

表格示例:不同方法比较

| 方法 | 适用场景 | 优点 | 缺点 |

SQLDISTINCT |

关系型数据库 | 简单快速,易于理解 | 仅限于基本去重需求 |

| 编程语言处理 | 复杂数据处理,非关系型数据库 | 灵活性高,可定制性强 | 需要编程知识 |

| 数据库自带功能 | 特定数据库系统 | 高效利用系统特性 | 可能受限于特定数据库功能 |

FAQs

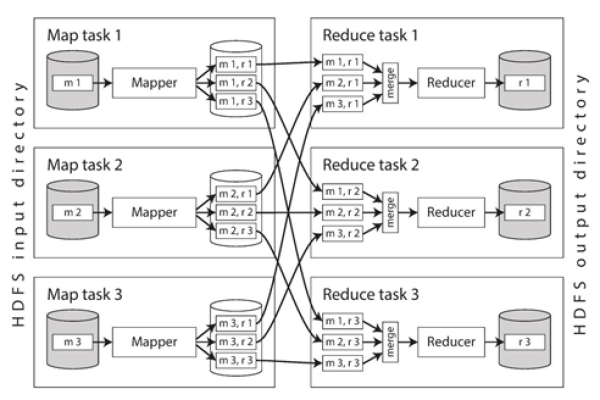

Q1: 如果数据量非常大,哪种方法更高效?

A1: 对于超大规模数据,推荐使用数据库自带的优化功能或分布式计算框架(如Hadoop、Spark),因为它们专为大数据设计,能更有效地处理和分析海量数据。

Q2: 如何处理实时数据流中的非重复计数?

A2: 对于实时数据流,可以考虑使用流处理框架如Apache Kafka配合Flink或Spark Streaming,这些技术能够实时处理流入的数据,并通过窗口函数等机制实现动态的去重计数。

小编有话说

在数据驱动的时代,掌握有效的数据管理技巧是每个数据工作者的必备技能,无论是通过简单的SQL查询还是借助强大的编程语言和工具,合理地去重和计数不仅能提升数据处理效率,还能确保分析结果的准确性,为企业决策提供坚实的数据支持,希望本文的介绍能帮助大家更好地理解和应用“count 非重复数据库”的相关技术,让数据管理变得更加得心应手。