什么是bitblt技术,它在计算机图形处理中扮演什么角色?

- 行业动态

- 2024-08-20

- 6

BitBlt的基本功能与应用

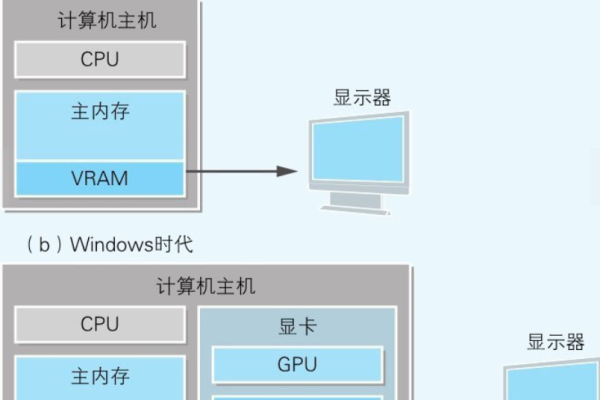

BitBlt是一个在计算机图形处理中常见的API函数,主要用于位图的传输和复制,这个函数可以在不同设备环境(Device Contexts, DC)之间进行像素数据的快速移动和复制,广泛应用于图形设计、游戏开发和多媒体处理等领域,BitBlt的基本作用是从源设备环境中的一个区域复制像素到目标设备环境的相应位置,实现高效的图像传输。

BitBlt函数的主要功能是将一个设备上下文中的像素矩形区域复制到另一个设备上下文中,该函数通过快速传输和渲染像素数据来优化图形操作,确保图像在复制过程中的质量和速度,这种操作对于需要大量图像处理和实时更新的应用尤为重要,如视频游戏的实时渲染或动态图形的生成。

BitBlt的操作过程涉及两个主要部分:源设备环境和目标设备环境,源设备环境(Source Device Context, hdcSrc)是像素数据被复制的起始位置,而目标设备环境(Destination Device Context, hdcDest)是接收这些数据的位置,BitBlt通过定义这两个设备环境的坐标和大小来精确控制传输过程。

BitBlt的核心优势在于其传输速度和效率,由于它直接作用于硬件级别,因此能够以最小的CPU负担完成高速的数据处理,这一点对于需要处理复杂图形和动态内容的现代应用程序尤其重要。

BitBlt函数虽然高效,但在使用时需要注意一些关键参数的正确设置,开发者需要确保源和目标的尺寸一致,以防止图像失真或者数据丢失,选择合适的光栅操作(raster operation, RO_OP)可以进一步优化像素的处理方式,比如选择覆盖、合并或异或等操作,以适应不同的图形需求。

除了基本的图片传输外,BitBlt还可以用于高级的图形处理技术,如图像合成和特效处理,在图像编辑软件中,BitBlt可以用来快速合成多层图像,或者在游戏开发中实现特殊效果,如动态阴影或光影效果。

BitBlt函数不仅在技术上具有重要意义,而且在实际应用中也展现了广泛的适用性,从桌面应用到移动游戏,从工业设计到媒体制作,BitBlt都是实现高质量图形处理的关键工具。

相关问答FAQs

Q1: BitBlt函数在现代图形处理中还有必要使用吗?

A1: 尽管现代图形处理技术已经发展出更多高级的图形API,如OpenGL和DirectX,但BitBlt因其简单、高效的特点,在不需要复杂图形处理的场景下仍然非常有用,特别是在快速原型开发或轻量级图形应用中,BitBlt可以提供一种便捷的解决方案。

Q2: BitBlt函数能否跨平台使用?

A2: BitBlt函数主要在Windows操作系统中使用,特别是在和GDI (Graphics Device Interface)相关的应用中,在其他操作系统如macOS或Linux中,可能需要寻找或定制类似的替代方案来实现相同的功能,因此并不是跨平台的。