解决大数据文件读取错误,有哪些正确的读取方法?

- 行业动态

- 2024-07-31

- 2

当遇到大数据文件读取报错时,首先确认文件格式与编码无误,然后选择合适的读取工具和方法。如使用Pandas库分块读取大CSV文件,或调整内存分配和硬件配置以支持大文件处理。确保数据预处理步骤正确,避免因格式或内容错误导致读取失败。

在大数据领域,读取文件是一项基础而重要的操作,当遇到读取文件报错时,我们需要系统地诊断和解决问题,以下是正确读取文件的步骤和常见错误的解决方案。

理解文件格式和数据结构

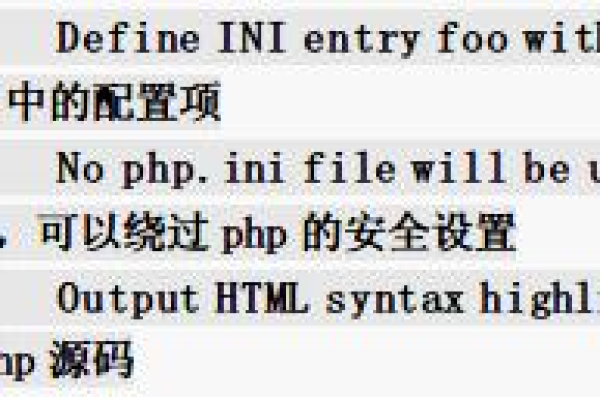

了解你要读取的文件类型和数据结构至关重要,大数据环境中常见的文件格式包括CSV、JSON、Parquet、ORC等,每种格式都有其特定的读取方式和工具,CSV文件可以使用pandas库轻松读取,而Parquet文件则可能需要使用PySpark或Hadoop生态系统中的其他工具。

选择合适的读取工具

根据文件的大小和格式,选择适当的读取工具,对于小到中等大小的文件,Python的pandas库是一个不错的选择,但对于大型文件,可能需要使用Apache Spark之类的分布式计算框架。

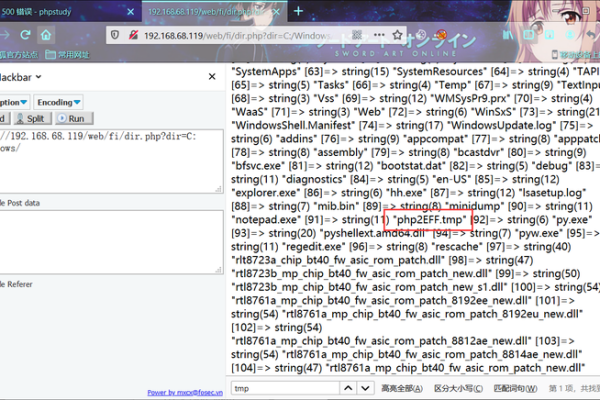

检查文件路径和权限

确保你拥有正确的文件路径和读取该文件的权限,错误的文件路径或缺少读取权限是常见的错误原因,在Linux系统中,可以使用ls命令检查文件路径,使用chmod和chown命令修改文件权限和所有权。

设置合适的内存和硬件资源

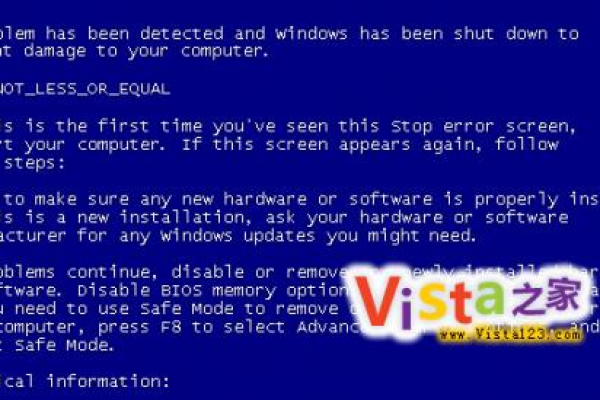

对于大文件,要确保你的计算机或服务器具有足够的内存和计算资源,如果资源不足,可能会导致读取失败或系统崩溃,在本地机器上,你可能需要关闭其他应用程序来释放资源,在集群环境中,可以调整分配给任务的资源量。

逐步调试和验证

1、开始前验证:在尝试读取之前,先验证文件是否完整无损,无错误。

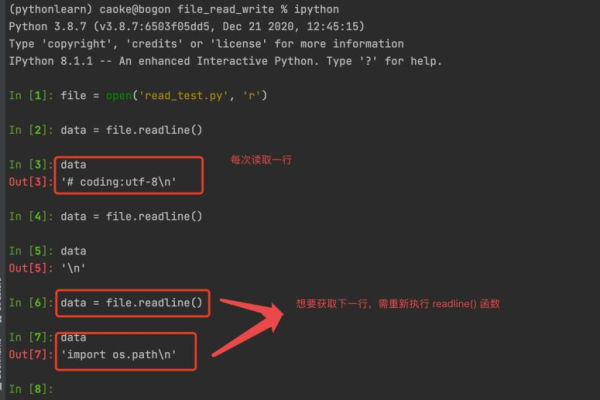

2、增量测试:先尝试读取文件的一小部分,如果这部分可以成功读取,再逐渐增加读取的数据量。

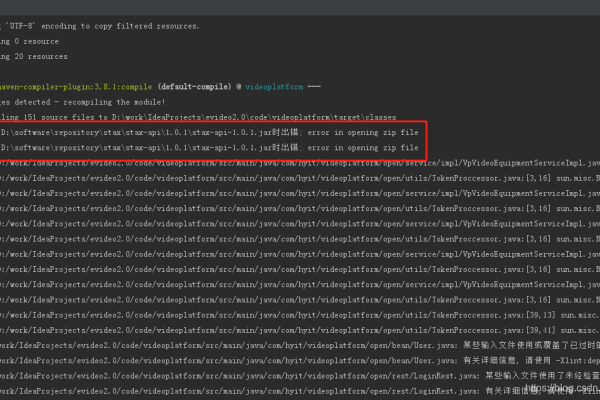

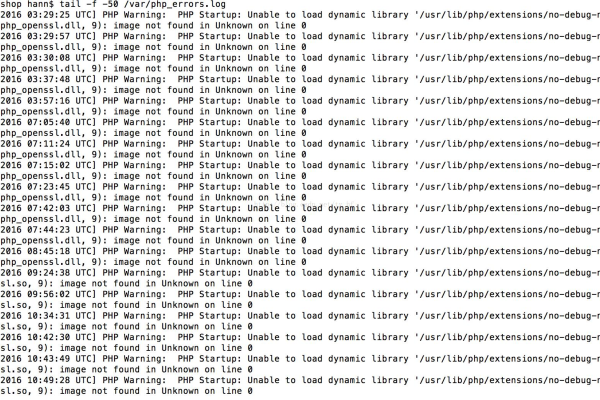

3、错误日志:关注错误日志,它们通常能提供关于出错位置和原因的线索。

4、参数调优:根据读取过程中的表现调整内存分配、并发度和其他相关参数。

处理常见错误

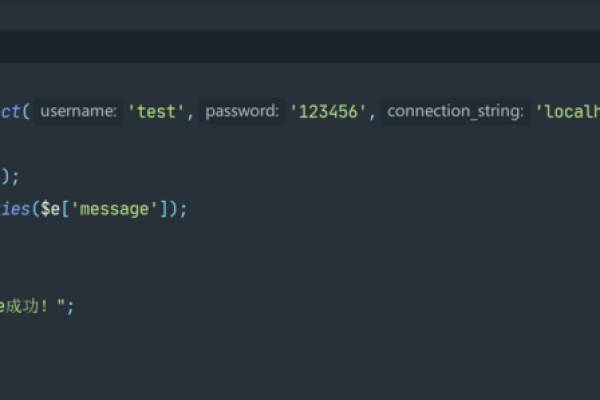

编码问题:如果遇到编码错误,确认文件的字符编码,并在读取时指定正确的编码格式。

内存溢出:减少每次读取的数据量,或者在读取大文件时使用流式处理。

数据格式不匹配:确保读取工具的设置与文件的数据结构相匹配。

性能优化

并行处理:利用多线程或分布式系统的并行处理能力来加速读取过程。

压缩文件:读取压缩后的文件可以节省I/O和网络传输时间,尽管这可能会增加CPU的使用率。

列式存储:使用列式存储格式(如Parquet)可以加快读取速度,特别是在执行列查询时。

监控和记录

监控工具:使用监控工具来跟踪读取操作的性能,包括内存使用、CPU负载和I/O操作。

日志记录:记录详细的日志信息,以便在出现问题时能够快速定位和解决。

相关问答FAQs

Q1: 如果读取大文件时出现内存溢出错误,我该如何解决?

A1: 内存溢出通常是因为一次性加载了过多的数据到内存中,你可以尝试以下方法来解决:

分批读取:将大文件分成多个小块,分批次读取。

使用迭代器:在Python中,可以使用生成器表达式或Pandas的read_csv函数的chunksize参数来逐块读取数据。

分布式处理:如果可能,使用Apache Spark等分布式处理框架,它可以将数据分布在多个节点上进行处理。

Q2: 当我尝试读取一个损坏的JSON文件时,应该如何处理?

A2: 损坏的JSON文件可能导致解析错误,你可以采取以下措施:

预处理文件:使用工具或脚本尝试修复损坏的JSON文件,例如通过删除不完整的行或对象。

容错读取:使用能够处理不规范JSON的库,如Python的json5库,它对JSON格式更加宽容。

手动清理:如果上述方法无效,可能需要手动打开文件并清理掉损坏的部分。

归纳而言,正确读取文件需要对文件格式有深入的了解,选择合适的工具,确保有足够的资源,并通过逐步调试和性能优化来应对各种挑战,面对特定错误时,有条不紊地诊断和解决问题是关键。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:https://www.xixizhuji.com/fuzhu/127307.html