安全网关服务器如何保护网络免受威胁?

- 行业动态

- 2024-08-13

- 2

安全网关服务器,也被称为安全Web网关(SWG),是网络安全领域中的一个关键组成部分,小编将深入探讨安全网关服务器的定义、功能、模式及其与堡垒机的区别,以便全面理解其重要性和作用。

定义和核心目的

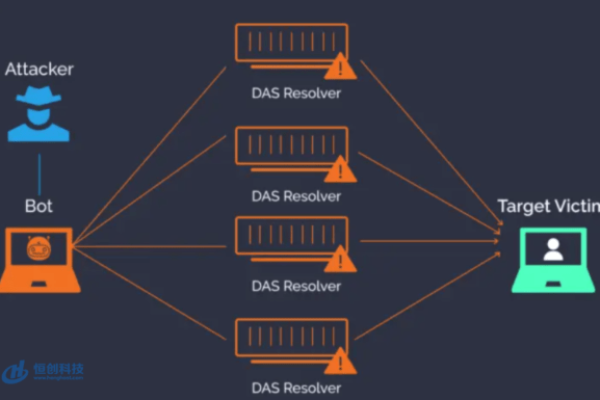

安全网关服务器充当着企业内部网络与外部互联网之间的保护屏障,其主要目的是监控、过滤并保护网络流量,防止不安全的因素侵入内部网络,确保企业数据的安全。

主要功能

内容过滤:安全网关服务器能够基于企业设定的安全策略对Web流量进行内容过滤,阻挡那些可能含有反面软件或不符合政策的网络请求。

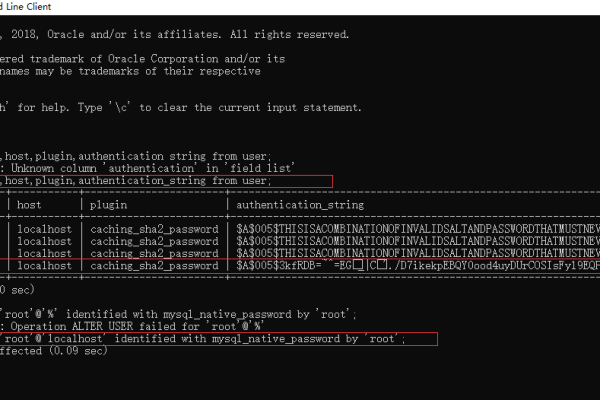

身份验证:通过实施身份验证机制,安全网关确保只有授权用户才能访问网络资源,从而增强安全性。

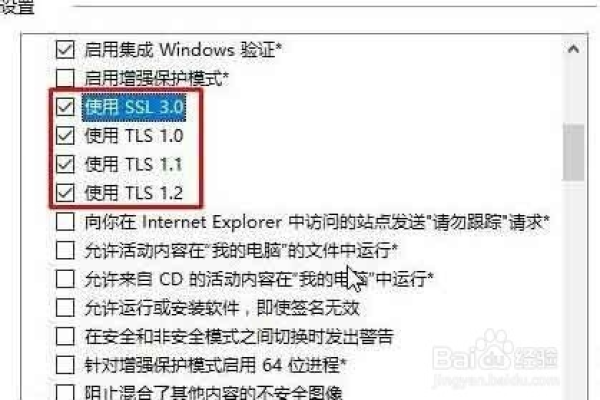

数据加密解密:为了保护数据传输的安全,安全网关可以对数据进行加密和解密处理,防止敏感信息在传输过程中被窃取或改动。

访问控制:通过访问控制列表(ACL)或其他方法,安全网关能够限制特定用户或用户组访问特定的网络资源,进一步加强安全防护。

模式

网桥模式:在此模式下,安全网关服务器作为一个透明的桥梁,连接两个网络,并在它们之间传递数据包时执行安全策略检查。

网关模式:作为网络的进出口,所有进出的数据都必须通过安全网关,它执行更严格的安全检查和数据处理。

安全网关与堡垒机的区别

功能范围:安全网关专注于阻止干扰载入和网络攻击,而堡垒机则提供运维安全审计功能,不仅保障网络安全,还能进行安全审计和其他相关操作。

应用场景:安全网关适用于所有需要网络边界保护的场景,堡垒机则更多应用于需要详细审计和控制的高安全级别环境。

相关问题与解答

安全网关能否完全替代防火墙?

答:虽然安全网关具有许多与防火墙相似的功能,如包过滤和访问控制,但它通常不能替代防火墙,防火墙主要用于阻止未经授权的网络访问,而安全网关则提供更全面的保护,包括内容过滤、威胁检测等,两者结合使用能提供更强大的安全保障。

如何选择合适的安全网关产品?

答:选择安全网关产品时,应考虑以下因素:确定企业的安全需求和预算;评估产品的安全功能是否满足这些需求;考虑产品的易用性和维护支持,选择有良好市场声誉和定期更新的产品也很重要,以确保能够应对新出现的威胁。

随着网络威胁的日益复杂化,安全网关服务器在保护企业网络安全方面发挥着越来越重要的作用,通过了解其工作原理和功能,组织可以更好地配置和利用这一关键的安全组件,以保护其资产免受网络攻击和数据泄露的风险。