什么是人工鱼群算法?

- 行业动态

- 2024-12-15

- 3138

人工鱼群算法(Artificial Fish Swarm Algorithm,AFSA)是一种基于模拟鱼群行为的群体智能优化算法,该算法通过模仿鱼群的觅食、聚群和追尾等行为,实现全局最优解的搜索,以下是对人工鱼群算法的详细描述:

基本原理

1、初始化:设定鱼群数量N,每条鱼的位置Xi和当前食物浓度F(Xi),设置视觉范围Vvisual、步长Sstep、拥挤因子δ和尝试次数Ttry。

2、觅食行为:每条鱼在其视野范围内随机选择一个参考点Xj,如果该点的食物浓度优于当前位置,则向该点移动一定距离;否则继续在视野内巡视其他位置。

3、聚群行为:如果当前鱼群拥挤度ni/N<δ,则说明伙伴中心处的食物浓度大且不存在拥挤,此时需要向伙伴中心移动;否则执行觅食行为。

4、追尾行为:如果当前鱼群拥挤度ni/N<δ且f(xmax) > f(xi),则向最优邻居状态xmax移动;否则执行觅食行为。

5、更新公告板:根据鱼群的寻优记录,寻找当前的历史最佳位置xgbest,并将其作为全局最优解。

改进策略

为了提高算法的收敛速度和全局最优值寻优效率,可以采用以下改进策略:

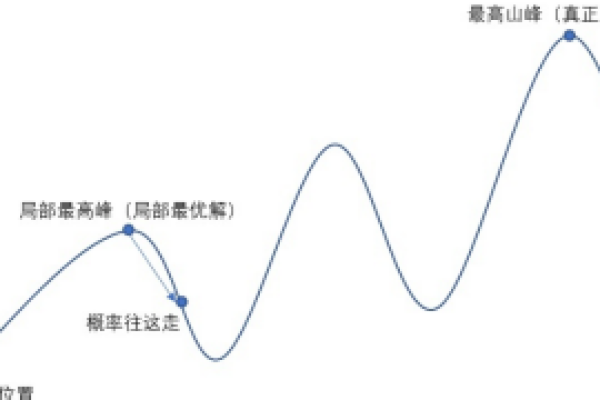

1、双群人工鱼群算法:引入两个鱼群,主鱼群和辅助鱼群,分别负责全局搜索和局部搜索,以解决多峰函数问题。

2、步长自适应调整:根据当前迭代情况动态调整步长,避免陷入局部最优解。

3、精英保留策略:将历史上的优秀个体保留下来,防止算法陷入局部最优。

4、混合算法:结合遗传算法(GA)和人工鱼群算法(AFSA),利用GA的全局搜索能力和AFSA的快速收敛特性。

应用领域

人工鱼群算法具有广泛的应用领域,包括但不限于以下几个方面:

1、电力系统规划:用于输电网规划,构建最佳电网结构以满足经济可靠地输送电能的要求。

2、物流中转运输系统优化:解决多级梯阶物流中转运输系统的优化问题,提高物流效率。

3、资源均衡与数据挖掘:在资源分配和数据挖掘等领域也有广泛应用,如模糊聚类、扩频码估计、DNA编码序列优化等。

4、信号处理与图像处理:在信号处理和图像处理领域,AFSA可用于改进神经网络和作业调度等任务。

FAQs

Q1: 人工鱼群算法的主要优势是什么?

A1: 人工鱼群算法的主要优势包括具有较快的收敛速度,可以用于解决有实时性要求的问题;对于一些精度要求不高的场合,可以用它快速得到一个可行解;不需要问题的严格机理模型,甚至不需要问题的精确描述,这使得它的应用范围得以延伸。

Q2: 如何判断人工鱼群算法是否达到停止条件?

A2: 判断停止条件的方法有多种,包括判断连续多次所得的均方差小于允许的误差;判断某个区域的人工鱼群数目达到某个比率;连续多次所获取的值均不能超过已找到的极值;以及迭代次数达到预设次数。

小编有话说

人工鱼群算法作为一种新兴的群体智能优化算法,其独特的模拟鱼群行为的方式为解决复杂优化问题提供了新的思路,随着算法的不断改进和应用范围的扩大,相信人工鱼群算法将在更多领域展现出其强大的优化能力,我们也期待更多的研究者能够加入到这一领域的研究中来,共同推动群体智能优化算法的发展。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/125768.html