一个公司网站建设需要多少钱?

- 行业动态

- 2024-11-05

- 7

一个公司网站的开发和运营成本因多种因素而异,包括网站的类型、功能复杂度、设计需求、技术栈选择、内容管理系统(CMS)的选择、域名和托管服务费用等,下面将详细分析这些因素,并提供一些估算价格的范围。

网站类型与成本

不同类型的网站有不同的开发和维护成本,以下是几种常见类型的公司网站及其大致成本范围:

1、基础信息展示网站:主要用于展示公司信息、产品或服务介绍,这类网站通常包含首页、关于我们、产品/服务、联系我们等基本页面,成本大约在¥5,000 ¥20,000之间,具体取决于设计和定制程度。

2、电子商务网站:用于在线销售产品或服务,除了基本信息展示外,还需要集成购物车、支付系统、用户账户管理等功能,成本范围较广,从¥30,000到¥100,000甚至更高,取决于功能的复杂性和交易量预期。

3、门户网站或社区论坛:提供大量动态内容和用户交互的平台,这类网站需要复杂的数据库设计、用户认证系统、内容管理系统等,成本可能在¥100,000以上,具体取决于规模和功能需求。

4、定制化企业应用平台:根据特定业务流程定制开发的网站,如CRM系统、ERP系统等,这类项目的成本非常高,可能需要¥500,000甚至更多,具体取决于项目的复杂度和开发周期。

功能复杂度与成本

网站的功能复杂度直接影响开发成本,以下是一些常见功能及其对成本的影响:

响应式设计:确保网站在不同设备上都能良好显示,这是现代网站的标准要求,通常会增加一定的设计和开发成本。

多语言支持:如果网站需要支持多种语言,需要进行额外的翻译和本地化工作,成本会相应增加。

搜索引擎优化(SEO):为了提高网站在搜索引擎中的排名,需要进行关键词研究、内容优化、链接建设等工作,这也会增加成本。

安全性增强:对于处理敏感信息的网站,如电商网站或企业内部系统,需要采取额外的安全措施,如SSL证书、数据加密等,这些都会增加成本。

设计与开发成本

网站的设计和开发是成本的主要组成部分,以下是一些影响设计和开发成本的因素:

设计师和开发人员的资质:经验丰富的设计师和开发人员通常收费更高,但能提供更高质量的服务。

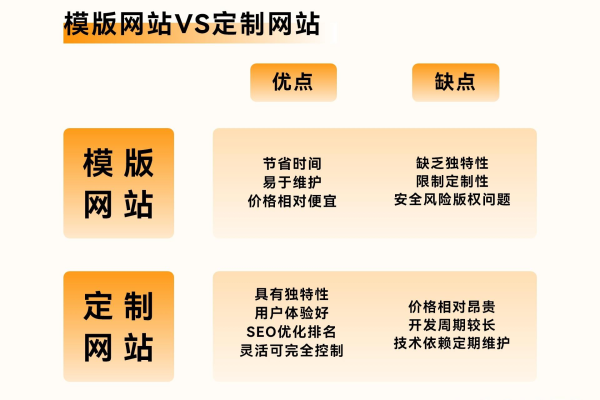

自定义设计 vs 模板:自定义设计需要更多的时间和创意投入,因此成本较高;而使用模板则可以降低成本,但可能牺牲一定的个性化和独特性。

前端与后端开发:前端开发关注用户界面和用户体验,后端开发则负责服务器端逻辑和数据库管理,两者都是必要的,且都需要专业技能。

选择合适的CMS可以大大简化网站的维护和管理过程,以下是一些流行的CMS及其特点:

WordPress:开源且易于使用,适合大多数类型的网站,有大量的插件和主题可供选择,但可能需要额外的安全和维护工作。

Drupal:功能强大且灵活,适合复杂和大型网站,学习曲线较陡,需要更多的开发资源。

Joomla:介于WordPress和Drupal之间,提供了良好的灵活性和易用性平衡。

定制CMS:对于有特殊需求的企业,可能需要从头开始开发定制的CMS,这将大大增加成本。

域名和托管服务费用

域名和托管服务是网站运行的基础,以下是一些常见的费用范围:

域名注册:通常每年的费用在¥50 ¥300之间,具体取决于域名后缀和注册商。

托管服务:共享托管是最经济的选择,每年的费用大约在¥300 ¥3,000之间;VPS或专用服务器则更贵,每年可能需要¥3,000 ¥10,000或更多。

维护与更新成本

网站的维护和更新是持续的过程,包括内容更新、软件升级、安全监控等,以下是一些维护成本的考虑因素:

内容更新:定期添加新内容或修改现有内容,保持网站的活跃度和相关性。

软件升级:随着技术的发展,CMS和插件可能需要定期更新以修复破绽和添加新功能。

安全监控:防止破解攻击和数据泄露,需要实施安全措施并进行定期的安全审计。

一个公司网站的总成本可以从几千元到几十万元不等,具体取决于上述提到的各种因素,在规划网站时,重要的是明确业务需求、预算范围和期望的功能特性,以便做出合理的决策。

FAQs

Q1: 我应该如何选择适合我业务的网站类型?

A1: 选择适合您业务的网站类型需要考虑您的业务目标、客户群体和技术能力,如果您的业务主要是线下服务,那么一个基础的信息展示网站可能就足够了;如果您打算在线销售产品,那么需要一个电子商务网站;如果您的业务需要大量的用户互动和内容更新,那么门户网站或社区论坛可能更适合,建议与专业的网站开发公司或顾问进行咨询,以便根据您的具体需求做出最佳选择。

Q2: 如何控制网站开发和维护的成本?

A2: 控制网站开发和维护成本的方法有很多,以下是一些建议:

明确需求:在项目开始前,尽可能详细地定义您的需求和预期结果,避免在开发过程中频繁变更需求导致成本增加。

选择合适的CMS:选择一个适合您需求的CMS可以节省大量的开发和维护时间。

使用模板和插件:对于不需要高度定制化的功能,可以使用现成的模板和插件来减少开发工作量。

定期维护:通过定期的维护和更新来预防潜在的问题和破绽,避免因紧急修复而导致的额外成本。