遇到DNS错误时,应该如何快速诊断和解决?

- 行业动态

- 2024-12-11

- 2532

DNS(Domain Name System,域名系统)是互联网中不可或缺的一部分,它负责将人类容易记忆的域名转换为计算机能够理解的IP地址,在实际应用中,DNS错误时有发生,给用户带来诸多不便,本文将详细探讨DNS错误的各种表现、原因及解决方法,并提供一些实用的FAQs供读者参考。

一、DNS错误的表现

1、无法访问特定网站:最常见的DNS错误表现为用户无法通过域名访问特定的网站,但可以通过IP地址正常访问,尝试访问www.example.com时,浏览器提示“无法找到网页”,而直接输入该网站的IP地址则可以正常访问。

2、访问速度变慢:有时DNS错误并不会导致完全无法访问,而是使访问速度变得异常缓慢,这可能是由于DNS服务器响应时间过长或DNS缓存被被墙等原因造成的。

3、跳转到错误页面:在某些情况下,DNS错误可能导致用户被重定向到错误的网页,甚至是反面网站,这通常是由于DNS劫持或DNS缓存中毒等安全问题引起的。

4、网络连接不稳定:频繁的DNS错误可能导致网络连接不稳定,表现为间歇性的断网或访问失败。

二、DNS错误的原因

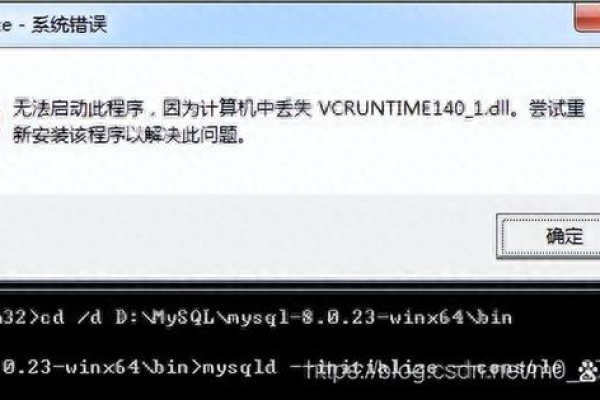

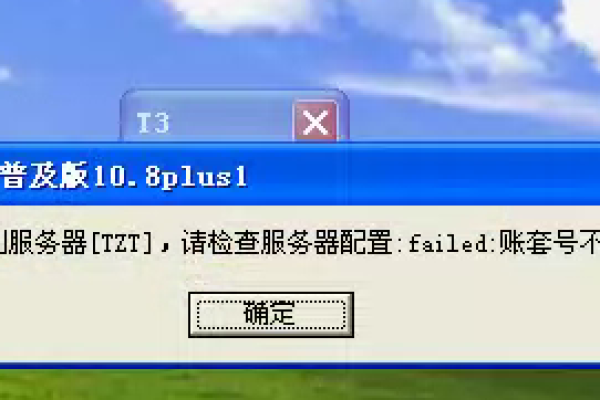

1、DNS服务器配置错误:本地计算机或网络设备的DNS服务器设置可能不正确,导致无法正确解析域名。

2、DNS服务器故障:如果使用的DNS服务器出现故障或宕机,也会导致DNS解析失败。

3、网络连接问题:网络连接不稳定、路由器故障或信号干扰等问题都可能影响DNS解析的正常进行。

4、防火墙或安全软件阻止:某些防火墙或安全软件可能会错误地阻止DNS查询或响应,导致DNS解析失败。

5、干扰或反面软件改动:计算机中的干扰或反面软件可能会改动DNS设置,导致DNS解析出错。

6、DNS缓存被墙:DNS缓存中存储了过时或错误的解析记录,导致后续访问时出现错误。

三、解决DNS错误的方法

1、检查并修复网络连接:确保网络连接正常,尝试重新启动路由器和调制解调器等网络设备,如果问题仍然存在,可以尝试使用其他网络设备(如手机热点)进行测试,以确定问题是否出在网络设备上。

2、更改DNS服务器设置:尝试更换为公共DNS服务器(如Google的8.8.8.8和8.8.4.4),以避免因电信运营商DNS劫持或其他问题导致的解析故障,在Windows系统中,可以通过“控制面板”->“网络和共享中心”->“更改适配器设置”->“右键点击当前网络连接”->“属性”->“双击Internet协议版本4 (TCP/IPv4)”来更改DNS服务器设置。

3、清除DNS缓存:在Windows系统中,可以使用命令提示符(CMD)输入“ipconfig /flushdns”命令来清除DNS缓存,这将删除所有存储在本地计算机上的DNS解析记录,并迫使计算机在下次访问时重新查询DNS服务器。

4、修改HOSTS文件:HOSTS文件是一个没有扩展名的系统文件,它包含了IP地址和Host name(主机名)的对应关系,通过修改HOSTS文件,可以将特定的域名与IP地址绑定,从而实现绕过DNS服务器直接访问的目的,但请注意,这种方法仅适用于少数情况,且需要谨慎操作以避免误修改。

5、检查并关闭防火墙或安全软件:如果怀疑防火墙或安全软件阻止了DNS查询或响应,可以尝试暂时关闭它们以排除故障,但请注意,这样做可能会降低计算机的安全性,因此请务必小心行事并在完成后重新启用防火墙和安全软件。

6、杀毒并更新系统:使用杀毒软件对计算机进行全面扫描和清理,以确保没有干扰或反面软件改动DNS设置,保持操作系统和应用程序的更新也是预防DNS错误的重要措施之一。

四、FAQs

Q1: 如何判断是否是DNS错误导致的无法访问?

A1: 可以通过ping命令来测试,如果ping域名时返回“请求超时”或“无法访问目标主机”等错误信息,而ping IP地址则正常响应,那么很可能是DNS错误导致的无法访问。

Q2: 更换DNS服务器后仍然无法访问怎么办?

A2: 如果更换DNS服务器后仍然无法访问,可以尝试清除DNS缓存、检查网络连接和防火墙设置、修改HOSTS文件以及杀毒等方法来进一步排查和解决问题,如果以上方法均无效,建议联系网络服务提供商或专业技术支持人员寻求帮助。

Q3: 如何预防DNS错误?

A3: 为了预防DNS错误,可以定期检查并维护网络设备、保持操作系统和应用程序的更新、使用可靠的DNS服务器以及安装杀毒软件等安全软件来保护计算机免受干扰和反面软件的攻击,还可以考虑使用多个DNS服务器进行备份以提高解析的可靠性和稳定性。

DNS错误是网络使用中常见的问题之一,但通过合理的排查和解决方法我们可以有效地应对这些问题并恢复网络的正常访问,希望本文能对您有所帮助!

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/125176.html