如何在Mac上搭建并配置FTP服务器?

- 行业动态

- 2025-01-03

- 10

在Mac上搭建FTP服务器,可使用vsftpd软件。先安装vsftpd,再编辑配置文件,设置用户权限和目录,最后启动服务即可。

在Mac上搭建FTP服务器可以通过多种方法实现,以下是其中一种常见的方法:

1、打开系统偏好设置:点击屏幕左上角的苹果图标,选择“系统偏好设置”。

2、进入共享设置:在系统偏好设置窗口中,找到并点击“共享”选项。

3、启用文件共享:在共享选项卡中,勾选“文件共享”选项,这将启用Mac上的文件共享功能,使其他设备可以通过网络访问你的文件。

4、添加共享文件夹:点击“选项”按钮,然后选择要共享的文件夹,你可以选择所有用户或指定用户访问,根据需要设置权限。

5、设置用户访问权限:在“文件共享”选项中,点击“+”按钮,添加要使用FTP访问的用户,你可以输入现有的用户名和密码,或者创建新的用户。

6、启用FTP访问:在文件共享选项卡中,点击“选项”按钮,在弹出的窗口中,确保“共享文件和屏幕使用FTP”选项已被勾选。

7、获取FTP服务器地址:在共享选项卡中,会显示FTP服务器的地址,这是你的本地FTP服务器地址,可以通过其他设备的FTP客户端访问。

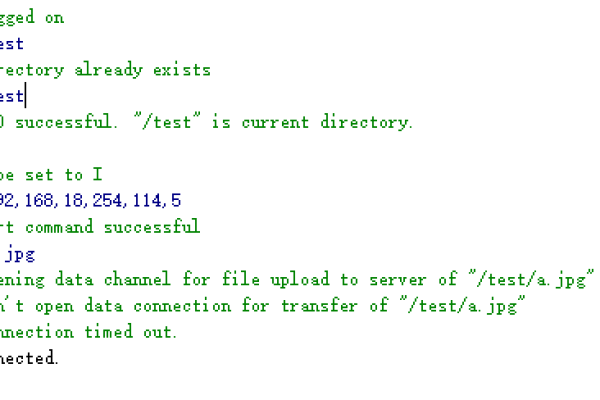

8、连接到FTP服务器:在其他电脑上使用FTP客户端软件(如FileZilla)输入Mac的IP地址、FTP用户名和密码,即可访问共享的文件夹。

9、注意事项:确保你的Mac和其他设备在同一个局域网中,以便能够进行网络访问,如果使用了防火墙软件,请确保已正确设置允许FTP访问,当你不需要再分享文件夹时,记得及时取消文件共享,以确保安全性。

步骤提供了在Mac上搭建FTP服务器的基本指南,通过这些步骤,你可以在Mac上轻松搭建FTP服务器,并进行文件共享和传输,如果你有进一步的问题或需要更详细的指导,请随时提问。